《MATLAB 神经网络43个案例分析》:第17章 基于SVM的信息粒化时序回归预测——上证指数开盘指数变化趋势和变化空间预测

1. 前言

《MATLAB 神经网络43个案例分析》是MATLAB技术论坛(www.matlabsky.com)策划,由王小川老师主导,2013年北京航空航天大学出版社出版的关于MATLAB为工具的一本MATLAB实例教学书籍,是在《MATLAB神经网络30个案例分析》的基础上修改、补充而成的,秉承着“理论讲解—案例分析—应用扩展”这一特色,帮助读者更加直观、生动地学习神经网络。

《MATLAB神经网络43个案例分析》共有43章,内容涵盖常见的神经网络(BP、RBF、SOM、Hopfield、Elman、LVQ、Kohonen、GRNN、NARX等)以及相关智能算法(SVM、决策树、随机森林、极限学习机等)。同时,部分章节也涉及了常见的优化算法(遗传算法、蚁群算法等)与神经网络的结合问题。此外,《MATLAB神经网络43个案例分析》还介绍了MATLAB R2012b中神经网络工具箱的新增功能与特性,如神经网络并行计算、定制神经网络、神经网络高效编程等。

近年来随着人工智能研究的兴起,神经网络这个相关方向也迎来了又一阵研究热潮,由于其在信号处理领域中的不俗表现,神经网络方法也在不断深入应用到语音和图像方向的各种应用当中,本文结合书中案例,对其进行仿真实现,也算是进行一次重新学习,希望可以温故知新,加强并提升自己对神经网络这一方法在各领域中应用的理解与实践。自己正好在多抓鱼上入手了这本书,下面开始进行仿真示例,主要以介绍各章节中源码应用示例为主,本文主要基于MATLAB2015b(32位)平台仿真实现,这是本书第十七章基于SVM的信息粒化时序回归预测实例,话不多说,开始!

2. MATLAB 仿真示例

打开MATLAB,点击“主页”,点击“打开”,找到示例文件

选中chapter_FIGsh.m,点击“打开”

chapter_FIGsh.m源码如下:

%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%

%功能:基于SVM的信息粒化时序回归预测——上证指数开盘指数变化趋势和变化空间预测

%环境:Win7,Matlab2015b

%Modi: C.S

%时间:2022-06-14

%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%

%% Matlab神经网络43个案例分析

% 基于SVM的信息粒化时序回归预测——上证指数开盘指数变化趋势和变化空间预测

% by 李洋(faruto)

% http://www.matlabsky.com

% Email:faruto@163.com

% http://weibo.com/faruto

% http://blog.sina.com.cn/faruto

% 2013.01.01

%% 清空环境变量

function chapter_FIGsh

tic;

close all;

clear;

clc;

format compact;

%% 原始数据的提取

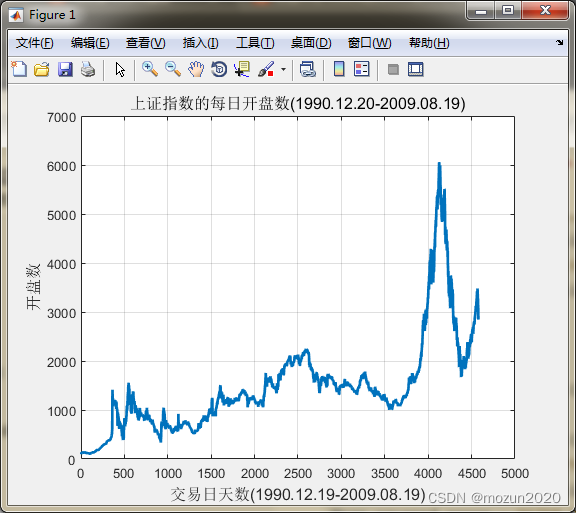

% 载入测试数据上证指数(1990.12.19-2009.08.19)

% 数据是一个4579*6的double型的矩阵,每一行表示每一天的上证指数

% 6列分别表示当天上证指数的开盘指数,指数最高值,指数最低值,收盘指数,当日交易量,当日交易额.

load chapter_sh.mat;

% 提取数据

ts = sh_open;

time = length(ts);

% 画出原始上证指数的每日开盘数

figure;

plot(ts,'LineWidth',2);

title('上证指数的每日开盘数(1990.12.20-2009.08.19)','FontSize',12);

xlabel('交易日天数(1990.12.19-2009.08.19)','FontSize',12);

ylabel('开盘数','FontSize',12);

grid on;

% print -dtiff -r600 original;

snapnow;

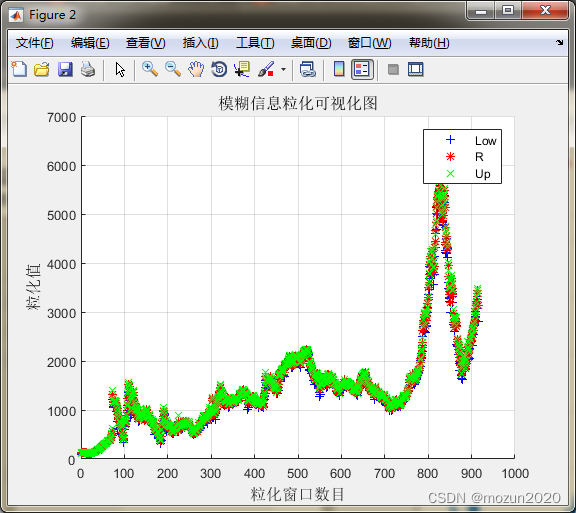

%% 对原始数据进行模糊信息粒化

win_num = floor(time/5);

tsx = 1:win_num;

tsx = tsx';

[Low,R,Up]=FIG_D(ts','triangle',win_num);

% 模糊信息粒化可视化图

figure;

hold on;

plot(Low,'b+');

plot(R,'r*');

plot(Up,'gx');

hold off;

legend('Low','R','Up',2);

title('模糊信息粒化可视化图','FontSize',12);

xlabel('粒化窗口数目','FontSize',12);

ylabel('粒化值','FontSize',12);

grid on;

% print -dtiff -r600 FIGpic;

snapnow;

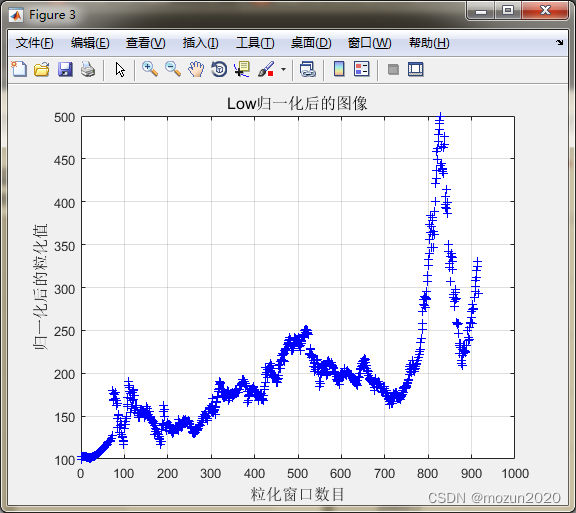

%% 利用SVM对Low进行回归预测

% 数据预处理,将Low进行归一化处理

% mapminmax为matlab自带的映射函数

[low,low_ps] = mapminmax(Low);

low_ps.ymin = 100;

low_ps.ymax = 500;

% 对Low进行归一化

[low,low_ps] = mapminmax(Low,low_ps);

% 画出Low归一化后的图像

figure;

plot(low,'b+');

title('Low归一化后的图像','FontSize',12);

xlabel('粒化窗口数目','FontSize',12);

ylabel('归一化后的粒化值','FontSize',12);

grid on;

% print -dtiff -r600 lowscale;

% 对low进行转置,以符合libsvm工具箱的数据格式要求

low = low';

snapnow;

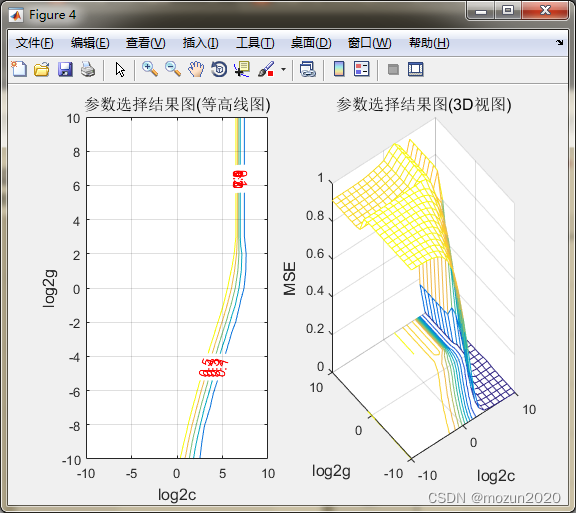

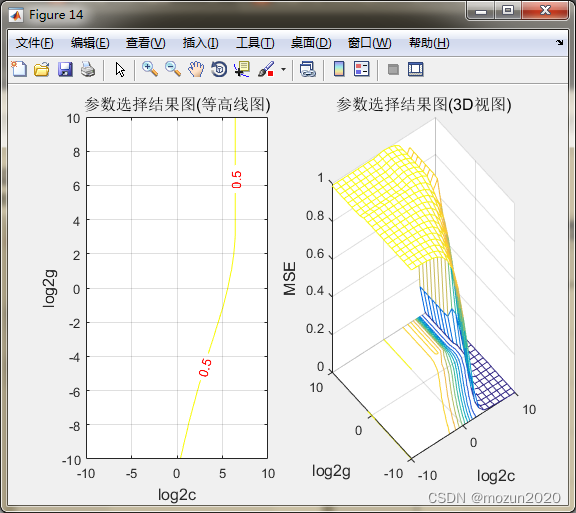

% 选择回归预测分析中最佳的SVM参数c&g

% 首先进行粗略选择

[bestmse,bestc,bestg] = SVMcgForRegress(low,tsx,-10,10,-10,10,3,1,1,0.1,1);

% 打印粗略选择结果

disp('打印粗略选择结果');

str = sprintf( 'SVM parameters for Low:Best Cross Validation MSE = %g Best c = %g Best g = %g',bestmse,bestc,bestg);

disp(str);

% 根据粗略选择的结果图再进行精细选择

[bestmse,bestc,bestg] = SVMcgForRegress(low,tsx,-4,8,-10,10,3,0.5,0.5,0.05,1);

% 打印精细选择结果

disp('打印精细选择结果');

str = sprintf( 'SVM parameters for Low:Best Cross Validation MSE = %g Best c = %g Best g = %g',bestmse,bestc,bestg);

disp(str);

% 训练SVM

cmd = ['-c ', num2str(bestc), ' -g ', num2str(bestg) , ' -s 3 -p 0.1'];

low_model = svmtrain(low, tsx, cmd);

% 预测

[low_predict,low_mse] = svmpredict(low,tsx,low_model);

low_predict = mapminmax('reverse',low_predict,low_ps);

predict_low = svmpredict(1,win_num+1,low_model);

predict_low = mapminmax('reverse',predict_low,low_ps);

predict_low

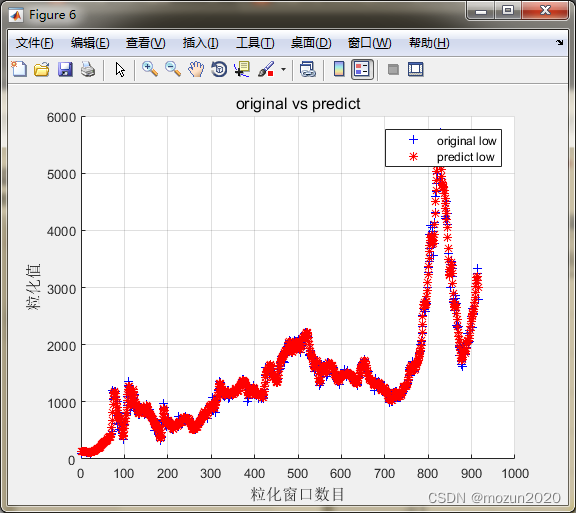

%% 对于Low的回归预测结果分析

figure;

hold on;

plot(Low,'b+');

plot(low_predict,'r*');

legend('original low','predict low',2);

title('original vs predict','FontSize',12);

xlabel('粒化窗口数目','FontSize',12);

ylabel('粒化值','FontSize',12);

grid on;

% print -dtiff -r600 lowresult;

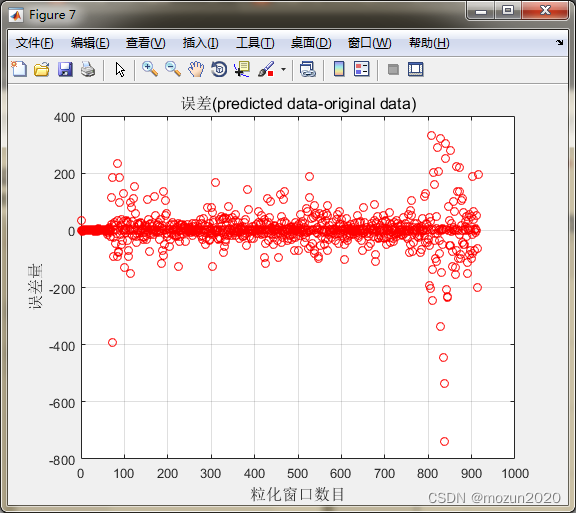

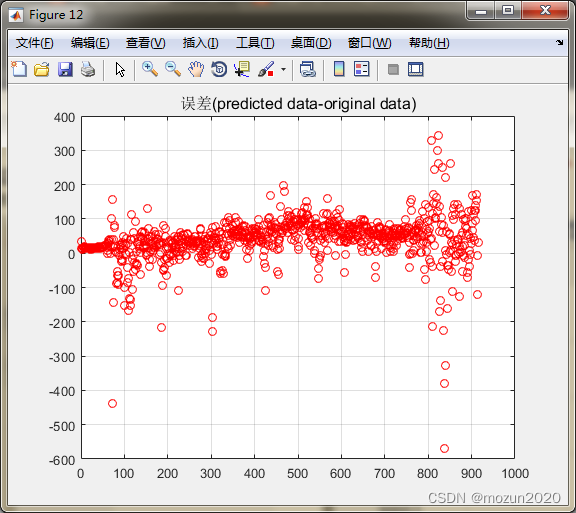

figure;

error = low_predict - Low';

plot(error,'ro');

title('误差(predicted data-original data)','FontSize',12);

xlabel('粒化窗口数目','FontSize',12);

ylabel('误差量','FontSize',12);

grid on;

% print -dtiff -r600 lowresulterror;

% snapnow;

%% 利用SVM对R进行回归预测

% 数据预处理,将R进行归一化处理

% mapminmax为matlab自带的映射函数

[r,r_ps] = mapminmax(R);

r_ps.ymin = 100;

r_ps.ymax = 500;

% 对R进行归一化

[r,r_ps] = mapminmax(R,r_ps);

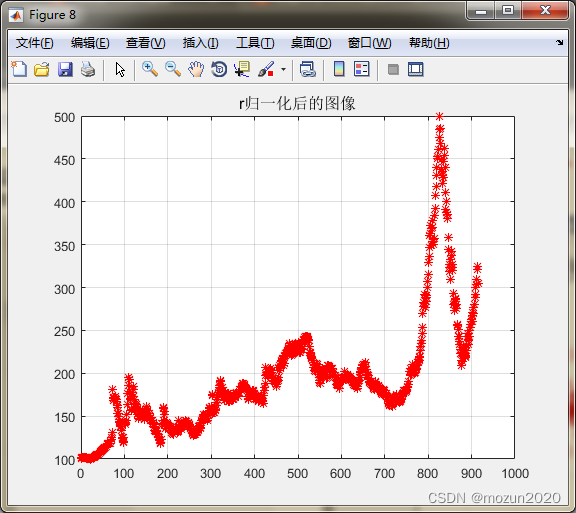

% 画出R归一化后的图像

figure;

plot(r,'r*');

title('r归一化后的图像','FontSize',12);

grid on;

% 对R进行转置,以符合libsvm工具箱的数据格式要求

r = r';

% snapnow;

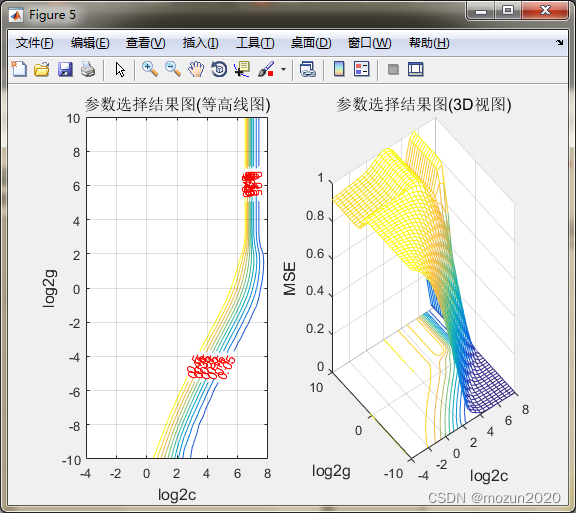

% 选择回归预测分析中最佳的SVM参数c&g

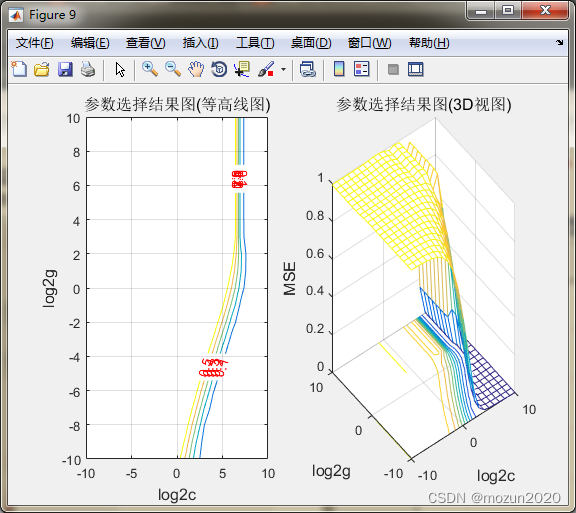

% 首先进行粗略选择

[bestmse,bestc,bestg] = SVMcgForRegress(r,tsx,-10,10,-10,10,3,1,1,0.1);

% 打印粗略选择结果

disp('打印粗略选择结果');

str = sprintf( 'SVM parameters for R:Best Cross Validation MSE = %g Best c = %g Best g = %g',bestmse,bestc,bestg);

disp(str);

% 根据粗略选择的结果图再进行精细选择

[bestmse,bestc,bestg] = SVMcgForRegress(r,tsx,-4,8,-10,10,3,0.5,0.5,0.05);

% 打印精细选择结果

disp('打印精细选择结果');

str = sprintf( 'SVM parameters for R:Best Cross Validation MSE = %g Best c = %g Best g = %g',bestmse,bestc,bestg);

disp(str);

% 训练SVM

cmd = ['-c ', num2str(bestc), ' -g ', num2str(bestg) , ' -s 3 -p 0.1'];

r_model = svmtrain(r, tsx, cmd);

% 预测

[r_predict,r_mse] = svmpredict(r,tsx,low_model);

r_predict = mapminmax('reverse',r_predict,r_ps);

predict_r = svmpredict(1,win_num+1,r_model);

predict_r = mapminmax('reverse',predict_r,r_ps);

predict_r

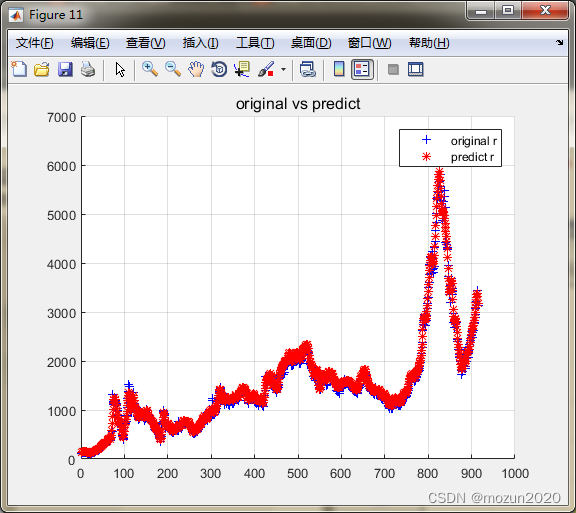

%% 对于R的回归预测结果分析

figure;

hold on;

plot(R,'b+');

plot(r_predict,'r*');

legend('original r','predict r',2);

title('original vs predict','FontSize',12);

grid on;

figure;

error = r_predict - R';

plot(error,'ro');

title('误差(predicted data-original data)','FontSize',12);

grid on;

% snapnow;

%% 利用SVM对Up进行回归预测

% 数据预处理,将up进行归一化处理

% mapminmax为matlab自带的映射函数

[up,up_ps] = mapminmax(Up);

up_ps.ymin = 100;

up_ps.ymax = 500;

% 对Up进行归一化

[up,up_ps] = mapminmax(Up,up_ps);

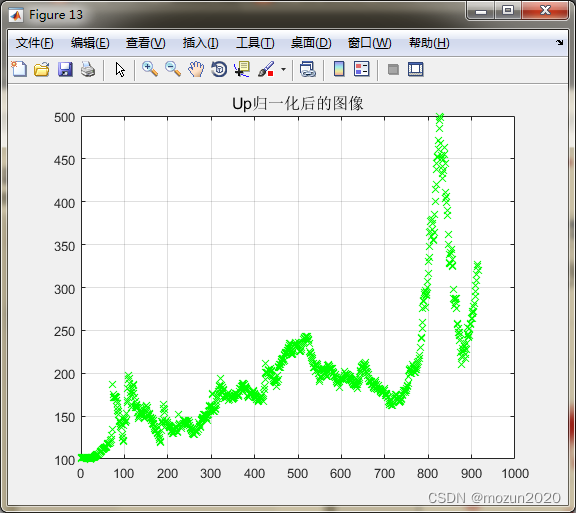

% 画出Up归一化后的图像

figure;

plot(up,'gx');

title('Up归一化后的图像','FontSize',12);

grid on;

% 对up进行转置,以符合libsvm工具箱的数据格式要求

up = up';

snapnow;

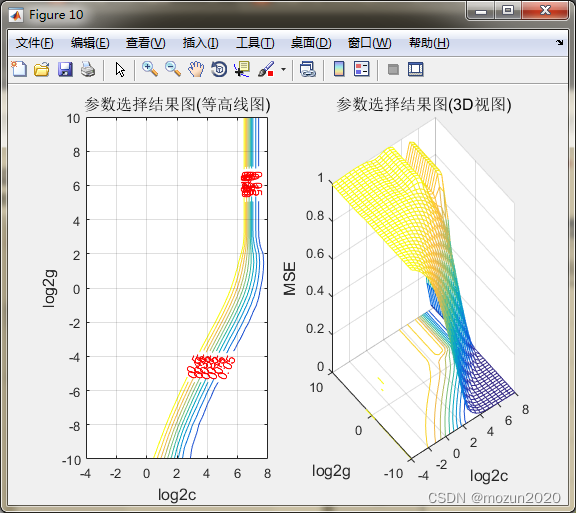

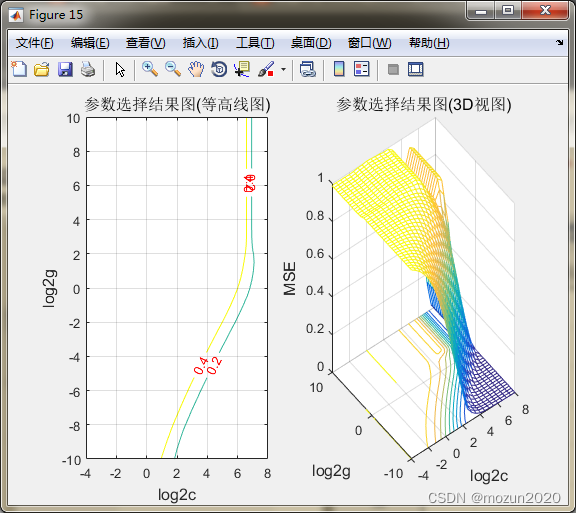

% 选择回归预测分析中最佳的SVM参数c&g

% 首先进行粗略选择

[bestmse,bestc,bestg] = SVMcgForRegress(up,tsx,-10,10,-10,10,3,1,1,0.5);

% 打印粗略选择结果

disp('打印粗略选择结果');

str = sprintf( 'SVM parameters for Up:Best Cross Validation MSE = %g Best c = %g Best g = %g',bestmse,bestc,bestg);

disp(str);

% 根据粗略选择的结果图再进行精细选择

[bestmse,bestc,bestg] = SVMcgForRegress(up,tsx,-4,8,-10,10,3,0.5,0.5,0.2);

% 打印精细选择结果

disp('打印精细选择结果');

str = sprintf( 'SVM parameters for Up:Best Cross Validation MSE = %g Best c = %g Best g = %g',bestmse,bestc,bestg);

disp(str);

% 训练SVM

cmd = ['-c ', num2str(bestc), ' -g ', num2str(bestg) , ' -s 3 -p 0.1'];

up_model = svmtrain(up, tsx, cmd);

% 预测

[up_predict,up_mse] = svmpredict(up,tsx,up_model);

up_predict = mapminmax('reverse',up_predict,up_ps);

predict_up = svmpredict(1,win_num+1,up_model);

predict_up = mapminmax('reverse',predict_up,up_ps);

predict_up

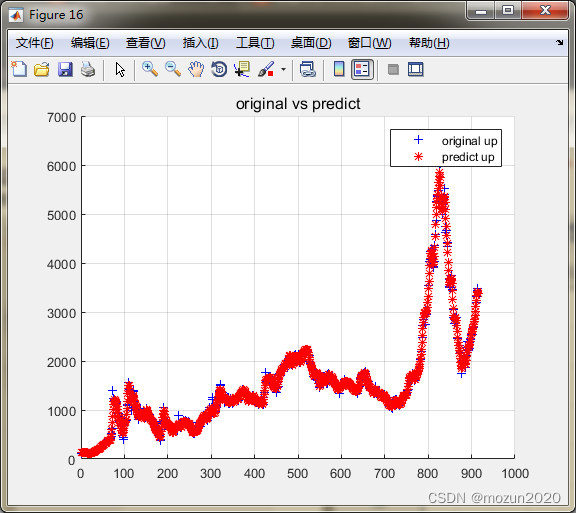

%% 对于Up的回归预测结果分析

figure;

hold on;

plot(Up,'b+');

plot(up_predict,'r*');

legend('original up','predict up',2);

title('original vs predict','FontSize',12);

grid on;

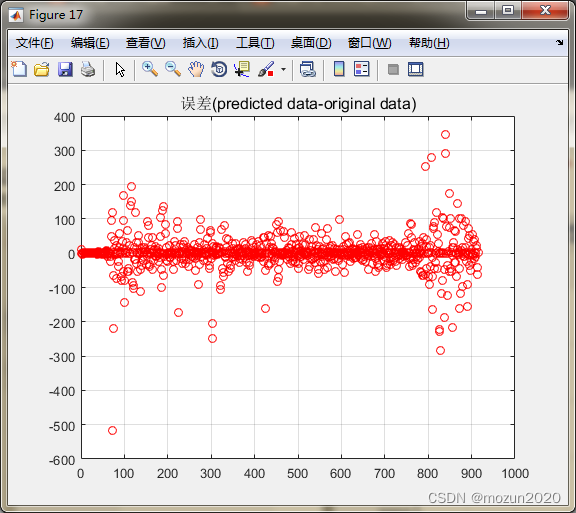

figure;

error = up_predict - Up';

plot(error,'ro');

title('误差(predicted data-original data)','FontSize',12);

grid on;

toc;

% snapnow;

%% 子函数 SVMcgForRegress.m

function [mse,bestc,bestg] = SVMcgForRegress(train_label,train,cmin,cmax,gmin,gmax,v,cstep,gstep,msestep,flag)

% SVMcgForClass

% 输入:

% train_label:训练集标签.要求与libsvm工具箱中要求一致.

% train:训练集.要求与libsvm工具箱中要求一致.

% cmin:惩罚参数c的变化范围的最小值(取以2为底的对数后),即 c_min = 2^(cmin).默认为 -5

% cmax:惩罚参数c的变化范围的最大值(取以2为底的对数后),即 c_max = 2^(cmax).默认为 5

% gmin:参数g的变化范围的最小值(取以2为底的对数后),即 g_min = 2^(gmin).默认为 -5

% gmax:参数g的变化范围的最小值(取以2为底的对数后),即 g_min = 2^(gmax).默认为 5

% v:cross validation的参数,即给测试集分为几部分进行cross validation.默认为 3

% cstep:参数c步进的大小.默认为 1

% gstep:参数g步进的大小.默认为 1

% msestep:最后显示MSE图时的步进大小.默认为 20

% 输出:

% bestacc:Cross Validation 过程中的最高分类准确率

% bestc:最佳的参数c

% bestg:最佳的参数g

% about the parameters of SVMcgForRegress

if nargin < 11

flag = 0;

end

if nargin < 10

msestep = 0.1;

end

if nargin < 7

msestep = 0.1;

v = 3;

cstep = 1;

gstep = 1;

end

if nargin < 6

msestep = 0.1;

v = 3;

cstep = 1;

gstep = 1;

gmax = 5;

end

if nargin < 5

msestep = 0.1;

v = 3;

cstep = 1;

gstep = 1;

gmax = 5;

gmin = -5;

end

if nargin < 4

msestep = 0.1;

v = 3;

cstep = 1;

gstep = 1;

gmax = 5;

gmin = -5;

cmax = 5;

end

if nargin < 3

msestep = 0.1;

v = 3;

cstep = 1;

gstep = 1;

gmax = 5;

gmin = -5;

cmax = 5;

cmin = -5;

end

% X:c Y:g cg:mse

[X,Y] = meshgrid(cmin:cstep:cmax,gmin:gstep:gmax);

[m,n] = size(X);

cg = zeros(m,n);

% record accuracy with different c & g,and find the best mse with the smallest c

bestc = 0;

bestg = 0;

mse = 10^10;

basenum = 2;

for i = 1:m

for j = 1:n

cmd = ['-v ',num2str(v),' -c ',num2str( basenum^X(i,j) ),' -g ',num2str( basenum^Y(i,j) ),' -s 3'];

cg(i,j) = svmtrain(train_label, train, cmd);

if cg(i,j) < mse

mse = cg(i,j);

bestc = basenum^X(i,j);

bestg = basenum^Y(i,j);

end

if ( cg(i,j) == mse && bestc > basenum^X(i,j) )

mse = cg(i,j);

bestc = basenum^X(i,j);

bestg = basenum^Y(i,j);

end

end

end

% draw the accuracy with different c & g

[cg,ps] = mapminmax(cg,0,1);

figure;

subplot(1,2,1);

[C,h] = contour(X,Y,cg,0:msestep:0.5);

clabel(C,h,'FontSize',10,'Color','r');

xlabel('log2c','FontSize',12);

ylabel('log2g','FontSize',12);

title('参数选择结果图(等高线图)','FontSize',12);

grid on;

subplot(1,2,2);

meshc(X,Y,cg);

% mesh(X,Y,cg);

% surf(X,Y,cg);

axis([cmin,cmax,gmin,gmax,0,1]);

xlabel('log2c','FontSize',12);

ylabel('log2g','FontSize',12);

zlabel('MSE','FontSize',12);

title('参数选择结果图(3D视图)','FontSize',12);

filename = ['c',num2str(bestc),'g',num2str(bestg),num2str(msestep),'.tif'];

% if flag == 1;

% print('-dtiff','-r600',filename);

% end

添加完毕,点击“运行”,开始仿真,输出仿真结果如下:

打印粗略选择结果

SVM parameters for Low:Best Cross Validation MSE = 35.0883 Best c = 256 Best g = 0.03125

打印精细选择结果

SVM parameters for Low:Best Cross Validation MSE = 35.0177 Best c = 256 Best g = 0.0220971

Mean squared error = 22.0054 (regression)

Squared correlation coefficient = 0.995366 (regression)

Mean squared error = 85136.1 (regression)

Squared correlation coefficient = -1.#IND (regression)

predict_low =

2.7968e+03

打印粗略选择结果

SVM parameters for R:Best Cross Validation MSE = 22.782 Best c = 256 Best g = 0.03125

打印精细选择结果

SVM parameters for R:Best Cross Validation MSE = 22.782 Best c = 256 Best g = 0.03125

Mean squared error = 26.2001 (regression)

Squared correlation coefficient = 0.995899 (regression)

Mean squared error = 84653.6 (regression)

Squared correlation coefficient = -1.#IND (regression)

predict_r =

2.9500e+03

打印粗略选择结果

SVM parameters for Up:Best Cross Validation MSE = 23.876 Best c = 512 Best g = 0.0625

打印精细选择结果

SVM parameters for Up:Best Cross Validation MSE = 23.8956 Best c = 256 Best g = 0.0220971

Mean squared error = 11.1079 (regression)

Squared correlation coefficient = 0.997625 (regression)

Mean squared error = 96798.9 (regression)

Squared correlation coefficient = -1.#IND (regression)

predict_up =

3.2673e+03

时间已过 1479.500576 秒。

3. 小结

这个例程跑了好一段时间,首先再次温馨提示股市有风险,投资需谨慎。利用数据模型对股市进行预测分析应该早就有人进行尝试了,但仅仅作为参考就可以了,不建议入戏太深,因为实时指数更多的是受到经济形势,行业动态,公司业绩等等多重因素影响而产生的,并不是根据历史数据建一个模型进行分析就可以掐指一算的。当然从另一个角度来说,如果能够将越来越多的因素都考虑进来,那样进行预测的结果理论上确实应该更加准确一些,但事实是我们都不是上帝,至少目前基本上都是信息孤岛,因此作出的预测与分析不可避免的会存在偏差,也许未来我们挣得会创造出一个接近于上帝的存在,只是这个未来目前来说还是十分遥远的。对本章内容感兴趣或者想充分学习了解的,建议去研习书中第十七章节的内容。后期会对其中一些知识点在自己理解的基础上进行补充,欢迎大家一起学习交流。