本文简单地介绍了RBF NN、DNN、CNN、LSTM、RNN、AE、DBN、GAN这8种神经网络及应用场景,不涉及算法详细推导过程。

系列文章:

- 【神经网络算法详解 01】-- 人工神经网络基础

- 【神经网络算法详解 02】 – 感知神经网络与反向传播算法(BP)

- 【神经网络算法详解 03】 – 竞争神经网络【SONN、SOFM、LVQ、CPN、ART】

- 【神经网络算法详解 04】 – 反馈神经网络 【Hopfield、DHNN、CHNN、BAM、BM、RBM】

- 【神经网络算法详解 05】-- 其它类型的神经网络简介【RBF NN、DNN、CNN、LSTM、RNN、AE、DBN、GAN】

文章目录

1. 径向基函数神经网络(RBF NN)

径向基函数神经网络(Radical Basis Function Neural Network,RBF NN):1988年由John Moody和Christian J Darken提出了一种网络结构,属于前向型神经网络,理论上可以任意精度逼近任意连续函数,适合解决分类问题。

径向基函数(RBF):某种沿径向对称的标量函数,通常定义为空间中某点到另外一个中心点的欧氏距离的单调函数,其特点为,如果某点离中心点距离较远,则函数取值很小。

高斯径向基函数:

用RBF作为单元的“基”构成隐含层空间,即可将输入矢量直接(即不需要通过权连接)映射到隐空间,低维空间不可分的数据到了高维空间会更有可能变得可分。隐层的功能就是将低维空间的输入通过非线性函数映射到一个高维空间,然后再在这个高维空间进行曲线的拟合。

- 网络结构为三层前向网络;

- 输入层到隐藏层无权重连接;

- 藏层的激活函数为径向基函数(RBF);

- 从输入层(空间)到隐藏层(空间〕的变换是非线性的;

- 从隐藏层(空间)到输出层(空间〕的变换是线性的;

2. 深度神经网络(DNN)

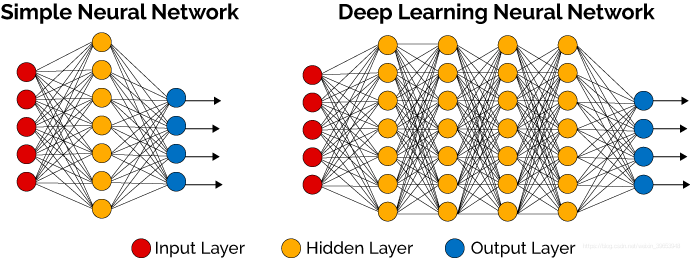

深度神经网络(DNN) 是很多人工智能应用的基础,在语音识别、图像识别等有突破性的提高。这是因为它能使用统计学习方法从原始感官数据中提取高层特征,在大量的数据中获得输入空间的有效表征。简单理解深度神经网络就是有多个隐层的多层感知器网络,根据实际应用情况不同,其形态和大小也都不一样。

3. 卷积神经网络(CNN)

卷积神经网络(CNN):由Yann LeCun提出并应用在手写字体〔MINST)识别上,其实质是一种多层前馈网络,擅长处理图像特别是大图像的处理和识别。

一个最典型的卷积网络,由卷积层、池化层、全连接层组成。其中卷积层与池化层配合,组成多个卷积组,逐层提取特征,最终通过若干个全连接层完成分类。介绍一个有趣的手写数字识别3D可视化网站:

4. 递归神经网络(RNN)

前馈神经网络只能单独处理一个一个的输入,不同的输入之间被认为是相互独立没有联系的,但实际上很多时候输入之间是有序列关系的,需要使用递归神经网络(Recurrent Neural Network,RNN),也称循环神经网络,其引入了“记忆”的概念,即庙述了当前输出于之前的输入信息的关系,递归的含义是指每个神经元都执行相同的任务,但是输出依赖于输入和“记忆”,常用语NLP、机器翻译、语音识别、图像描述生成、文本相似度等。

5. 长短时记忆网络(LSTM)

长期记忆网络(Long Short-Term Memory,LSTM):是一种时间递归神经网络,适用于处理和预测时间序列中间隔和延迟较长的重要事件。基于LSTM的系统可以学习翻译语言、控制机器人、图像分析、文档摘要、语音识别图像识别、手写识别、控制聊天机器人、预测疾病、点击率和股票、合成音乐等等任务。LSTM区别于RNN的地方,主要就在于它在算法中加入了一个判断信息有与否的“处理器”,信息有用则被记忆,无用则被遗忘。目前已经证明,LSTM是解决长序依赖问题的有效技术,并且这种技术的普适性非常高,导致带来的可能性变化非常多。

6. 自编码器(Auto Encoder)

自动编码器(Auto Encoder):是人工神经网络的一种,主要用来处理数据的压缩,其数据的压缩和解压缩函数是数据相关的、有损的、从样本中自动学习的。原理为训练神经网络,通过捕捉可以代表输入信息的最关键的因素,让其输入能近似复制到输出,即让输入内容和输出内容近似一样。

7. 深度信念网络(DBN)

**深度信念网络(Deep Belief Nets,DBN)**或称深度置信网络,神经网络的一种,由多个受限玻尔兹曼机组成。既可以用于非监督学习,类似于一个自编码器,也可以用于监督学习,类似于一个分类器。从非监督学习来讲,其目的是尽可能地保留原始特征的特点,同时降低特征的维度。从监督学习来讲,其目的在于使得分类误率尽可能地小。而不论是监督学习还是非监督学习,DBN的本质都是Feature Learning的过程,即如何得到更好的特征表达。

8. 生成式对抗网络GAN

生成对抗网络(Generative Adversarial Network,GAN):由GoodFellow在2014年提出,其核心思想来自于博弈论的"纳什均衡“。它包含两个网络模型:一个生成模型和一个判别模型。生成模型捕捉样本数据的分布,判别模型是一个二分类的分类器。生成模型接受一个随机的噪声,结合学习到的样本数据特征,生成一个新的数据,交由分类模型去判断是否是“真实的”,在训练过程中,生成模型尽量生成新数据去欺骗判断模型,判断模型会尽量去识别出不真实的数据,两者实际上是一个“二元极小极大博弈问题”。最终得到一个生成模型可以从来生成新的数据。