参考《深度学习入门之Pytorch》

Logistic回归实现二分类问题

数据下载链接:data(提取码:q8gd)

1. 首先读取 数据 data.txt

#logistic回归

#读取data.txt

import matplotlib.pyplot as plt

with open('data.txt','r') as f:

data_list = f.readlines()

data_list = [i.split('\n')[0] for i in data_list]

data_list = [i.split(',') for i in data_list]

data = [(float(i[0]),float(i[1]),float(i[2])) for i in data_list]

#q前两个数据表示X,Y坐标,最后一个数据表示类别打开data.txt,前两个数据是横纵坐标,最后一个是类别0,1。这个数据有两个属性一个类别。 接着把数据按类别不同画出来。

x0 = list(filter(lambda x: x[-1]==0.,data)) #filter去除不符合条件的,保留符合条件的数据

x1 = list(filter(lambda x: x[-1]==1.,data))#数据按类别筛选

plot_x0_x = [i[0] for i in x0]

plot_x0_y = [i[1] for i in x0]

plot_x1_x = [i[0] for i in x1]

plot_x1_y = [i[1] for i in x1]

plt.plot(plot_x0_x,plot_x0_y,'ro',label='x_0')

plt.plot(plot_x1_x,plot_x1_y,'gx',label='x_1')

plt.legend(loc='best')

Pytorch的操作对象是Tensor,这里要把数据类型转为Tensor.

import torch

import numpy as np

from torch import nn

# #转换数据

np_data = np.array(data, dtype='float32') # 转换成 numpy array

x_data = torch.from_numpy(np_data[:, 0:2]) # 转换成 Tensor, 大小是 [100, 2]

y_data = torch.from_numpy(np_data[:, -1]).unsqueeze(1) # 转换成 Tensor,大小是 [100, 1]2. 构造分类模型

class LR(nn.Module):

def __init__(self):

super(LR,self).__init__()

self.lr = nn.Linear(2,1) #输入两个属性输出一个类别

self.sm = nn.Sigmoid() #Sigmoid激活函数就是Logistic回归的精髓

def forward(self,x):

x = self.lr(x)

x = self.sm(x)

return x

LR_model = LR()

if torch.cuda.is_available():

LR_model.cuda()

criterion = nn.BCELoss() #BCE是二分类损失函数 交叉熵

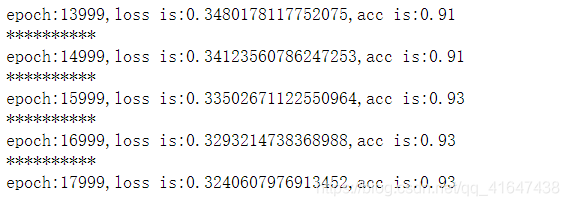

optimizer = torch.optim.SGD(LR_model.parameters(),lr=1e-3,momentum=0.9)3.训练模型,如果支持CUDA,要把模型和数据都放在CUDA上运行,用 .cuda()就可以绑定。

for epoch in range(18000):

if torch.cuda.is_available():

x = x_data.cuda()

y = y_data.cuda()

else:

x = x_data

y = y_data

#===========forward==================#

out = LR_model(x)

loss = criterion(out,y)

mask = out.ge(0.5).float() #把输出结果大于0.5的归于1,小于归成0

correct = (mask==y).sum()

acc = correct.item()/x.size(0)

#===========backward==================#

optimizer.zero_grad()

loss.backward()

optimizer.step()

if (epoch+1)%1000== 0: #每迭代一千次,看一下当前loss,acc

print('*'*10)

print('epoch:{},loss is:{},acc is:{}'.format(epoch,loss.item(),acc))结果如下:

扫描二维码关注公众号,回复:

10350443 查看本文章

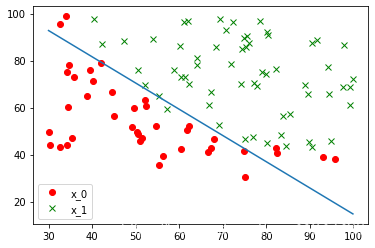

4. 在数据图上画出分界线。

#画出分界线

w0,w1 = LR_model.lr.weight[0]

w0 = w0.item() #tensor是标量可以用item直接转换

w1 = w1.item()

b = LR_model.lr.bias[0]

b = b.item()

plot_x = np.arange(30,100,0.1)#从之前的图大致看出x轴范围

plot_y = (-w0*plot_x-b)/w1 #w1y+w0 x+b=0直线

plt.plot(plot_x0_x,plot_x0_y,'ro',label='x_0')

plt.plot(plot_x1_x,plot_x1_y,'gx',label='x_1')

plt.legend(loc='best')

plt.plot(plot_x,plot_y)

Pytorch版本的问题,原书代码可能会有许多报错,百度一下即可。