网上一大堆的文章,但是他们的介绍并没有实际上说明为什么使用最优决策树,决策树到底是什么玩意

我这里也不做类似的白话文解释了,直接附图来详细生动的例子给大家演示why

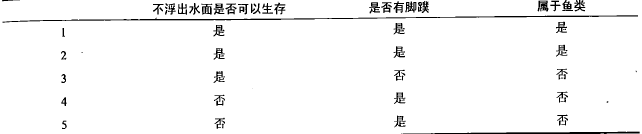

OK,现在我们先以是否浮出水面来分类

最终结果如图

ok,经过我们层层的决策,结果如图

最后结果是[1,1],[1,1]为鱼类,[1,0],[0,1],[0,1]为非鱼类,而其实我们在第一次判别是否浮出水面的时候已经把[0,1][0,1]排除在外了

我们实际经历了2次决策,第一次决策排除了2个

现在我们试试以是否有脚蹼来分类

一样是2次决策,但是第一次决策只排除了1个

很显然我们用第一种决策方式,是属于最优的

在此处信息熵就是总的5个样本的集合的信号

而分类引起的信息增益也就是划分之后,我们剩下的子集需要多少信号去表达的度量

经过第一种分类 剩下的表达就只有 0,1,10三个就可以存储下

而第二种我们需要0,1,10,11才可以存储下。

明显第一种划分之后纯度更高(信息熵-分类信息熵),是我们的最优选择

这就是所谓的决策树算法,也就是每次递归,我们要去选取哪一种类别占主要因素