摘要

图神经网络已成为解决图结构数据机器学习问题的重要技术之一。最近关于顶点分类的工作提出了深度和分布式学习模型,以实现高性能和可扩展性。然而,我们发现基准数据集的特征向量已经为分类任务提供了相当多的信息,而图结构仅仅提供了一种对数据进行去噪的方法。本文提出了一种基于图信号处理的分析图神经网络的理论框架。结果表明,图神经网络仅对特征向量进行低通滤波,不具有非线性流形学习特性。我们进一步研究了它们对特征噪声的抵抗能力,并对基于GCN的图形神经网络设计提出了一些见解。

1

图形神经网络(GNN)是一类能够从图形结构数据中学习的神经网络。近年来,用于顶点分类和图同构检验的图神经网络在多个基准数据集上取得了良好的效果,并不断创造出新的性能水平[1,16,26,29]。从ChebNet[6]和GCN[16]在顶点分类方面的早期成功开始,GNN的许多变体被提出用于解决社交网络[12,31]、生物学[26,27]、化学[8,10]、自然语言处理[2,32]、计算机视觉[21]和弱监督学习[9]中的问题。

在半监督顶点分类中,我们观察到图卷积网络(GCN)[16]中图卷积层的参数只会导致过度拟合。在SGC[28]等简单架构和DGI[27]等更复杂架构中都报告了类似的观察结果。基于这种现象,吴等人。[28]提出将图神经网络简单地看作是特征传播,并提出了一个在许多基准数据集上具有最新性能的极为有效的模型。川本等人。[14] 对图分区设置下未训练的类GCN GNNs作了相关的理论评述。从这些先前的研究中,一个问题自然而然地出现了:为什么图神经网络在顶点分类方面工作得很好,什么时候工作得很好?换言之,图神经网络模型的顶点特征向量是否有条件即使不经过训练也能正常工作?因此,我们能否找到基线图神经网络(如SGC或GCN)无法执行的现实反例?

在本研究中,我们从图形信号处理的角度回答了上述问题[19]。形式上,我们考虑图上的半监督学习问题。

给定一个图G=(V,E),每个顶点i∈V有一个特征x(i)∈X和标号y(i)∈Y,其中X是一个d维欧氏空间,Y用于回归,Y={1,...,c}用于分类。任务是学习从特征x(i)预测标签y(i)的一个假设空间。本文用图神经网络解决了这个问题,并为最常用的基线模型GCN[16]及其简化变体SGC[28]的机制提供了见解。

图形信号处理(GSP)将顶点上的数据作为信号,应用信号处理技术来理解信号的特征。通过将信号(特征向量)和图结构(邻接矩阵或其变换)相结合,GSP启发了图结构数据学习算法的发展[23]。在标准信号处理问题中,通常假设观测值包含一些噪声,而潜在的“真实信号”具有低频率[20]。在这里,我们对我们的问题提出了类似的假设。

假设1:输入特征包括低频真实特征和噪声。真实特征对于机器学习任务具有足够的信息。

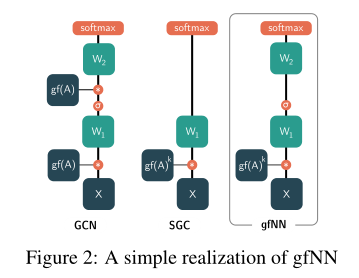

我们的第一个贡献是在常用数据集上验证假设1(第3节)。下图显示了两层感知器(MLP)在不同频率分量的特征上训练的性能。在所有基准数据集中,我们看到只有少数频率成分有助于学习。在特征向量中加入更多的频率分量只会降低性能。当特征中加入高斯噪声N(0,σ2)时,分类精度进一步降低。

这个图说明了两件事:噪声的存在会降低分类准确率,这个显然;然后特征分得越细越多不一定越好,因为只有少数的特征会帮助我们提高分类准确率,多了反而下降,有点像过拟合。

许多最新的gnn是建立在图形信号处理的结果之上的。最常见的做法是将(增广的)标准化邻接矩阵I与特征矩阵X相乘。乘积被理解为特征平均和传播[12、16、28]。在图信号处理文献中,这种操作在图上过滤信号,而不是显式地对归一化拉普拉斯矩阵执行特征分解,这需要O(n3)时间。在这里,我们将这个扩充的规范化邻接矩阵及其变体称为图滤波器和传播矩阵。

我们的第二个贡献表明,将图信号与传播矩阵相乘对应于低通滤波(第4节,特别是定理3)。此外,我们还证明了观测信号和低通滤波器之间的矩阵积是真实信号优化问题的解析解。与图神经网络的最新设计原理[1,16,29]相比,我们的结果表明图卷积层是简单的低通滤波。因此,不必学习图卷积层的参数。吴等人。[28,定理1]还通过分析增强规范化邻接矩阵的谱截断效应来解决类似的问题。我们将这一结果推广到所有特征值单调收缩,进一步解释了谱截断效应的含义。

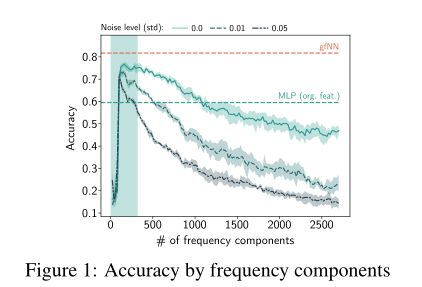

在理论分析的基础上,我们提出了一个新的基线框架gfNN(graph filter neural network)来实证分析顶点分类问题。gfNN包括两个步骤:1。用图过滤矩阵相乘的方法过滤特征。利用机器学习模型学习顶点标签。我们使用下图中的一个简单实现模型来演示我们的框架的有效性。