什么是scrapyd

Scrapyd是部署和运行Scrapy.spider的应用程序。它使您能够使用JSON API部署(上传)您的项目并控制其spider。

特点:

- 可以避免爬虫源码被看到。

- 有版本控制。

- 3、可以远程启动、停止、删除

scrapyd官方文档:http://scrapyd.readthedocs.io/en/stable/overview.html

安装scrapyd

- 安装scrapyd

- 主要有两种安装方式:

- pip install scrapyd (安装的版本可能不是最新版本)

- 从 https://github.com/scrapy/scrapyd 中下载源码, 运行python setup.py install 命令进行安装。

- 安装 scrapyd-deploy

- 主要有两种安装方式:

- pip install scrapyd-client(安装的版本可能不是最新版本)

- 从 http://github.com/scrapy/scrapyd-client 中下源码, 运行python setup.py install 命令进行安装。

scrapyd的简单使用

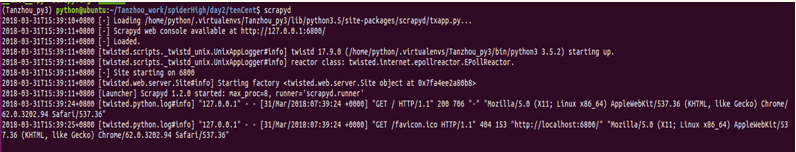

1.运行scrapyd

运行命令:scrapyd

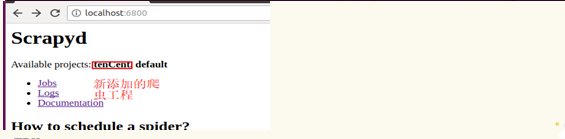

然后打开浏览器,输入ip加端口:127.0.0.1:6800(或localhost:6800)

2.发布项目到scrapyd

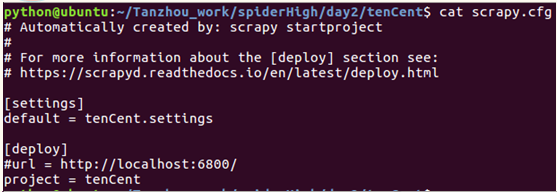

来到待发布项目的文件夹下,发布前需要修改一下配置文件,打开scrapy.cfg文件;

- 首先去掉url前面的注释符号,url是scrapyd服务器的网址

- 然后project=tenCent为项目名称,可以随意起名

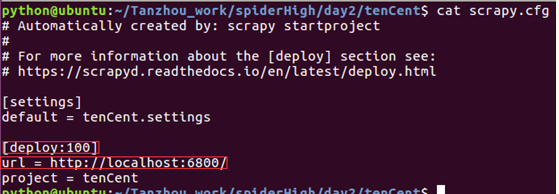

- 修改[deploy]为[deploy:100],表示把爬虫发布到名为100的爬虫服务器上,一般在需要同时发布爬虫到多个目标服务器时使用

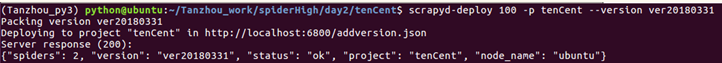

最后,打开一个新的终端,运行命令:

scrapyd-deploy <target> -p <project> --version <version>

参数解释:

Target:deploy后面的名称。可以为空

Project:自行定义名称,跟爬虫的工程名字无关。

Version:自定义版本号,不写的话默认为当前时间戳。

刷新浏览器页面:

3.创建运行爬虫任务

使用命令:

curl http://localhost:6800/schedule.json -d project=myproject -d spider=spider_name

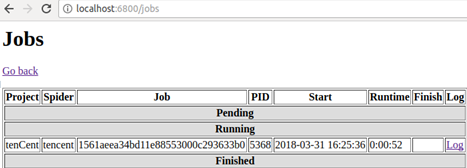

然后点击浏览器界面的Jobs

就可以得到该爬虫的相关运行信息。