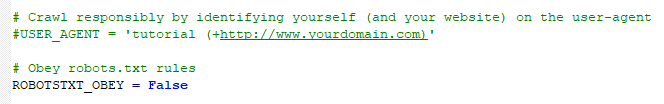

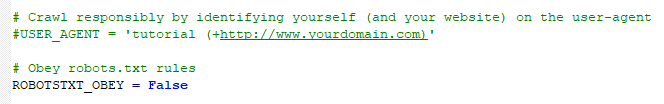

去setting中设置ROBOTSTXT_OBEY为false。

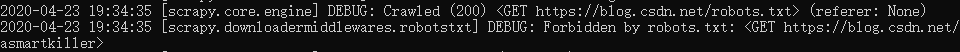

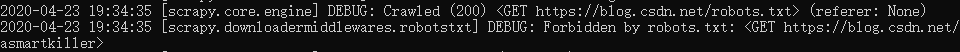

Scrapy默认遵守robots协议,所以针对某些网站,设置了robots.txt的规则,不允许爬取其中某些资源,则Scrapy就不会去爬取。

通过去setting中设置ROBOTSTXT_OBEY为false:ROBOTSTXT_OBEY = False 即可不遵守协议,而去爬取对应页面内容了。

去setting中设置ROBOTSTXT_OBEY为false。

Scrapy默认遵守robots协议,所以针对某些网站,设置了robots.txt的规则,不允许爬取其中某些资源,则Scrapy就不会去爬取。

通过去setting中设置ROBOTSTXT_OBEY为false:ROBOTSTXT_OBEY = False 即可不遵守协议,而去爬取对应页面内容了。