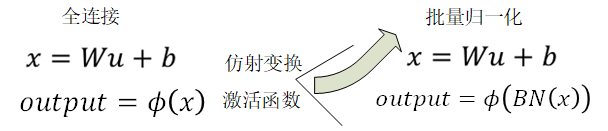

批量归一化和残差网络

批量归一化(BatchNormalization)针对深度模型

- 训练:以batch为单位,对每个batch计算均值和方差。

- 预测:用移动平均估算整个训练数据集的样本均值和方差。

残差网络(ResNet)针对深度CNN网络深度问题

- 残差块(Residual Block)

左边:f(x)=x

右边:f(x)-x=0 (易于捕捉恒等映射的细微波动)

在残差块中,输⼊可通过跨层的数据线路更快地向前传播。

稠密连接网络(DenseNet)

- 稠密块(dense block): 定义了输入和输出是如何连结的。

- 过渡层(transition layer):用来控制通道数,使之不过大。

- 卷积层:来减小通道数

- 步幅为2的平均池化层:减半高和宽

针对凸优化的认识

优化方法与深度学习目的不同

- 优化方法目标:训练集损失函数值

- 深度学习目标:测试集损失函数值(泛化性)

优化在深度学习中的挑战

- 局部最小值

- 鞍点

- 梯度消失

针对梯度下降的认识

收敛性分析

只考虑在函数为凸函数, 且最小值点上

时的收敛速度:

- 三种梯度下降方式的比较

- BGD vs SGD vs MSGD

- BGD vs SGD vs MSGD