文章目录

01-scrapy框架介绍

scrapy入门

创建项目

启动爬虫

可以设置日志等级

extract_first()

02-scrapy-pipline、item、shell

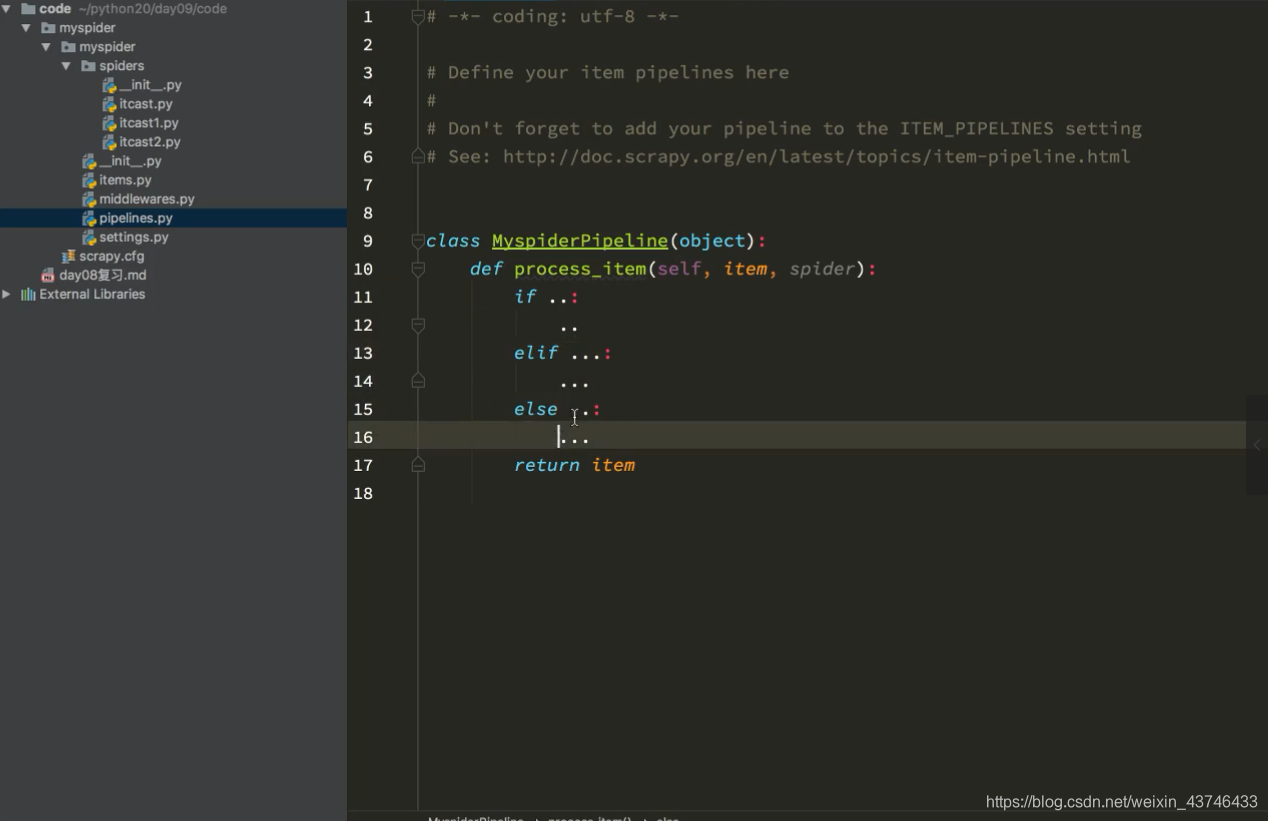

pipline

03构造请求和腾讯爬虫

item

scrapy shell

07-scrapy-分布式

03-scrapy的一些坑

以爬取当当为例,以即使没有scrapy.cfg文件,亦可以启动,但似乎没有加载settings.py的文件,一脸懵逼,redis的信息也没有

PYTHONPATH=$(pwd) python3 -m scrapy runspider spiders/dd_book.py

lpush dd_book http://category.dangdang.com/?ref=www-0-C

.

├── dangdang_book

│ ├── __pycache__

│ │ ├── middlewares.cpython-37.pyc

│ │ └── settings.cpython-37.pyc

│ ├── items.py

│ ├── middlewares.py

│ ├── pipelines.py

│ ├── settings.py

│ └── spiders

│ ├── __init__.py

│ ├── __pycache__

│ │ ├── __init__.cpython-37.pyc

│ │ └── dd_book.cpython-37.pyc

│ └── dd_book.py

└── scrapy.cfg

4 directories, 11 files

在根目录中,自己手动加上scrapy.cfg文件后(原始文件应该就有),启动

PYTHONPATH=$(pwd) python3 -m scrapy crawl dd_book

lpush dd_book http://category.dangdang.com/?ref=www-0-C