1、之前因为学习scrapy爬虫框架,奈何使用win的cmd命令:pip install scrapy老下载失败;

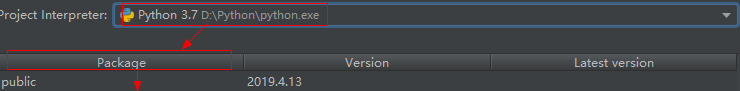

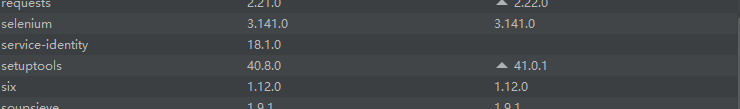

失败检测:第三方包安装之后都会在file(文件)->settings(设置)->project XXX(项目XXX)->project interpreter这个环境里面,我们看看有没有scrapy,没有就是安装失败

显然没有!!!

2、若错误信息提示pip版本太低,然后我就通过 cmd命令:python -m pip install --upgrade pip升级到最新版之后再去下载,然后还是下载失败;

3、我尝试从PyCharm下载scrapy

下载仍然失败后!!!!!日志上出现了details信息,没啥用处!!

4、因此选择了使用Anaconda下载,安装过程请见Anaconda安装(不仅仅是下载不了的问题,使用scrapy需要下载很多依赖包,所以使用Anaconda将会自动安装scrapy的依赖包)

5、安装完毕之后,创建了scrapy项目,请见scrapy项目创建

6、

(1)在这里你创建Python文件之后,使用import scrapy报No Module错误,这就纳了闷了,我们已经通过Anaconda下载了最新版的scrapy了啊,为什么会报没这个模块呢,是因为我们使用的还是之前pip的解释器,里面自然没有,所以就要使用Anaconda的解释器

(2)先明确一个信息:python的第三方包安装之后显示在site-packages里面的,我们去看看那里有没有scrapy!!

![]()

这里自然是没有的~~

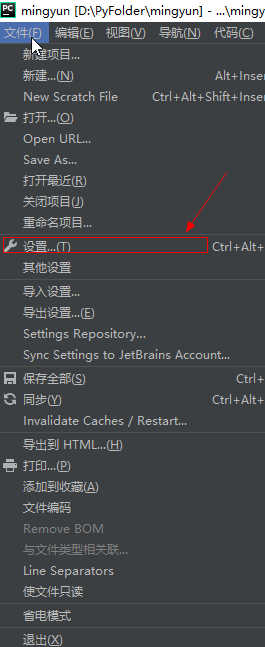

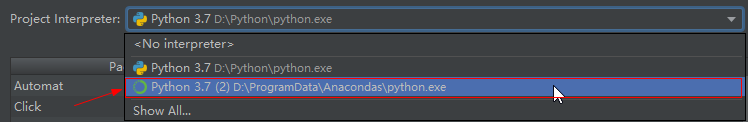

现在配置Anaconda解释器

点开文件(file)

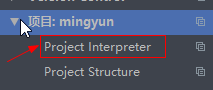

点开项目(project)->项目面板(Project Interpreter)

原始是默认的pip的包环境

![]()

设置完之后,面板上就会出现一条新的环境,选中应用确认即可

看到这个表示修改完成,包的路径也从原始pip包环境的路径转变为了Anaconda包环境的路径

注意,该修改完不能立马就使用,需要静静等待Pycharm慢慢加载完成才可!

注:年轻就要多读书!!!