1. 对抗攻击的概念

ML算法的输入形式为数值型向量,攻击者可以设计一种针对性的扰动生成对抗样本,

让机器学习模型出现误判,称为对抗性攻击;对抗性攻击分为两种:

- 黑盒攻击(blck-box attack)

黑盒攻击的攻击者不知道机器学习的算法和参数,攻击者产生对抗性数据(adversarial permutation)的过程中可以与机器学习 系统有所交互。

- 白盒攻击(white-box attack)

白盒攻击的攻击者可以获知机器学习使用的算法与参数,在产生对抗性攻击数据的过程中与机器学习系统有所交互。

2. 针对分类网络的攻击方法

2.1 Box-constained L-BFGS

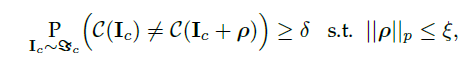

该方法思想为试图求解让神经网络做出误分类的最小扰动的方程,即 ![]()

由于问题的复杂度较高,因此转而求解简化后的问题,即寻找最小的损失函数的添加项,使模型做出误分类:

2.2 FGSM

该方法主要对对抗性扰动(adversarial permutation)进行直接求解,在GoodFellow的原文中为:

![]()

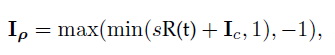

Kurakin等提出了FGSM的变种(one-step target class),使用了识别概率最小的类别代替了对抗扰动中的类别变量,再从原始图像减去求解的扰动得到对抗样本。

2.3 BIM & ILCM

one-step方法通过一大步增大分类器的损失函数进行图像扰动,可以将其扩展为多个小步增大损失函数的变体,为BIM:

![]()

将类别变量替代为识别概率最小的类别即为ILCM。

2.4 JSMA

对抗性文献中一般主要限制扰动的l_2和l_∞范数使得对抗样本中的扰动难以被察觉,JSMA主要对l_0范数进行限制,这样仅改变了几个像素的值而不是整个图像。

2.5 One Pixel Attack

该方法为一种极端的攻击方法,可以仅改变图像的一个像素值使攻击成功,Su等人使用差分进化算法,对每个像素进行迭代的修改,从而生成子图像,并与母图像进行对比。依照标准对攻击效果最好的子图像进行保留以实现对抗共对抗攻击。

2.6 C&W

作者提出三种攻击方法,限制l_∞、l_2、l_0范数使扰动无法被察觉,算法生成的对抗扰动可以进行迁移从而实现黑箱攻击。

2.7 Deepfool

主要通过迭代计算的方法生成范数最小的对抗扰动,将位于分类边界内的图像逐步移到界外,直至分类错误。

2.8 Universal Adcersarial Pertuibations

可以实现对任何图像的攻击,思想与Deepfool类似,但是扰动针对所有的图像。

2.9 UPSET and ANGRI

UPSET可以为特定类别生成对抗扰动,扰动添加的图像被分类成为特定的类别。

UPSET生成的扰动为image-agnostic;ANGRI生成的扰动为image-specific。

2.10 Houdini

主要用于欺骗基于梯度的机器学习算法,可以通过生成特定于任务的损失函数的对抗样本实现对抗攻击,也就是利用网络的可微损失函数的梯度信息生成对抗扰动。

2.11 ATNs

训练神经网络生成对抗样本,可用于攻击一个或多个网络。ATNs最小化联合损失函数生成对抗样本,联合损失函数有两个部分,第一部分使对抗样本与原图像保持相似,第二部分使对抗样本被误分类。

Reference:

[1] https://www.jiqizhixin.com/articles/2018-03-05-4(攻击方法主要搬运于此)

[2] Akhtar N, Mian A. Threat of adversarial attacks on deep learning in computer vision: A survey[J]. IEEE Access, 2018, 6: 14410-14430.