目标检测常用概念:https://zhuanlan.zhihu.com/p/290833705?utm_source=wechat_session

1、IOU:交并比,是衡量模型生成的Detectoin Result和人工标注的Ground Truth之间的重叠度

2、公式:IOU=∩\∪

3、GT:Ground Truth 标准答案

4、DR:Detection Result 检测结果

5、Bounding Box:边界框

6、NMS:NMS即非极大抑制,去除低IOU值的边界框和重叠重读高的边界框。

7、边界框回归:

8、mAP(平均准确度均值)

(1)mAp:mean Average Precision mean:均值 average:平均的 precision:精确度、准确度,所有类别AP的平均值。

(2)PR曲线:Precision-Recall曲线

(3)Precision:TP/(TP+FP) 预测正确的部分 占 预测结果 的比例

(4)Recall: Recall=TP/TP+FN 预测正确的部分 占真实答案的比例

(5)TP:IoU>0.5的检测框的数量(与同一Ground Truth计算的结果) FP:IoU<=0.5的检测框的数量 FN:将GT检测为负类的数量(没有检测到GT的数量)

(6)TP:(True Positives)真的正样本=【正样本 被正确分为 正样本 】IoU>=0.5的检测框的数量

(7)TN:(True Negatives)真的负样本=【负样本 被正确分为 负样本】

(8)FP:(False Positives)假的正样本=【负样本 被错误分为 正样本】IoU<=0.5的检测框的数量

(9)FN:(False Negatives)假的负样本=【正样本 被错误分为 负样本】将GT检测为负类的数量(没有检测到GT的数量)

(10)fps:frames per second 每秒帧数,即每秒处理的图片数量或者处理每张图片所需的时间,在同一硬件条件下进行比较。

(11)FLOPs(Forward Pass计算量):floating point operations per second 每秒浮点运算次数,理解为计算速度。是一个衡量硬件性能的指标。

(12)feature map输出特征值:在CNN设定里,Feature Map是滑稽核滑出来的,用各种情况下的滑稽核去乘以原图,会得到各种各样的feature map。可以理解为从多个角度去分析图片,不同的特征提取(滑稽核-滑稽图片)会提取不同的feature。

概念:在cnn(滑稽神经网络)的每个卷积层,数据都是以三维形式存在的。许多个二维图片叠在一起(豆腐皮竖直的贴成豆腐块),其中每一个称为一个feature map。

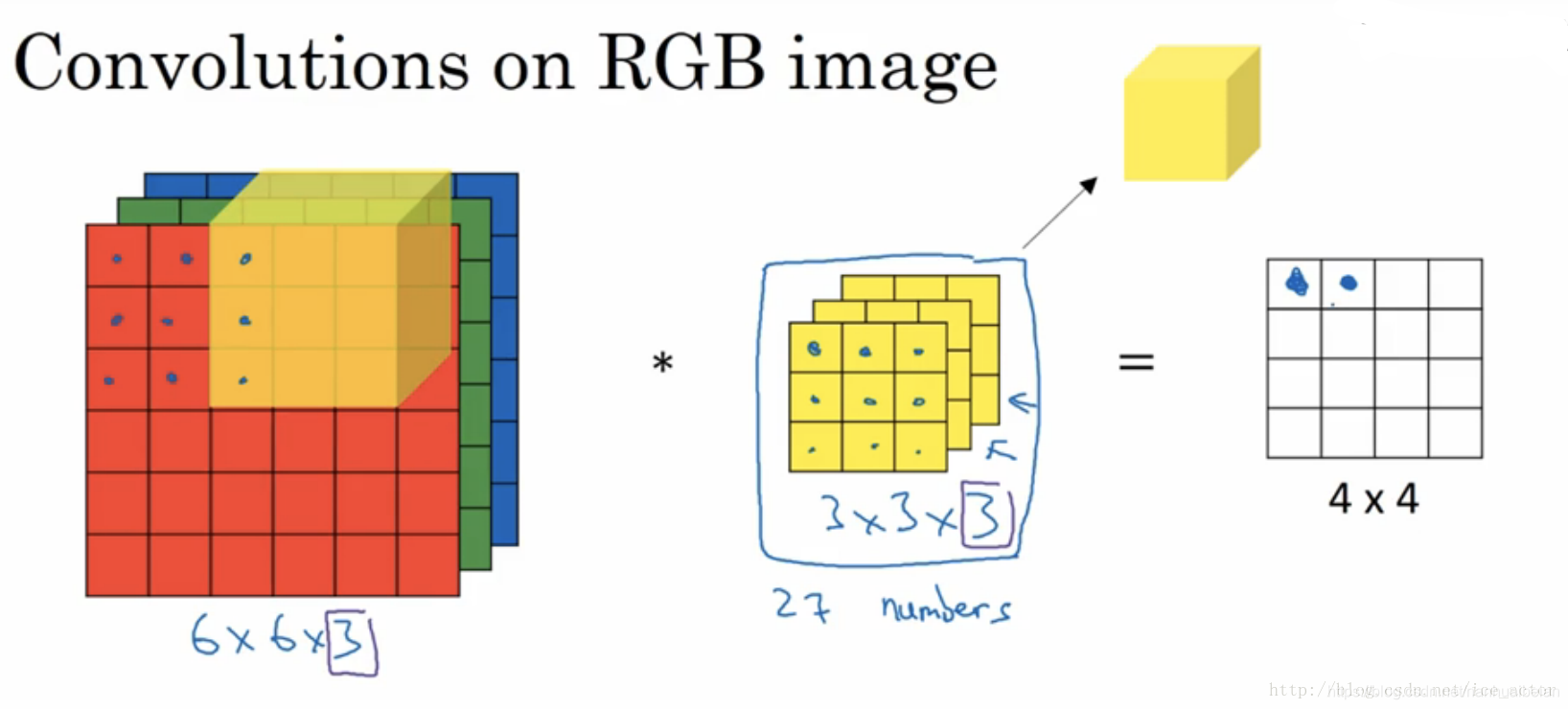

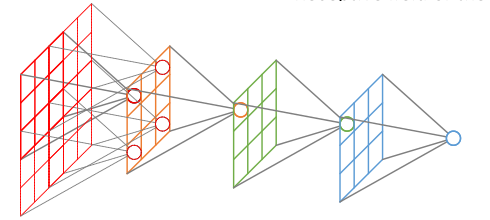

构建:在输入层,如果是灰度图片,那只有一个feature map,如果是彩色图片(RGB)一般就是3个feature map(红绿蓝)。下图中三大部分依次是输入RGB图片,卷积核(也称过滤器),卷积结果(输出),*代表卷积操作。最左部分三片代表3个feature map。如果是灰色图片(二维),则最左只有一片代表一个feature map,对应的卷积核(过滤器也是二维)。其它层:层与层之间会有若干个卷积核(kernel)(也成为过滤器),上一层每个feature map跟每个卷积核做卷积,都会产生下一层的一个feature map,有N个卷积核,下层就会产生N个feature map

作用:在卷积神经网络中,我们希望用一个网络模拟视觉通路的特性,分层的概念是自底向上构造简单到复杂的神经元。我们希望构造一组基,这组基能够形成对于一个事物完备的描述,例如描述一个人时我们通过描述身高/体重/相貌等,在卷积网络中也是如此。在同一层,我们希望得到对于一张图片多种角度的描述,具体来讲就是用多种不同的卷积核对图像进行滑稽,得到不同核(描述)上的相应,作为图像的特征。他们的联系在于形成图像在同一层次不同基上的描述。

(13)卷积核的定义

卷积核又称过滤器(filter)或内核(kernel)。卷积核可以将当前网络上的一个子节点矩阵转化为下一层神经网络上的一个单位节点矩阵,单位节点矩阵指的是高和宽都是1,但深度(长)不限的节点矩阵。

(14)输入数据

输入图片尺寸为:64*64*3,会把其转化成1个向量,(向量可以理解为1*n或n*1的数组,前者为行向量,后者为列向量),那么这个向量的总维数就是64*64*3,结果就是12288,此图像在计算机中就是12288个数字。在人工智能领域中,每一个输入到神经网络的数据都被叫做一个特征。此输入图像就有12288个特征,这个12288维的向量也被叫做特征向量。神经网络接收这个特征向量作为输入,并进行预测。

观察下图:步骤1中的每个滑稽核(filter-1,filter-2,filter-3.....)实际上包含一组3个权重矩阵(Wt-R,Wt-G,Wt-B)。每个滑稽核中的三个权重矩阵分别用于处理输入图像中的红(R)、绿(G)、蓝(B)信道。在正向传播期间,图像中的R、G、B像素值分别于Wt-R,Wt-G,Wt-B权重矩阵相乘分别用于处理输入图像中的红(R)-绿(G)-蓝(B)信道。在正向传播期间,图像中的R、G和B像素值分别于Wt-R、Wt-G和Wt-B权重矩阵相乘以产生一个间歇激活映射(图中为标出),然后将这3个权重矩阵的输出(即3个间歇性激活映射)相加以为每个过滤器产生一个激活映射(activation map)

随后,这些激活映射中的每一个都要经过激活函数ReLU去线性化,最后到最大池化层,而后者主要为激活映射降维。最后我们得到的是一组经过激活函数和池化层处理后的激活映射,现在其信号分布在一组32个(滑稽核的数量)二维张量之中(也具有32个feature map,每个滑稽核会得到一个feature map)

来自卷积层的输出经常用作后续卷积层的输入。

(15)卷积层:卷积神经网络(CNN)一共有5个层级结构:输入层、卷积层、激活层、池化层、全连接层。

(16)感受野、局部连接:feature map上每个值仅对应着原图的一小块区域,原图上的这块局部区域称作感受野(receptive fiels)局部连接的思想,受启发于生物学里面的视觉系统,视觉皮层的神经元就是局部接受信息的。

(17)池化:保留特征的同时压缩数据量,池化(Pooling)也叫做下采样(subsampling),用一个像素代替原图上临近的若干像素,在保留feature map特征的同时压缩其大小。

池化的作用:

防止数据爆炸,节省运算量和运算时间。

用大而化之的方法防止过拟合、过学习。防止培养出高分低能,在考场(训练集)称霸但在社会上(测试集)混不下去的人工智障。

(18)随机梯度下降:在减小损失函数的过程中,采用步步为营的办法,单个样本单个样本输入进行优化,而不是将全部样本计算之后再同一优化。虽然个别样本会出偏差,但随着样本数量的增加,仍旧能够逐渐逼近损失函数最小值。前途是光明的,道路是曲折的。

(19)梯度:深度学习的架构和最新发展,包括CNN、RNN、造出无数假脸的GAN,都离不开梯度下降算法。梯度可以理解成山坡上某一点上升最快的方向,它的反方向就是下降最快的方向。想要以最快的方式下山,就要沿着梯度的反方向走。看起来就像沙盘推演的东西,其实就是我们撤出的小球,它们会沿着梯度下降的方式滚到谷底。

随机梯度下降:梯度下降算法的最终目的就是找到整个“地形”中的最低点(全局最小值),也就是海拔最低的山谷。但在这片地形中,山谷可能不止一处(局部最小值),所以我们需要撤很多球,让它们分别落入不同山谷,最后对比高度找出其中的海拔最低点。