声明:语音合成论文优选系列主要分享论文,分享论文不做直接翻译,所写的内容主要是我对论文内容的概括和个人看法。如有转载,请标注来源。

欢迎关注微信公众号:低调奋进

Lightweight LPCNet-based Neural Vocoder with Tensor Decomposition

本文章是日本NTT公司在interspeech2020发表的文章,主要工作使用张量分解方法来优化声码器lpcnet,整体加速1.26x,具体的文章链接

http://www.interspeech2020.org/index.php?m=content&c=index&a=show&catid=247&id=348

1 研究背景

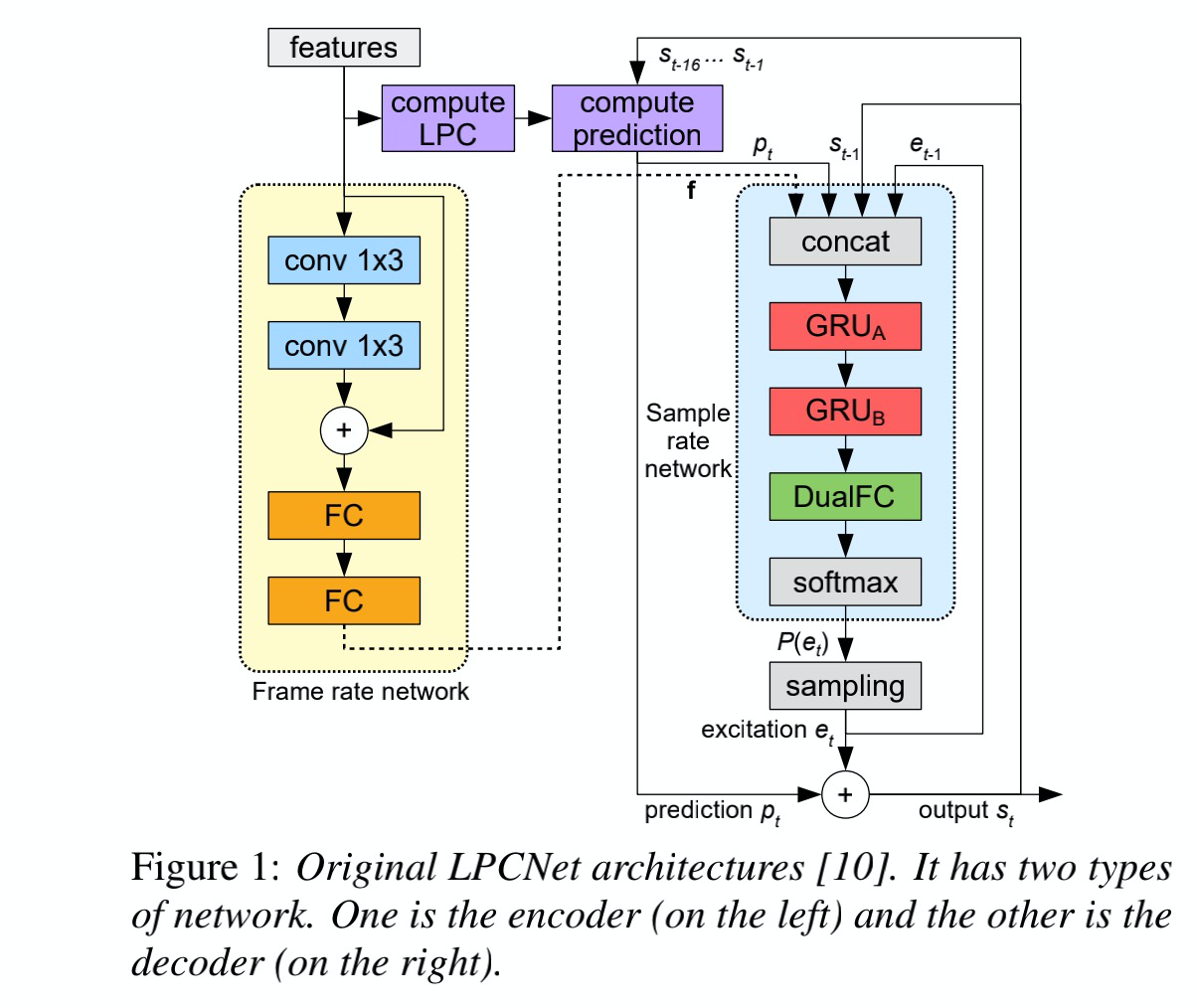

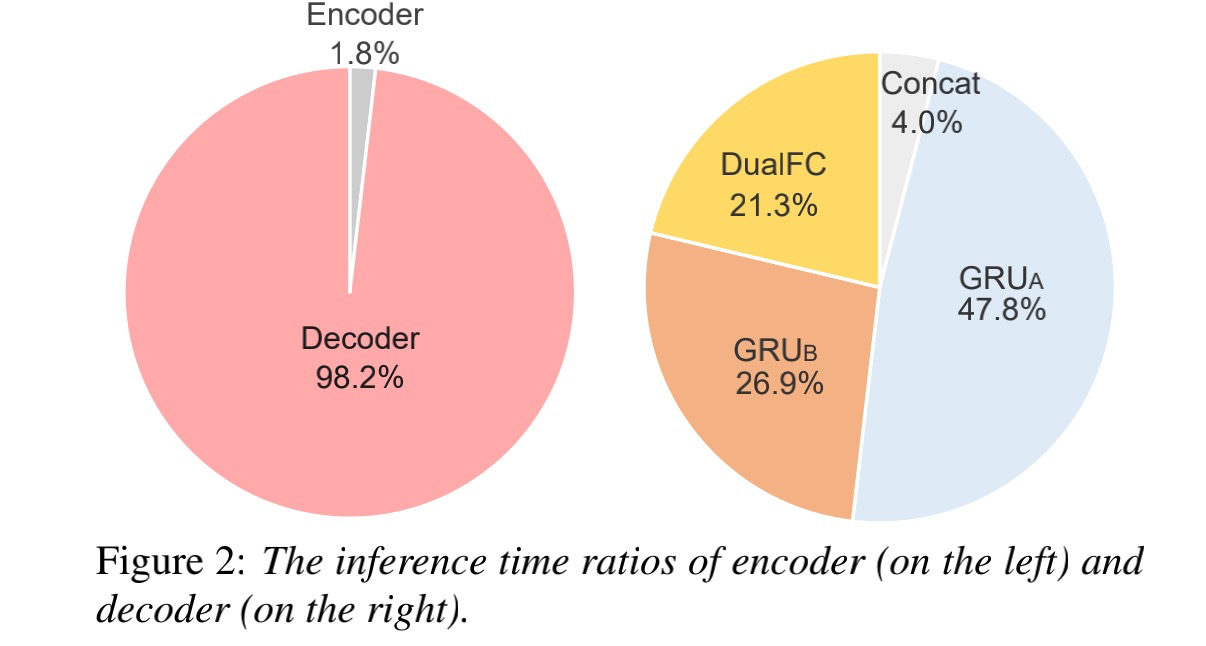

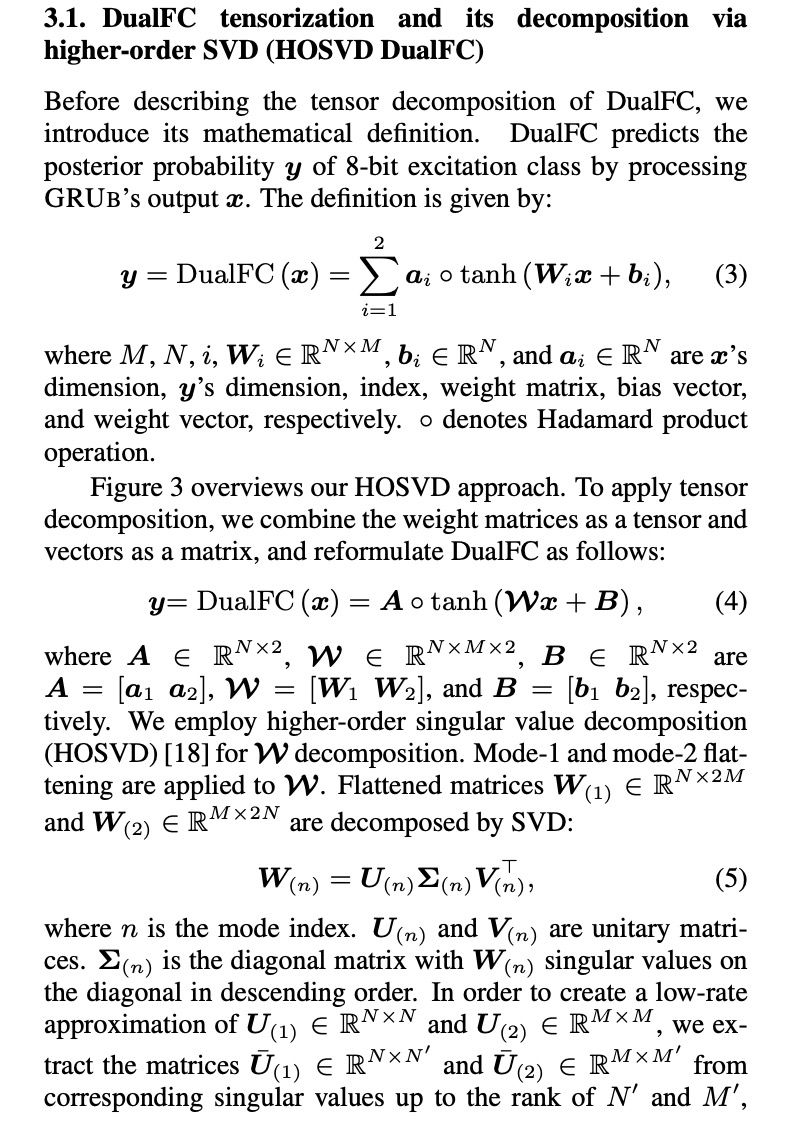

现在语音合成领域的主流声码器为wavenet,wavernn,lpcnet,melgan,waveglow等等,其中lpcnet由于低复杂度受到工业界和学术界的追捧。其中lpcnet的结构图为图1所示,做语音研究对其非常熟悉,在此不再浪费篇幅进行介绍,有兴趣的读者可以参考我前边总结的lpcnet。接下来说一下本文的动机,整个系统时间开销如图2所示,98.2%的时间开销在decoder中,另外grua层已经使用稀疏化进行优化后,decoder的中的grub+dualfc的时间开销占比48.2%,这也是本文优化的目标。

2 详细设计

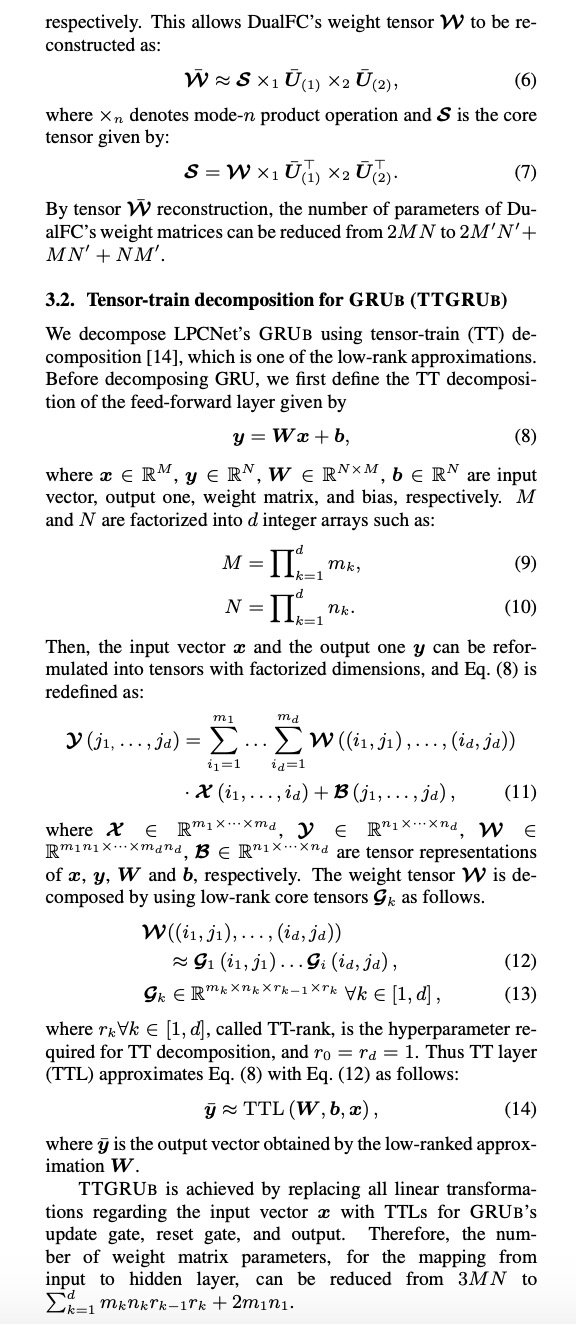

现在lpcnet的速度优化比较显著的方案有使用multiband, multi-sampling等等,效果非常显著,而本文使用tensor-decomposition来优化grub+ dualFC。(以前导师就说过,最怕搞数学的搞计算机,一大堆公式需要读,读了还未知能搞懂,本文公式还不算太多,但需要额外参考的知识就要许多,而且收益并不是太突出)本文对DualFC层使用高阶奇异值分解(HOSVD)对grub使用tensor-train decomposition(TTGrub)。其中DualFc的分解示意图为图三所示,把w1和w2合并一起当成高阶tensor进行分解,分解的公式为3.1小节所示。TTGrub的方法为小节3.2,其中tensor train需要额外参考资料学习。

3 实验结果

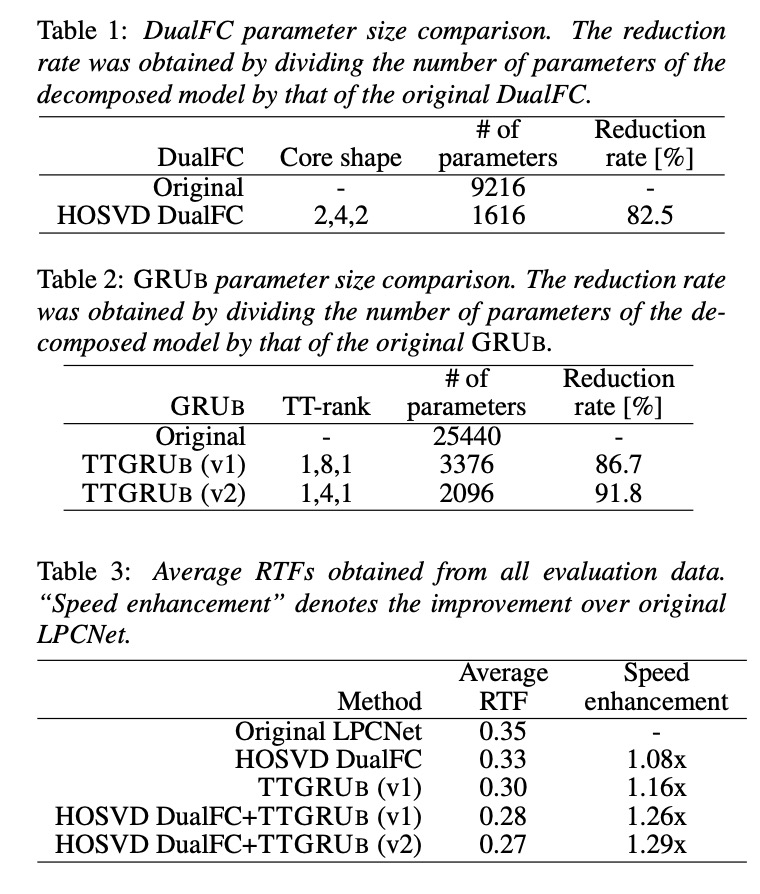

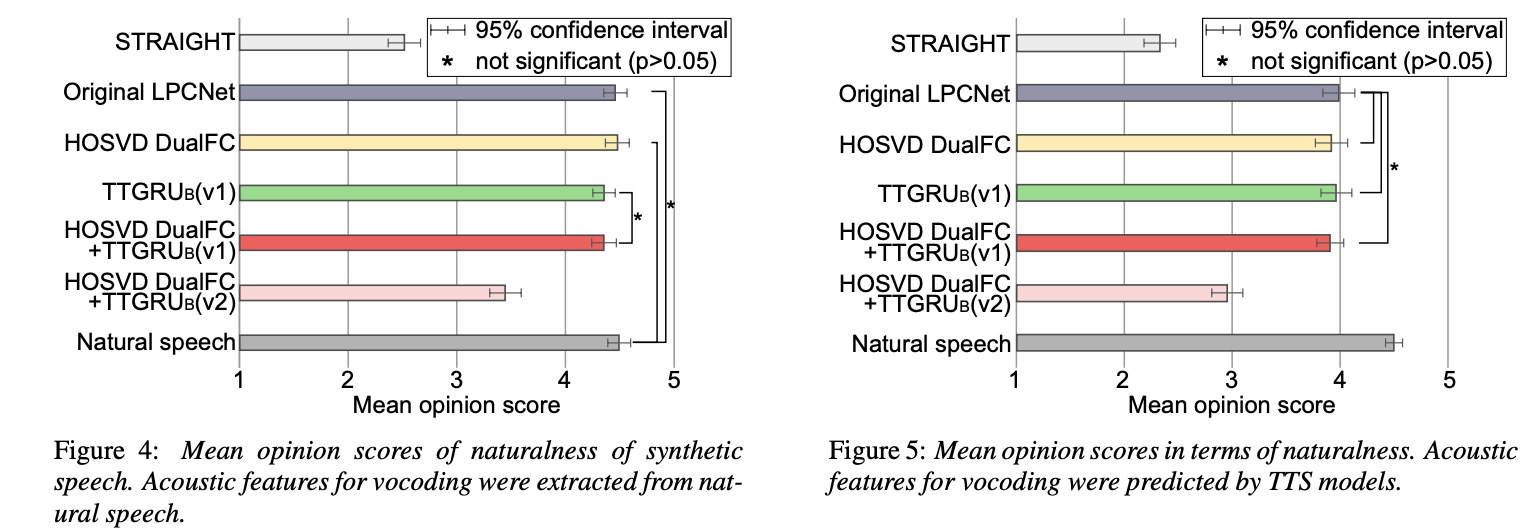

先看一下参数量的减少。table 1展示使用hosvd的dualFC的参数量减少82%,table2 展示使用TT的grub的参数量都减少86%以上。table2展示其实时率率加速,两者都使用可以加速1.26倍。图4和图5展示使用ground truth的声学特征和tts合成的声学特征的MOS值,可接受范围红色线为两者都使用较好版本。

4 总结

lpcnet的优化方案包括multiband, multi-sampling等等,效果非常显著,而本文使用tensor-decomposition来优化grub+ dualFC,速度提高1.26倍。(质量有点下降,但作为lpcnet的一个优化方向,先进性总结,多学无害)