Ketlle提供了hadoop集群的连接配置模块,在配置“Hadoop cluster”之前要做一些准备工作,将集群中的相关配置文件复制到kettle中的目录中,替换掉原目录中的文件。

1. 需要的配置文件:core-site.xml、hdfs-site.xml、yarn-site.xml、mapred-site.xml、hbase-site.xml、hive-site.xml,这些配置文件中前四个是连接hadoop所必须的,后面的两个看具体需求,如果也需要那就需要在集群中拷贝下来。

2. 文件存放路径:E:\kettle-8.2\data-integration\plugins\pentaho-big-data-plugin\hadoop-configurations\cdh514

最后一级目录主要看所使用的大数据平台是什么,将从集群拷贝的配置文件替换掉原目录中的文件就可以了。

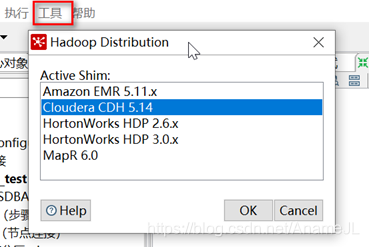

3. 然后点击kettle左上角的“工具”->点击“Hadoop Distribution”->选择和服务器大数据平台对应的类型,如下图所示

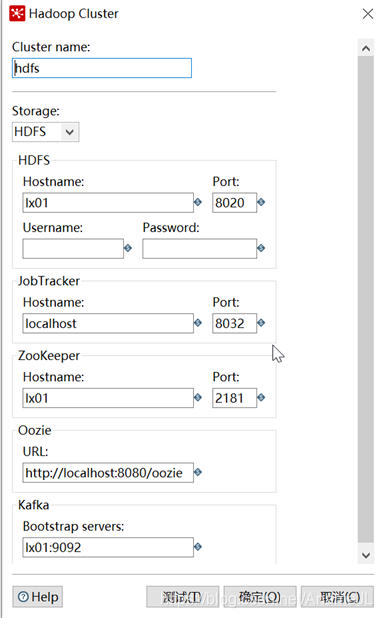

4. 准备工作完成后,鼠标右键“Hadoop cluster”->新建,具体配置内容根据集群中的软件决定,如下图所示

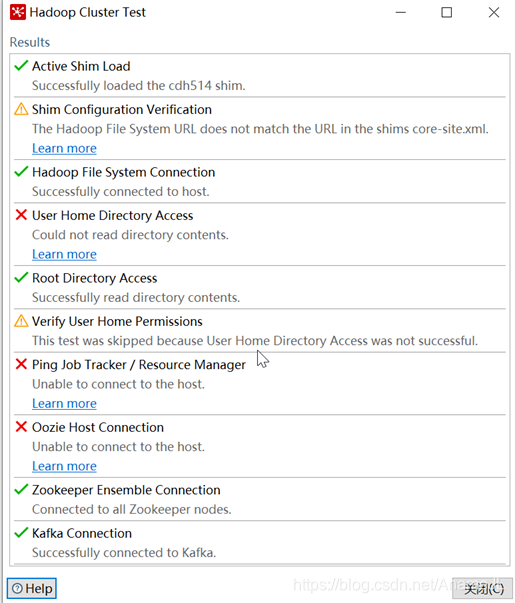

5. 配置完成点击测试,如果出现下图所示内容就证明连接上了

可以看到,根据大数据平台实际情况所配置的软件都已经建立连接了(前提是服务都是开启的),在配置好连接后,后续使用相关组件直接选择此连接就可以了。