AW-Convlution

参考

创新点

- 提出当前注意激活模型的两个问题:

- 特征图的近似问题和容量不足问题

- 提出AW-convolution结构来缓解这个问题

问题&思想描述

-

个人认为,这两个问题其实是一个问题,即特征图的近似问题,而容量不足问题更多可以表述为作者为解决自己提出的AW-Convlution结构不能对每个channel做独特的channel而提出的问题(后来应该是变成多个filter解决的)

-

此前的注意力通常可以分为Channel Attention和Spatial Attention,但这样只能达到逼近自适应校准的效果,而真正要达到自适应校准的话则是需要计算得到和Feature Map同样大的Attention Map然后点积才行,但是这样计算量太大(注意是有FC产生同样大小的map)

-

比如CBAM,这个模型就是典型的channel+spatial结合的模型,但是还是属于上面提到的模型,所以存在近似问题

-

-

然后作者收到卷积的启发,提出用卷积替代FC作为多通道、区域的注意力机制,这样不仅有效减少了参数量,而且相对FC比较好训练(这句话文中没说,是我加的),即如下面公式所示,其中A就是代表着卷积核,K代表原来就要计算的卷积,I是输入,x代表卷积操作。

-

-

然后在通道上用多个卷积分别对每一层通道进行注意力校准(其实就是用多个filter而已)

-

-

合并一下就是行下面的样子,这就是AW-Convlution

-

-

模块结构

-

上节提出的公式对应这里:

-

-

然后往下推就是AK,这里作者在AK这里加了个残差边的操作,目的是希望保留K的权重的同时拿到A的权重做注意力,这就是F2,接下来就是F1的实现,如下图:

-

-

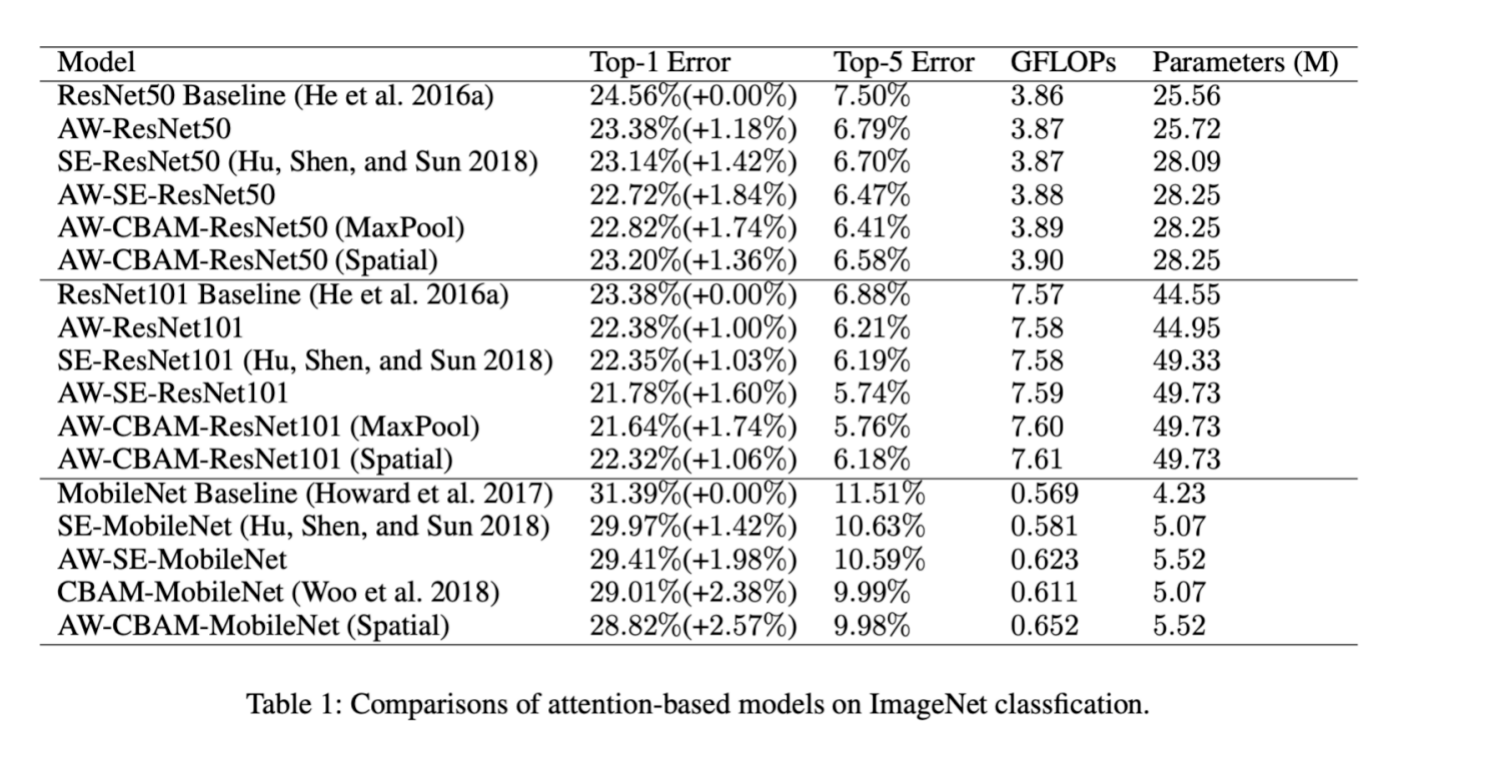

上图给出了F1的公式,其中先经过平均池化,然后做两个pointwise convlutions(参见Xception中提出的卷积方法,即用N个1x1xM的卷积,得到N层特征图),以上就是模块的全部流程,值得一提的是,这玩意可以和SE/CBAM这些共用,同样有效果,且不冲突。

扫描二维码关注公众号,回复: 13362654 查看本文章

-

实验结果

-

-

突然发现作者似乎藏了CBAM的对比实验,想来应该是AW+CBAM的效果相对于CBAM并没有显著提升吧~,因此该方法的理论部分可能还存疑