文章目录

Spark单机版环境

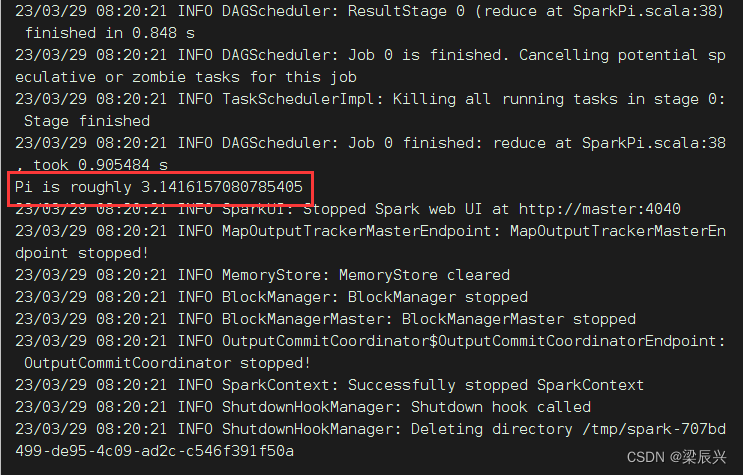

(一)使用SparkPi来计算Pi的值

执行命令:run-example SparkPi 2 (其中参数2是指两个并行度)

查看计算结果:Pi is roughly 3.1412357061785308

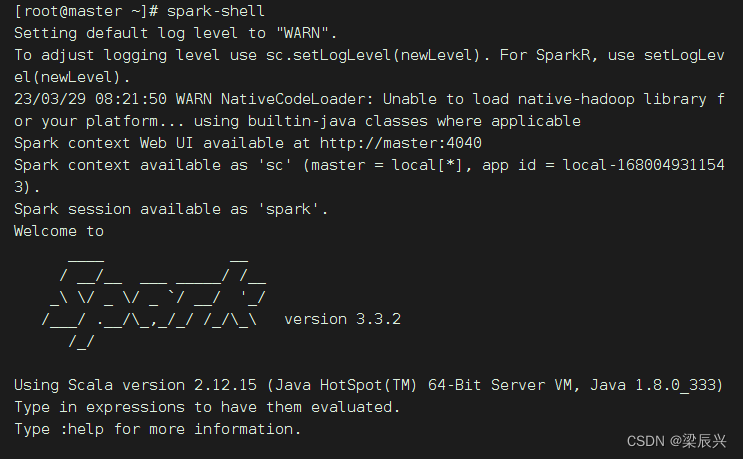

(二)使用Scala版本Spark-Shell

执行spark-shell命令,启动Scala版的Spark-Shell

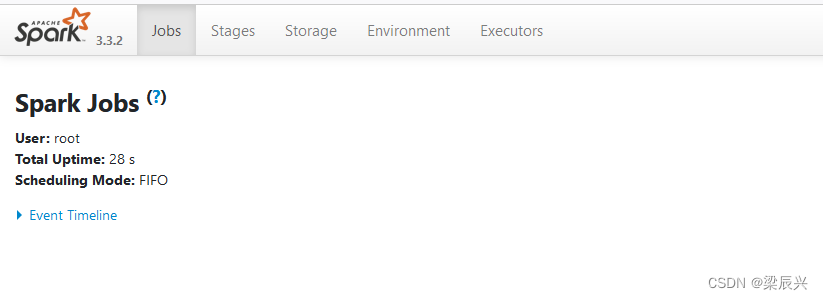

访问Spark的Web UI界面 - http://master:4040

注意:Spark 3.3.2使用的Scala版本其实是2.12.15

利用print函数输出了一条信息

println("welcome to spark world!")

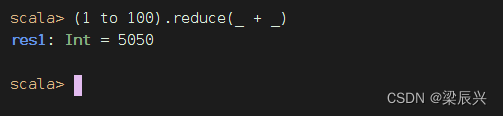

计算1 + 2 + 3 + …… + 100

(1 to 100).reduce(_ + _)

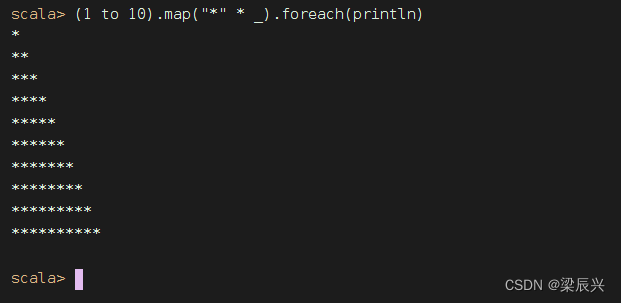

输出字符直角三角形

(1 to 10).map("*" * _).foreach(println)

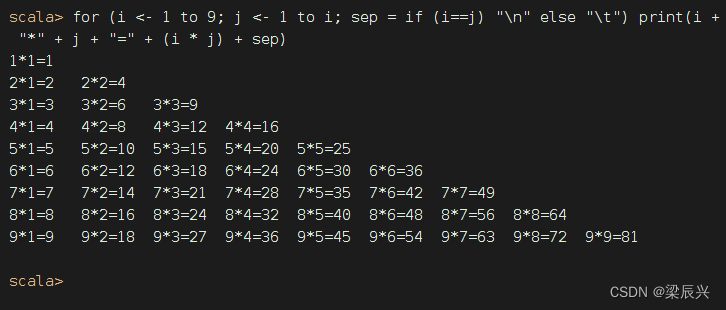

打印九九乘法表

for (i <- 1 to 9; j <- 1 to i; sep = if (i==j) "\n" else "\t") print(i + "*" + j + "=" + (i * j) + sep)

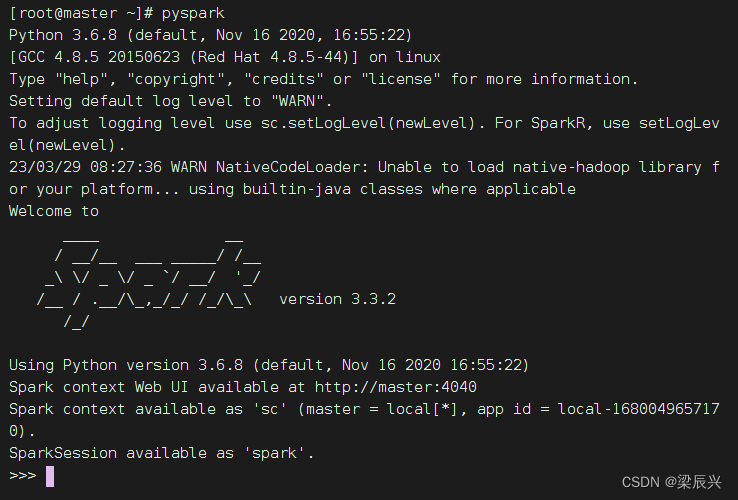

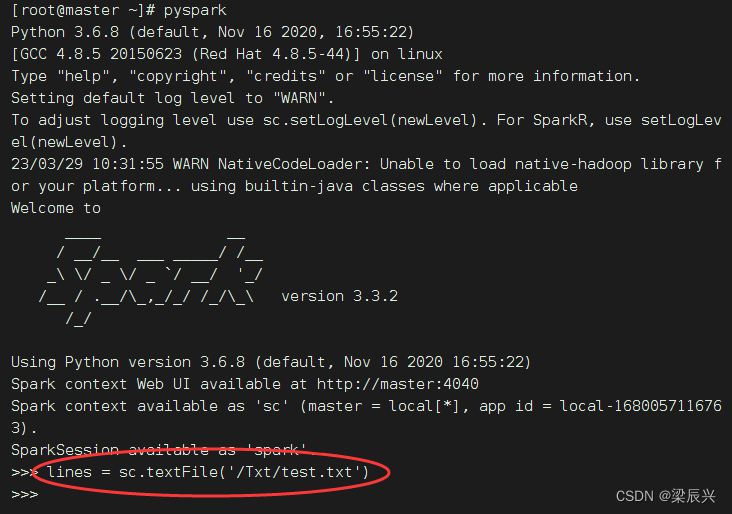

(三)使用Python版本Spark-Shell

执行pyspark命令启动Python版的Spark-Shell

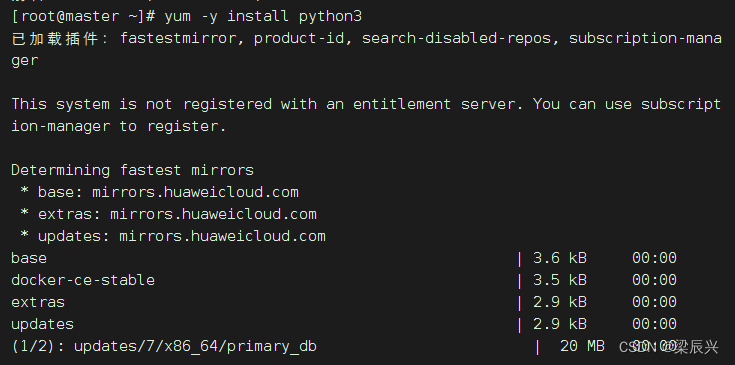

安装python3

执行:pyspark

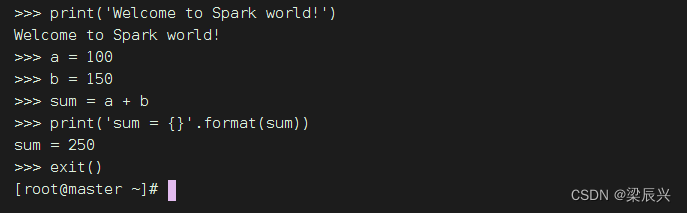

输出一条信息,进行加法运算,然后退出交互式环境

(四)初识弹性分布式数据集RDD

Spark 中的RDD (Resilient Distributed Dataset) 就是一个不可变的分布式对象集合。每个RDD 都被分为多个分区,这些分区运行在集群中的不同节点上。RDD 可以包含Python、Java、Scala 中任意类型的对象,甚至可以包含用户自定义的对象。用户可以使用两种方法创建RDD:读取一个外部数据集,或在驱动器程序里分发驱动器程序中的对象集合(比如list 和set)。

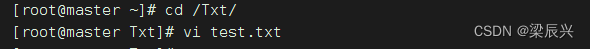

在/Txt目录下创建test.txt文件

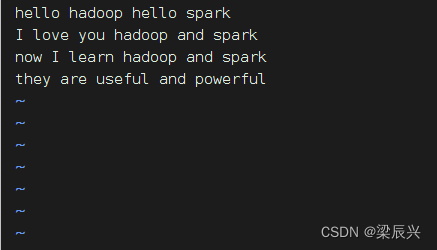

添加如下内容:

hello hadoop hello spark

I love you hadoop and spark

now I learn hadoop and spark

they are useful and powerful

例1、创建一个RDD

在pyspark命令行,执行命令:lines = sc.textFile('/Txt/test.txt')

创建出来后,RDD 支持两种类型的操作: 转化操作(transformation) 和行动操作(action)。转化操作会由一个RDD 生成一个新的RDD。另一方面,行动操作会对RDD 计算出一个结果,并把结果返回到驱动器程序中,或把结果存储到外部存储系统(如HDFS)中。

例2、调用转化操作filter()

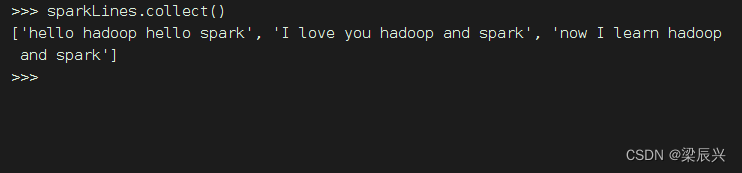

执行命令:sparkLines = lines.filter(lambda line: 'spark' in line)

例3、调用行动操作first()

执行命令:sparkLines.first()

转化操作和行动操作的区别在于Spark 计算RDD 的方式不同。虽然你可以在任何时候定义新的RDD,但Spark 只会惰性计算这些RDD。它们只有第一次在一个行动操作中用到时,才会真正计算。这种策略刚开始看起来可能会显得有些奇怪,不过在大数据领域是很有道理的。比如,看看例2 和例3,我们以一个文本文件定义了数据,然后把其中包含spark的行筛选出来。如果Spark 在我们运行lines = sc.textFile(…) 时就把文件中所有的行都读取并存储起来,就会消耗很多存储空间,而我们马上就要筛选掉其中的很多数据。相反, 一旦Spark 了解了完整的转化操作链之后,它就可以只计算求结果时真正需要的数据。事实上,在行动操作first() 中,Spark 只需要扫描文件直到找到第一个匹配的行为止,而不需要读取整个文件。

如果要显示全部包含spark的行,执行命令:sparkLines.collect()