目录

前言

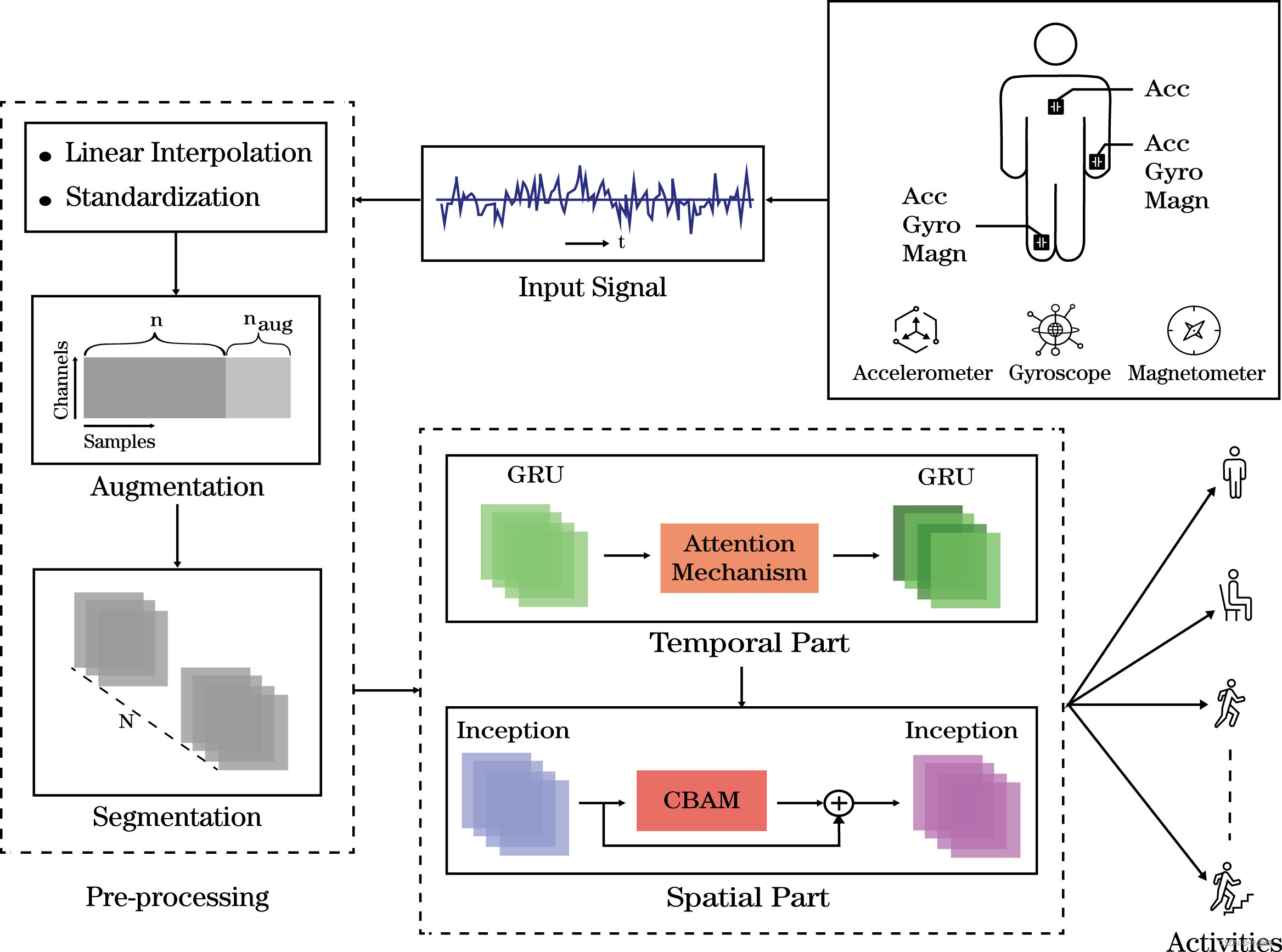

This week learned an article on initial attention-based recognition of human activity using GRU.In this study, it used the GRU and Inception modules, as well as attention mechanisms, to identify complex human activities.To further refine the features extracted from temporal and spatial data, CBAM blocks are added and merged into the starting module.Model parameters are reduced by replacing the fully connected layer with the GAP layer, resulting in faster model convergence, making the model more efficient.In addition, in terms of deep learning, I learned about GRU.

本周学习了一篇使用GRU进行人类活动识别的基于初始注意力的文章。在这项研究中,它使用GRU和Inception模块以及注意力机制来识别复杂的人类活动。为了进一步细化从时间和空间数据中提取的特征,添加了 CBAM 块并将其合并到起始模块中。通过将全连接层替换为GAP层来减少模型参数,从而使模型更快地收敛,从而使模型更加高效。除此之外,在深度学习方面,学习了GRU的相关内容。

文献阅读

--Taima Rahman Mim, Maliha Amatullah, Sadia Afreen, Mohammad Abu Yousuf, Shahadat Uddin, Salem A. Alyami, Khondokar Fida Hasan, Mohammad Ali Moni,

GRU-INC: An inception-attention based approach using GRU for human activity recognition,

Expert Systems with Applications,

2022,

119419,

ISSN 0957-4174,

https://doi.org/10.1016/j.eswa.2022.119419.

背景

人类活动识别被称为识别通过图像和视频序列或各种类型的传感器收集的各种日常人类活动的问题。它已成为最受欢迎的研究范围之一,因为它需要识别医疗保健、安全、智能家居、监控、体育等人类活动。HAR最关键的需求之一是检测老年人/病人活动的突然变化,以便立即采取行动。迄今为止,已经使用了各种技术来获得更可靠和精确的结果。对于人类活动识别,使用基于图像和基于传感器的数据。从可穿戴和智能手机嵌入式传感器收集的数据代表时间序列数据。在检测活动时,从经过一系列预处理技术的传感器收集低级数据,以获取有关这些活动的高级信息。

由于手工制作的特征提取方法需要人工工作并且更耗时,因此引入了神经网络。人工神经网络具有通过示例和事件进行学习的能力,并基于该学习产生输出;他们甚至可以在没有完全知识的情况下产生准确的输出。当神经元数量增加时,神经网络的效率和性能也会提高,但这也可能阻碍泛化能力并导致过拟合问题。神经网络的例子是卷积神经网络(CNN),CNN的变体,如Inception,残差神经网络ResNet等,以及递归神经网络(RNN),如GRU,长短期记忆(LSTM)。

主要贡献

本文的主要贡献可以概括为以下几点:

1.所提出的GRU-INC模型是一种高效的DL方法,包括时间部分的门控循环单位注意力机制(GRU-AM)和空间部分的初始卷积块注意力模块(Inception-CBAM),实现了显着的性能,降低了模型的复杂性。

2.CBAM与Inception模块一起首次在时间序列数据中实现,用于人类活动识别。

3.所提出的模型被证明是通用的,在五个公开可用的数据集上进行了评估,并实现了更高的准确性和最小的损失。

4.通过进行广泛的实验,验证了GRU-INC是一种有效的模型,其深度相对较小,相当宽。由于复杂性的降低,它显示出更好的性能,并且通过与现有模型和最先进的模型进行比较来证明这一点。

预处理

从运动传感器(如穿戴式、惯性测量单元 (IMU)、智能手机传感器等编译的原始信号数据采用 2D 格式,其中可能包括几个无效且多样化的数据维度。预处理对于优化数据并准备将其输入模型是必要的。这里的预处理已经通过以下四个步骤完成:

1.线性插值以恢复缺失值,

2.用于在同一尺度上调节值的Z分数标准化,

3.数据增强以增加数据集的大小

4.最后,分割,将输入序列拆分为固定长度的片段。在预处理阶段之后,原始 2D 信号数据已准备好以 3D 段的形式输入模型。

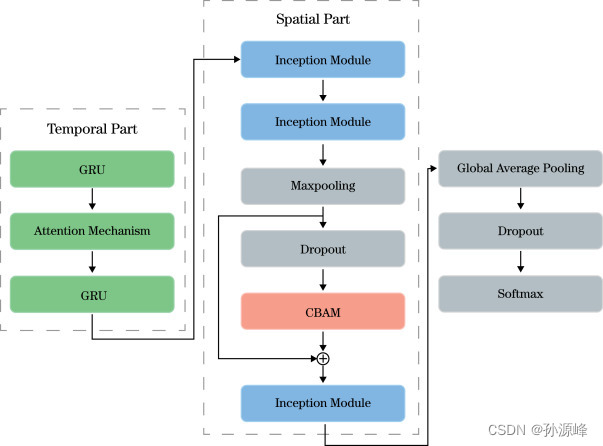

模型架构

在所提出的方法中,提出了GRU-INC:一种使用GRU进行人类活动识别的基于初始注意力的方法,其中模型架构由两部分组成:(i)时间特征提取和(ii)空间特征提取。图1显示了GRU-INC模型的整个过程。

时间特征提取

Xia 等人 (2020) 能够利用时间序列中传感器数据之间的时间关系,并且由于在特征提取过程中,RNN 依赖于过去和现在的数据,因此 RNN 专门用于其对时间序列数据的功效。在时间特征提取层中,GRU被选为适合所提出工作的RNN。GRU在门的数量方面比LSTM具有特殊优势(Chung,Gulcehre,Cho和Bengio,2014)。GRU 在训练期间使用较少的参数,因此它使用较少的内存,并且执行时间更快。

为了成功提取时态特征,使用了两个 GRU 块,包括它们之间的注意力块。GRU块的神经元数量分别设置为256和244。预处理的数据被送入第一个GRU块。

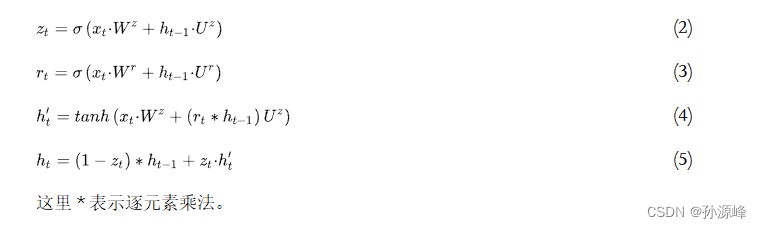

GRU获取预处理数据的不同模式,并使用两个门(更新门和复位门)来调整信息流,这两个门确定提供给输出的信息。复位门 rt调节信号输入 X 的方式t与先前的隐藏状态 h 相结合T-1 (2)和更新门Zt确定前一个内存的多少,hT-1被保存(3)。在GRU的帮助下,相关数据被保留以为每个输入时间步长输出一个隐藏状态h,从而传输到后续的网络时间步。

与GRU块结合的注意力机制强调获得的输出特征,并在分类过程中产生更大的影响。注意力模块更多地“关注”重要模式,并突出GRU的重要特征(Ma等人,2019)。

这里,输出隐藏状态ht的 GRU 作为输入,并生成随机权重 (W)。h的乘积的加法t和带有偏差的 W,然后对总数进行 tanh 操作,为每个模态 (6) 产生注意力权重 (e)。为了缩小 e,它通过 softmax 函数传递以获得规范化权重 a (7)。输入数据利用多个传感器,为了准确检测运动,使用注意力权重来反映不同传感器的相对相关性。输出特征图由归一化注意力权重与原始输入 h 相乘生成t (8).

在注意力机制之后,输出被馈送到另一个GRU块中,以允许更大的复杂性。由于输入已经是 GRU 层的结果,因此当前 GRU 会创建当前输入的复杂特征表示。第二个GRU可以通过注意力融合块中重要模态和无关紧要模态之间的权重差异来检测相当复杂的特征。

空间特征提取

CBAM模块的最终输出进一步通过另一个Inception模块,使用残差连接,后跟GAP层和Dropout层。创建一个残差连接,连接 Inception 和 CBAM 块的特征图,并防止由于梯度消失问题而导致的性能下降。添加GAP层,替换全连接层,以推断参数和模型,以更快地收敛。Dropout 层减少了模型的过拟合倾向。最后,添加Softmax层进行分类。

结论

本文介绍了一种基于深度学习的模型,该模型在识别复杂活动方面既高效又精确。拟议的GRU-INC分别是GRU和Inception在时间和空间部分的组合。GRU以及已在时间部分使用的注意力机制可以极大地改善特征提取。空间部分使用了增加了CBAM模块的Inception模块,进一步突出了特征图。为了达到更高的效率,所提出的模型使用全局平均池化(GAP)层,该层相对减少了模型参数的数量,并使模型比现有模型收敛得更快。所提出的模型已经针对五个公开可用的数据集进行了评估:UCI-HAR,OPPORTUNITY,PAMAP2,WISDM和Daphnet。

GRU-INC是一种新颖的HAR方法,它使用GRU和Inception模块以及注意力机制来识别复杂的人类活动。初始模块用于提高性能并减少参数数量。为了进一步细化从时间和空间数据中提取的特征,添加了 CBAM 块并将其合并到起始模块中。通过将全连接层替换为GAP层来减少模型参数,从而使模型更快地收敛,从而使模型更加高效。在本文中,所提出的模型通过在五个公开可用的数据集(如UCI-HAR,OPPORTUNITY,PAMAP2,WISDM和Daphnet)上评估获得高F1分数和较低损失来证明是推广的。在空间和时间部分分别采用注意力机制使GRU-INC能够检测具有挑战性的人类活动,这些活动主要包括OPPORTUNITY和PAMAP2数据集。在这些数据集中分别达到了 90.05% 和 90.31% 的 F1 分数。将所提出的模型与一些基线模型以及一些现有方法进行了比较,其中的F1分数高于每个模型。尽管所提出的模型在确定OPPORTUNITY数据集中的复杂活动方面显示出总体良好的性能率,但在区分一些类型相似的活动方面,它获得了较低的F1分数。此外,如果为活动提供不同特征的传感器浓度,则可以实现更好的复杂活动的识别率。

GRU

概念

GRU(Gate Recurrent Unit)是循环神经网络(Recurrent Neural Network, RNN)的一种。和LSTM(Long-Short Term Memory)一样,也是为了解决长期记忆和反向传播中的梯度等问题而提出来的。相比LSTM,使用GRU能够达到相当的效果,并且相比之下更容易进行训练,能够很大程度上提高训练效率,因此很多时候会更倾向于使用GRU。

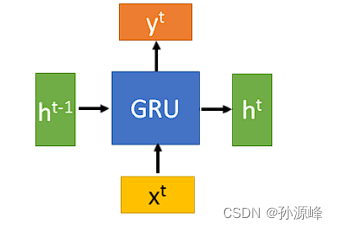

输入输出结构

GRU的输入输出结构与普通的RNN是一样的。

有一个当前的输入 xt ,和上一个节点传递下来的隐状态(hidden state) ht−1 ,这个隐状态包含了之前节点的相关信息。

结合 xt 和 ht−1,GRU会得到当前隐藏节点的输出 yt 和传递给下一个节点的隐状态 ht 。

GRU的内部结构

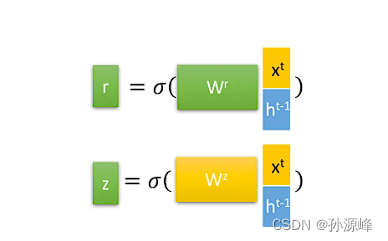

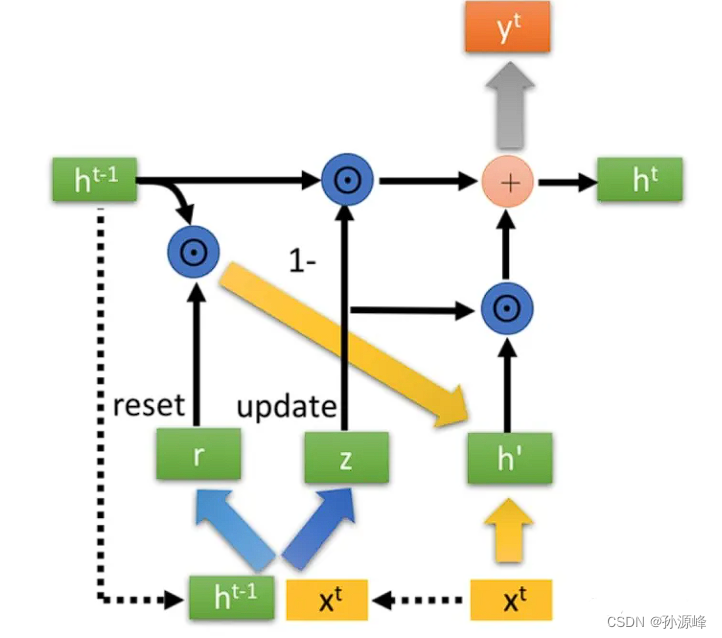

首先,我们先通过上一个传输下来的状态 ht−1 和当前节点的输入 xt 来获取两个门控状态。如下图所示,其中 r 控制重置的门控(reset gate), z 为控制更新的门控(update gate)。

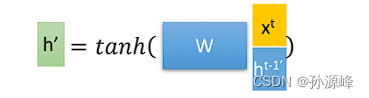

得到门控信号之后,首先使用重置门控来得到“重置”之后的数据 ht−1′=ht−1⊙r ,再将 ht−1′ 与输入 xt 进行拼接,再通过一个tanh激活函数来将数据放缩到-1~1的范围内。即得到如下图所示的 h′ 。

这里的 h′ 主要是包含了当前输入的 xt 数据。有针对性地对 h′ 添加到当前的隐藏状态,相当于”记忆了当前时刻的状态“。

最后介绍GRU最关键的一个步骤,我们可以称之为”更新记忆“阶段。

在这个阶段,我们同时进行了遗忘了记忆两个步骤。我们使用了先前得到的更新门控 z (update gate)。

更新表达式: ht=(1−z)⊙ht−1+z⊙h′

首先再次强调一下,门控信号(这里的 z )的范围为0~1。门控信号越接近1,代表”记忆“下来的数据越多;而越接近0则代表”遗忘“的越多。

GRU很聪明的一点就在于,我们使用了同一个门控 z 就同时可以进行遗忘和选择记忆(LSTM则要使用多个门控)。

- (1−z)⊙ht−1 :表示对原本隐藏状态的选择性“遗忘”。这里的 1−z 可以想象成遗忘门(forget gate),忘记 ht−1 维度中一些不重要的信息。

- z⊙h′ : 表示对包含当前节点信息的 h′ 进行选择性”记忆“。与上面类似,这里的 (1−z) 同理会忘记 h′ 维度中的一些不重要的信息。或者,这里我们更应当看做是对 h′ 维度中的某些信息进行选择。

- ht=(1−z)⊙ht−1+z⊙h′ :结合上述,这一步的操作就是忘记传递下来的 ht−1 中的某些维度信息,并加入当前节点输入的某些维度信息。

图中的 ⊙ 是Hadamard Product,也就是操作矩阵中对应的元素相乘,因此要求两个相乘矩阵是同型的。 ⊕ 则代表进行矩阵加法操作。

总结

下周我们继续学习注意力机制。