torch版本 1.9.0

from torch.utils.tensorboard import SummaryWriter

#创建日志文件,记录实验运行中的各项数据

writer = SummaryWriter(comment=f'MODEL_{args.model}_EPS_{args.n_iter}_BS_{args.batch_size}_LOSS_{args.sim_loss}_GPUID_{arg.gpu}')

原始初始化代码如下:

def __init__(self, log_dir=None, comment='', purge_step=None, max_queue=10,

flush_secs=120, filename_suffix='')

from torch.utils.tensorboard import SummaryWriter

writer = SummaryWriter()

writer.close()

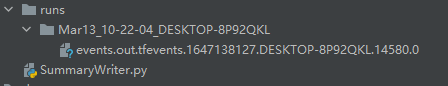

执行以上代码会在.py并行文件夹下生成一个runs文件(默认,writer = SummaryWriter('123则生成的文件夹命名为123),并在其下生成以后个包含时间和电脑信息的文件夹,文件夹下是时间文件。

log_dir(字符串):表示日志存放的地址,指定地址后在指定位置生成时间文件

writer = SummaryWriter(log_dir='runs')

结果:

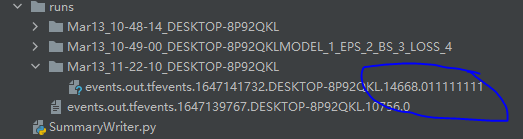

comment(字符串):在生成的runs文件夹下创建一个以时间与设备名+comment命名的文件夹,如果指定log_dir的话则忽略comment指令,即不会创建文件夹仅创建事件文件。

writer = SummaryWriter(comment='MODEL_1_EPS_2_BS_3_LOSS_4')

结果:

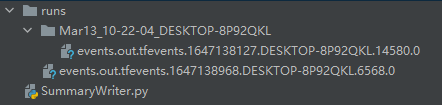

purge_step(整形):当日志在步骤:math:T+X 崩溃并在步骤:math:T 重新启动时,global_step 大于或等于:math:T 的任何事件都将从 TensorBoard 中清除并隐藏。 请注意,崩溃和恢复的实验应该具有相同的“log_dir”。这个没看懂。

max_queue (整形):在“添加”调用之一强制刷新到磁盘之前,挂起事件和摘要的队列大小,10个信息一轮达到10件必须写入文件一次。 默认为十项。

flush_secs(整形):将挂起的事件和摘要刷新到磁盘的频率(以秒为单位)将信息写入文档的时间间隔。 默认为每两分钟一次。

filename_suffix(字符串):在事件加的后缀信息。

writer = SummaryWriter(filename_suffix='11111111')

结果:

向文件里录入信息 add_scalar

writer.add_scalar( tag, scalar_value, global_step=None, walltime=None, new_style=False)

tag(字符串):数据标识符。

scalar_value(浮点型字符串):需要保存的值。

global_step(整形):要记录的全局步长值,有人说是时间步数(x轴)。

walltime(浮点型):可选在事件在结束epoch后以秒覆盖默认壁挂时间(walltime)。

new-style(布尔值):选择使用张量字段还是值字段,张量字段可以加快写入,默认为值字段。