1.池化层:提取重要信息,去掉不重要信息,减少参数,减少计算开销,防止过拟合。

2.全连接层(FC):在整个卷积神经网络起“分类器”的作用。

3.激活函数:给神经元引入了非线性因素,进而提升网络的表达能力。

4.backbone:主干(骨干)网络,一般是指提取特征的网络,其作用就是提取图片中的信息,供后面的网络使用。

5.反向传播:在反向传播中,网络的运动是向后的,误差随梯度从外层流入,穿过隐含层,权重被更新。

6.超参数:是在开始学习过程之前设置值的参数,而不是通过训练得到的参数数据。

7. normalization:数据标准化处理,以解决数据指标之间的可比性。

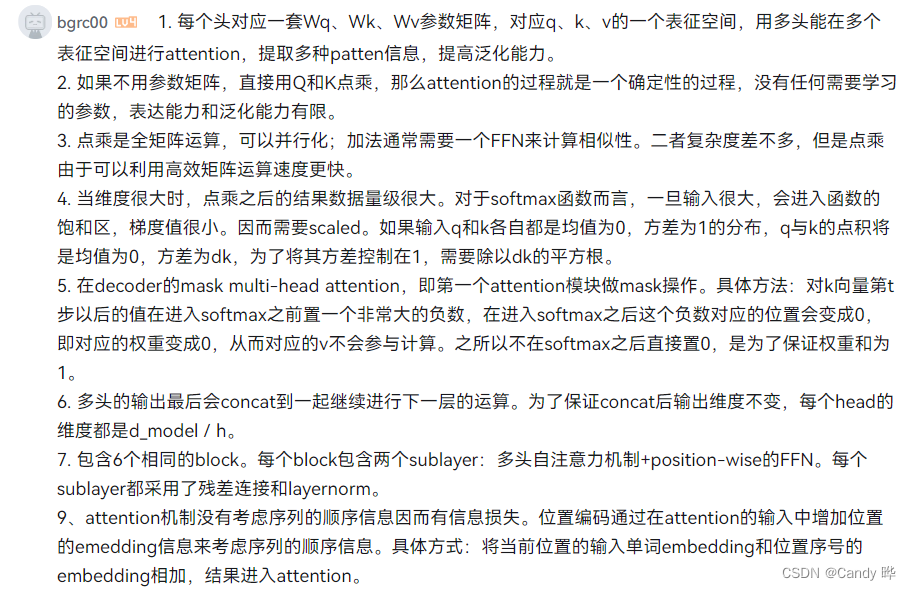

Batch Norm是在batch上,对每个单一通道输入进行归一化;

Layer Norm在通道方向上,对每个深度上的输入进行归一化.

8.MLP:中文叫法是多层感知机,其实质就是神经网络。其提出主要是为了解决单层感知机无法解决的非线性问题。详细博客介绍

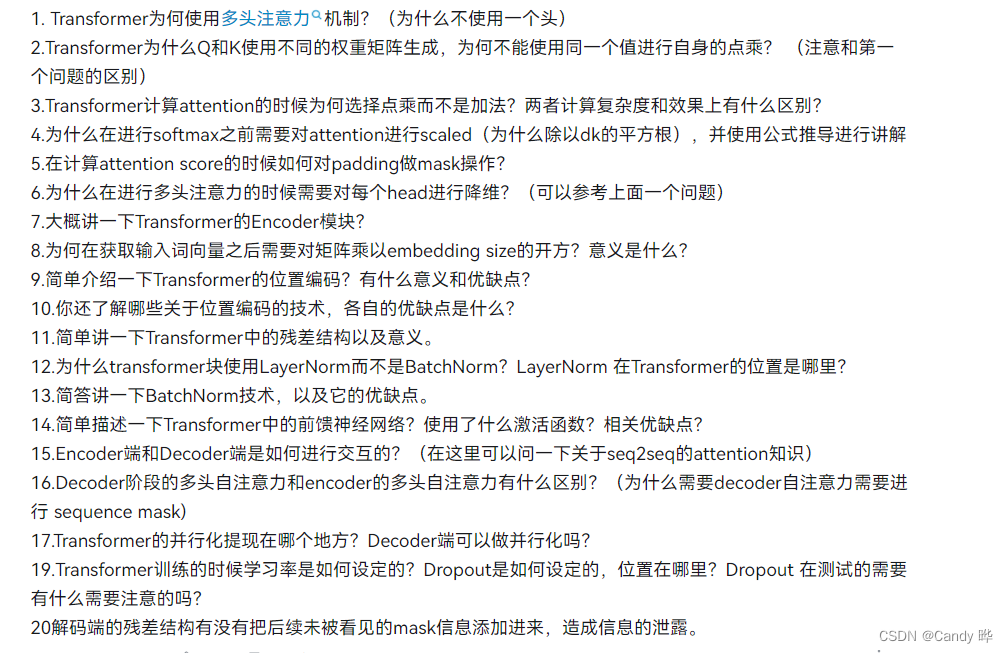

transformer