(作者:陈玓玏 data-master)

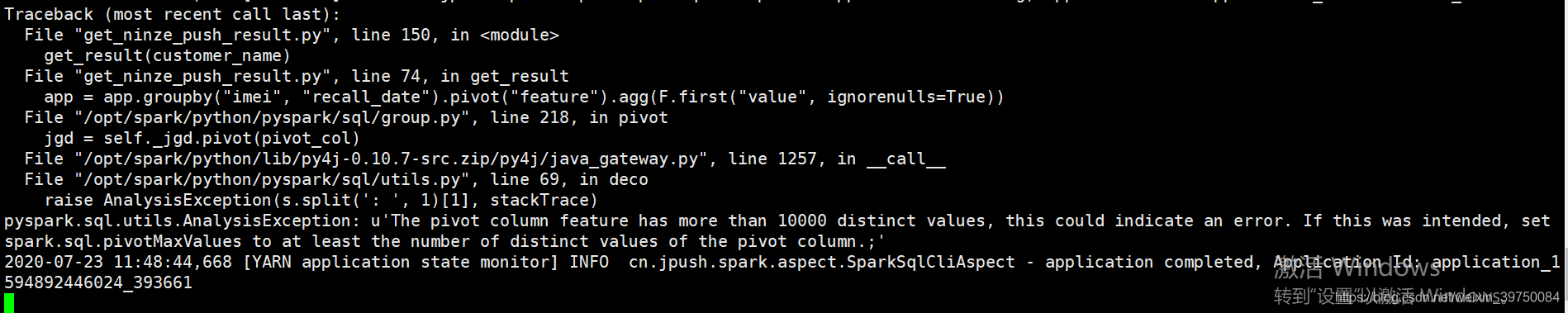

用pyspark做窄表转宽表的时候,出现报错:

pyspark.sql.utils.AnalysisException:

u'The pivot column feature has more than 10000 distinct values,

this could indicate an error.

If this was intended,

set spark.sql.pivotMaxValues to at least

the number of distinct values of the pivot column.;'

好可怕,看字面意思,我的窄表里出现了超过1W个item,要知道这个是造的因子,也就是说有超过1W个因子?

虽然很可怕,但既然碰到问题,就要解决问题,解决问题的方法,报错里已经给出了,就是设置一下spark.sql.pivotMaxValues这个参数。

然后我就直接在hive里查了一下,我总共有多少个item,查出是2W6,于是把参数spark.sql.pivotMaxValues设置成30000,报错消失。