最近因为项目需要在接触chatGLM相关的内容,本地化部署运行是其中之一,在这个学习实践过程中也遇上了很多报错,这里主要是对各种报错的记录汇总,也欢迎大家一起贡献问题与解决方案,希望的就是帮到同样有需要的人。

问题一

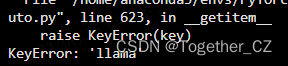

LLaMA-13b模型权重和Vicuna delta权重进行合并整合的时候报错“configuration_auto.py in getitem raise KeyError(key) KeyError:llama”如下所示:

解决办法升级安装transformer库即可,如下所示:

pip install transformers==4.28.1

问题二

chatGLM模型使用官方提供的p-tuing微调方法训练完成模型后,加载启动模型权重文件报错AttributeError: ‘ChatGLMModel‘ object has no attribute ‘prefix_encoder‘

这个问题在网上找了很多相关的文章最后都是不匹配的解决方案,最终的解决方法是修改configuration_chatglm.py模块中pre_seq_len参数即可。