为了保证 DRL 算法能够顺利收敛,policy 性能达标并具有实用价值,结果有说服力且能复现,需要算法工作者在训练前、训练中和训练后提供全方位一条龙服务。我记得 GANs 刚火起来的时候,因为训练难度高,有人在 GitHub 上专门开了 repository,总结来自学术界和工业界的最新训练经验,各种经过或未经验证的 tricks 被堆砌在一起,吸引了全世界 AI 爱好者的热烈讨论,可谓盛况空前。在玄学方面,DRL 算法训练有得一拼。但毕竟在科研领域没有人真的喜欢玄学,只有久经考验的一般化规律才能凝结成知识被更多的人接受和推广。本篇接下来的内容融合了许多个人经验和各种参考资料,算是在 DRL 训练 “去玄学” 化上做出的一点微不足道的努力。

1. 训练开始前

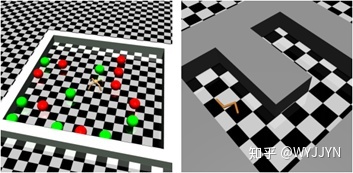

1.1 环境可视化

如果条件允许,开始训练前最好先可视化一个随机环境,观察是否会出现你希望的状态(即上一篇里的主线事件)。如果靠随机选择 action 都能以一定概率探索到目标状态,那说明该任务难度比较低,心里就可以更有底;如果从来不会出现目标状态,说明该任务难度较高,需要在状态空间和 reward 函数设计时特别下功夫,从而更好地引导 agent 向目标状态前进。

1.2 数据预处理

你还可以实时打印出 state 和 reward,看看它们是否在合理范围内取值,是否存在幅值过大的情况