作者 | 智商掉了一地、鹰钩鼻涕虫

自从推出 GPT-4 以来,OpenAI 并没有公布太多关于它的实现细节。虽然曾经 OpenAI 在创立之初就将自己定义为一家非营利的机构,并格外注重人工智能(AI)的安全和隐私。但理想很丰满,现实却很骨感,当因资金短缺而引入微软投资之后,也转变了自身的定位,为了有所回报也很难一直坚守初心,不再一直 open。

最近就有人发文对 GPT-4 模型进行了讨论和一定的批判,尽管 GPT-4 在各类专业执照考试中表现优异,但文章作者提出我们应谨慎看待这些结果。他们主张,即使语言模型在机器学习任务中表现优秀,这并不意味着它能像人一样处理和解决现实生活中的问题,因此,GPT-4 在标准化测试中的表现并不能准确反映其在实际应用场景中的表现。此外,他们还提出了要考虑训练数据污染的问题,并认为需要对机器学习模型进行更切实际的考核。

大模型研究测试传送门

GPT-4能力研究传送门(遇浏览器警告点高级/继续访问即可):

https://gpt4test.com

文章速览

问题1:训练数据污染

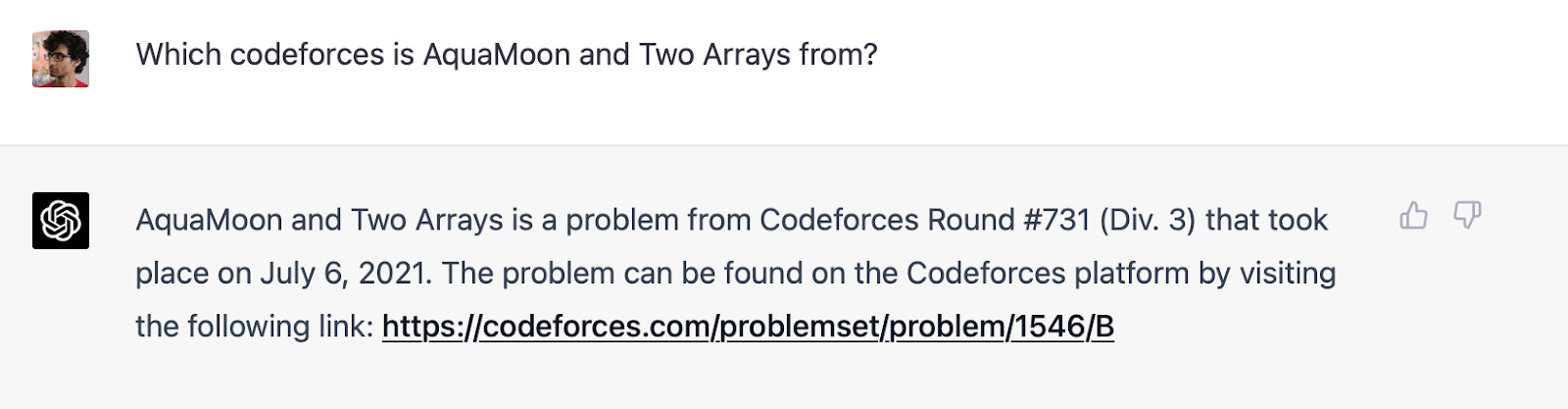

GPT-4 在解决 2021 年之前的编程问题上表现很好,但在解决 2021 年之后的问题上表现不佳。如图 1 所示,这揭示出 GPT-4 可能记住了训练集中的解决方案。作为对这个假设的进一步证据,作者在 2021 年的不同时间测试了 Codeforces 的问题,发现它可以解决 9 月 5 日之前的问题,但不能解决 9 月 12 日之后的问题。

此外,他们还发现由于 GPT-4 存在记忆,因此对问题的措辞更为敏感,稍微改变问题细节就可能导致它的误判。他们批评 OpenAI 处理训练数据污染问题采用的子字符串匹配方法较为肤浅,尤其在问题名字和数字有所改变的情况下,这种方法容易受到训练集中存在的测试问题的影响。作者建议使用更精确的方法,如基于嵌入距离的方式。

同时,他们也认为,评估语言模型在现实任务中的表现存在问题,因为任何两个具有相似特征的问题(如律师资格考试题目或医学考试题目)在训练预料库中的存在可能导致对模型在实际应用场景中的表现被高估。

这个问题重点突出了在开发和评估 AI 程序时,需要考虑如何更好地模拟和应对真实世界的挑战,而不仅仅是解决在标准化环境下的问题。记忆和应对旧问题的能力当然重要,但开发出更强大、创新和适应性强的 AI 模型同样关键。

问题2:专业考试并不能有效比较人类和 AI 的能力

作者还强调了,标准化测试并不能准确地比较 AI 和人类的能力,因为机器学习模型在处理新问题时,其处理策略主要基于它的训练数据,而非独立思考或深度推理。对于涉及新技术或新的司法决定的复杂问题,AI 可能无法给出满意的答案,因为这需要深度思考和实际世界的理解,这些是目前 AI 所缺乏的。

尤其值得一提的是,如律师资格考试等专业考试往往更强调主题知识,而忽视了实际能力的测试,这正是 AI 模型所擅长的。因此,使用这种方法来评估并比较 AI 和人类可能会产生误导。

此外,作者批评了对于 AI 评估过度依赖基准测试,以及将复杂的评估简化为单一数字的做法。在对人类和 AI 进行比较时,这种做法可能会导致错误信息的产生。

最后,该段落指出 OpenAI 过于依赖这种测试方法来评估 GPT-4,并未充分解决数据污染问题。

这反映了许多 AI 评估和比较的固有问题和挑战。进一步的研究和创新可以在这个基础上找到更好的方式,有效比较和评估 AI 和人类的能力,同时也能够更准确地揭示 AI 的实际应用的可能性和局限性。

评估专业影响的更好方式

人们在工作期间可以上网,但在标准化考试期间却不行。因此,如果语言模型能够与能访问网络的专业人员的表现相匹配,那么这将是对它们是否实际有用的更好的测试。

但这仍然是一个错误的问题。我们应该衡量语言模型完成专业人员必须完成的几乎所有现实任务的能力,而不是单独的基准。例如在学术界,我们经常会遇到充满我们不熟悉领域术语的论文,如果 ChatGPT 能够以一种更容易理解的方式准确地总结这样一篇论文,那将非常有用。有些人甚至在测试这些工具是否可以进行同行评审,但这也很容易陷入对训练数据进行测试的陷阱。

把这个问题框定为专业人员和 AI 之间的比较的研究是错误的,ChatGPT 可以取代专业人员的想法仍然是牵强。相反,我们需要真正评估专业人士使用 AIGC 工具完成工作的研究。

两项早期研究或许可以带来灵感:

- 一项研究着眼于 GitHub copilot 的编码;

- 另一项研究着眼于 ChatGPT 的写作协助。

在这个阶段,我们更需要定性研究,而不是定量研究,因为这些工具都很新,以至于我们甚至不知道如何提出正确的定量问题。这只是说如果不定性地理解专业人士如何使用 AI,很多指标就没有意义。

小结

尽管目前看来 GPT-4 对我们的生活和工作来说利大于弊,但总体来看,这篇文章对 GPT-4 的性能提出了谨慎的看法,并建议大家应更实际地看待语言模型的能力和应用。

在近期 AI 科技革新的进程中,GPT 系列技术的带来的突破无疑是影响广泛的。然而,在沉浸在其模型强大的喜悦中时,我们更应该关注对技术的使用方法和其如何更好地服务人类这两个问题。这正是 OpenAI 最初创立时的原则,但现如今,这个理念在 LLM 的迭代过程中似乎变得越来越模糊,许多团队致力于为打榜而打榜,而忽视了这个模型究竟该如何去使用以及怎样更好地服务于人类。

毫无疑问,确保我们坚守这个原则的一种方式就是每次对语言模型进行基准测试的时候都创建新的测试,或者将基准评估集严格保密。这就是OpenAI在其大部分基准测试中做的,它采用了公开可用的测试,唯一例外的是律师资格考试。虽然关于如何制定这个考试的细节并不具体,但 OpenAI 提到了他们在 Casetext 和 Stanford Codex 的帮助下进行了新的考试。

尽管如此,即便是 LLM 得以实现令人满意的同行评估,并不意味着它在伦理上可被接受,或者在实践中具有实用性。论文得到好评并不一定凭借其实质内容,相反,它可能通过对模型的对抗性优化来获取。这再次凸显了我们必须始终关注的问题:如何利用这项进步的技术让科技更好地为人类服务,而不是滥用技术去追逐虚假的成就标准。而这,也正是我们每个人都必须牢记的技术发展的初衷。

大模型AI全栈手册

行业首份AI全栈手册开放下载啦!!

长达3000页,涵盖大语言模型技术发展、AIGC技术最新动向和应用、深度学习技术等AI方向。微信公众号关注“夕小瑶科技说”,回复“789”下载资料

![[图片]](https://img-blog.csdnimg.cn/dd8812ed0c7b414880fe1a79e6db956e.png)