简介

斯坦福大学自然语言计算组发布SQuAD数据集,诸多团队参与其中,而微软亚研的R-NET是首个在某些指标中接近人类的深度学习模型。由于刚刚 开源CNTK版的R-NET,趁着余热解读其中的原理。阅读准备

先介绍一下SQuAD数据集的特点,SQuAD数据集包含10w个样例,每个样例大致由一个三元组构成(文章Passage, 相应问题Query, 对应答案Answer), 以下皆用(P,Q,A)表示。由于R-NET模型中多次引用 Matching-LSTM 模型和 Pointer-Net模型中的思想,所以建议准备精读的朋友先看一下 Blog(Matching-LSTM)和李宏毅老师的Ptr-Net。

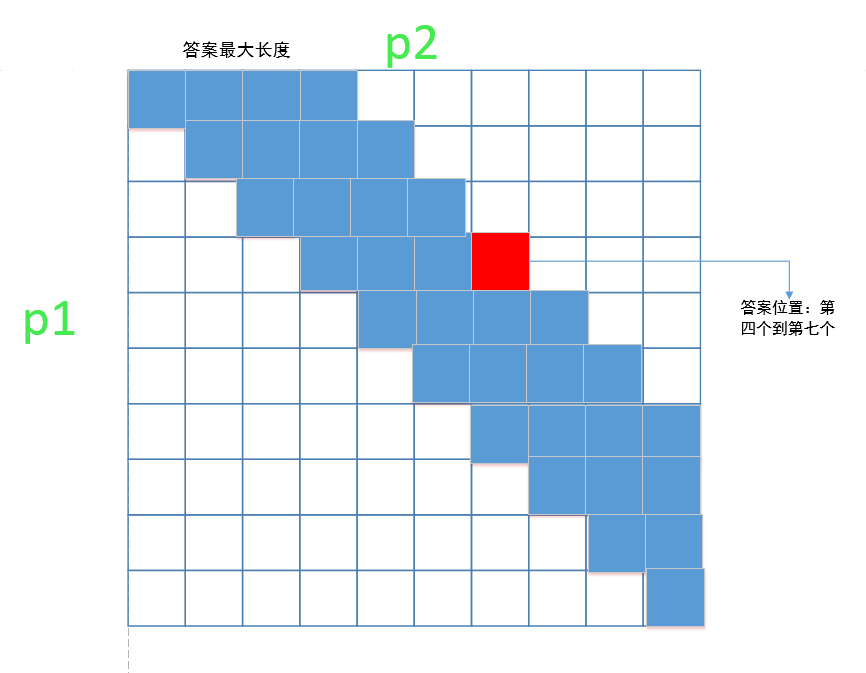

结构图

原理介绍

R-NET模型一共分为四个步骤,分别为QUESTION AND PASSAGE ENCODER, GATED ATTENTION-BASED RECURRENT NETWORKS, SELF-MATCHING ATTENTION, OUTPUT LAYER, 基本结构可观察上面所示的结构图。1. QUESTION AND PASSAGE ENCODER

第一层为表示学习过程, R-NET中的方式Input = Glove + char embedding。第一种是把文章P,和问题Q中的单词替换为Glove词向量中的数据,

,第二种是char embedding

,

。最终把文章P和问题Q分别通过BiRNN。

uQt=BiRNNQ(uQt−1,[eQt,cQt])uPt=BiRNNP(uPt−1,[ePt,cPt])

2. GATED ATTENTION-BASED RECURRENT NETWORKS

从上一层网络中可以得到

vPt=RNN(vPt−1,ct)

其中

基本具体形式如下:

stj=vTtanh(WQuuQj+WPuuQt+WPvvPt−1)ati=exp(sti)/∑j=1mexp(stj)ct=∑i=1matiuQi

R-NET又基于matching-lstm和门控制方式对以上方法提出两点改进,第一点是把

vPt=RNN(vPt−1,[ct,uPt])

第二点又在

gt=sigmoid(Wg[ct,uPt])[ct,uPt]∗=gt⊙[ct,uPt]

3. SELF-MATCHING ATTENTION

此过程充分借鉴了 Attention is all you need 中的自注意力思想,在模型效果提升中起了很大作用,而且这个方法也易于实现。

hPt=BiRNN(hPt−1,[ct,vPt])

其中

stj=vTtanh(WPvvPj+WP~vvPt)ati=exp(sti)/∑j=1nexp(stj)ct=∑i=1nativPi

4. OUTPUT LAYER

R-NET模型输出的是答案在文章中的起始位置,在这一过程中借鉴了pointer-network的思想,R-NET模型先计算得到开始位置在文章中的分布

sj=vTtanh(WQuuQj+WQvvQr)ai=exp(si)/∑j=1mexp(sj)rQ=∑i=1naiuQi

其中这个seq2seq的循环循环结构为:

hat=RNN(hat−1,ct)

$c_{t}$ 依然是对文章的attention-pooling得到的结果:

stj=vTtanh(WPhhPj+Wahhat−1)ati=exp(sti)/∑j=1nexp(stj)ct=∑i=1natihPi

通过以上RNN循环单元两次可以得到两个权重分布,我们可以通过下面这种方式从中得到答案的起始位置。

pt=argmax{at1,...,atn}

不过再具体实验中还有一个小trick对提升效果很有用,由于我们得到了两个分布