来自Mila和Google Brain的一组研究人员认为,简单的铅笔草图可以帮助AI模型更好地理解看不见的图像。

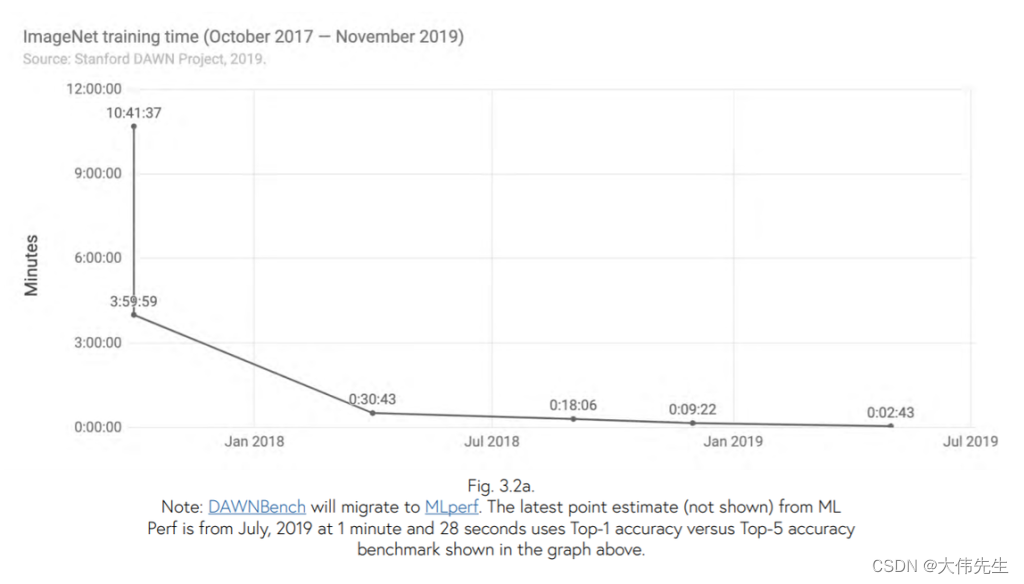

深度神经网络在实际的感知任务中表现出色,并且它们会变得越来越强大。正如斯坦福大学 2019 年人工智能指数所指出的那样:“在云基础设施上训练大型图像分类系统所需的时间已从 2017 年 10 月的大约 3 小时下降到 2019 年 7 月的大约 88 秒。

然而,智能机器能够泛化到模型训练中看不到的变化,这仍然远远不能达到人类的能力。 人类很快就学会了发现突出的品质,而不是看小事。例如,即使没有许多视觉细节,我们也可以识别和理解卡通人物。机器学习算法无法以这种方式泛化,除非它们经过明确的训练。

在一篇新论文中,Mila和Google Brain的研究人员引入了一个“SketchTransfer”数据集和任务,其中神经网络根据它们能够在没有明确监督的情况下学习的抽象质量进行评估。

SketchTransfer 训练数据集包括来自 CIFAR-10 数据集的标记真实图像和来自快速绘制的未标记草图图像!青蛙、鸟、猫、狗、汽车、飞机等类别中的数据集。

SOTA模型的任务是识别和分类草图中的对象,同时仅提供真实图像的标签。这项任务具有挑战性,例如,狗和猫之间唯一可用的明显差异可能是鼻子或耳朵的形状。但是,神经网络不会像人类那样对图像进行分类,而是可能不会立即找到这种明显而独特的特征。

研究人员观察到,在MNIST到SVHN传输中得分超过95%的SOTA技术只能在SketchTransfer任务中管理59%。虽然这比随机要好得多,但它没有达到直接在标记草图上训练的分类器的87%准确率。

当人类看世界时,我们忽略了大部分视觉信息,并将注意力集中在代表不变抽象的相关细节上。研究人员得出结论,用当代方法,教机器以这种基本和人性化的方式看待和理解世界是平易近人的,但“有很大的改进空间”。

SketchTransfer 为社区提供了一种新工具,用于检查深度网络及其概括抽象的能力。

论文《SketchTransfer: A Challenge New Task for Exploring Detail-Invariance and the Abstractions Learned by Deep Networks》可在arXiv上找到。