探索一系列用于网页抓取的强大 Python 库,包括用于 HTTP 请求、解析 HTML/XML 和自动浏览的库。

网络抓取已成为当今数据驱动世界中不可或缺的工具。Python 是最流行的抓取语言之一,拥有一个由强大的库和框架组成的庞大生态系统。在本文中,我们将探索用于网络抓取的最佳Python 库,每个库都提供独特的特性和功能来简化从网站提取数据的过程。

本文还将介绍最佳库和最佳实践,以确保高效和负责任的网络抓取。从尊重网站政策和处理率限制到解决常见挑战,我们将提供宝贵的见解,帮助您有效地驾驭网络抓取的世界。

Scrape-It.Cloud

让我们从 Scrape-It.Cloud 库开始,它提供了对用于抓取数据的API 的访问。该解决方案有几个优点。例如,我们通过中介来完成此操作,而不是直接从目标网站抓取数据。这保证了我们在抓取大量数据时不会被阻止,因此我们不需要代理。我们不必解决验证码问题,因为 API 会处理这个问题。此外,我们可以抓取静态页面和动态页面。

特征

借助 Scrape-It.Cloud 库,您可以通过简单的 API 调用轻松从任何站点提取有价值的数据。它解决了代理服务器、无头浏览器和验证码解决服务的问题。

通过指定正确的 URL,Scrape-It.Cloud 可以快速返回包含必要数据的 JSON。这使您可以专注于提取正确的数据,而不必担心数据被阻止。

此外,此 API 允许您从使用 React、AngularJS、Ajax、Vue.js 和其他流行库创建的动态页面中提取数据。

此外,如果您需要从 Google SERP 收集数据,您还可以将此 API 密钥用于serp api python库。

安装中

要安装该库,请运行以下命令:

pip install scrapeit-cloud

要使用该库,您还需要一个 API 密钥。您可以通过在网站上注册来获取它。此外,您还将获得一些免费积分来免费提出请求并探索图书馆的功能。

使用示例

对特定库的所有功能、特性和使用方法的详细描述值得单独撰写一篇文章。现在,我们将仅向您展示如何获取任何网页的 HTML 代码,无论您是否可以访问该网页、是否需要验证码解决方案以及页面内容是静态还是动态。

为此,只需指定您的 API 密钥和页面 URL。

from scrapeit_cloud import ScrapeitCloudClient

import json

client = ScrapeitCloudClient(api_key="YOUR-API-KEY")

response = client.scrape(

params={

"url": "https://example.com/"

}

)由于结果采用 JSON 格式,并且页面的内容存储在 属性 中["scrapingResult"]["content"],因此我们将使用它来提取所需的数据。

data = json.loads(response.text)

print(data["scrapingResult"]["content"])结果,检索到的页面的 HTML 代码将显示在屏幕上。

Requests 和 BeautifulSoup 组合

最简单和最流行的库之一是BeautifulSoup。但是,请记住,它是一个解析库,不具备自行发出请求的能力。因此,它通常与简单的请求库(如Requests、 http.client 或 cUrl )一起使用。

特征

这个库是为初学者设计的,非常容易使用。此外,它还拥有详细记录的说明和活跃的社区。

BeautifulSoup库(或 BS4)是专门为解析而设计的,这赋予了它广泛的功能。您可以使用 XPath 和 CSS 选择器来抓取网页。

由于其简单性和活跃的社区,在线提供了大量其使用示例。此外,如果您在使用过程中遇到困难,您可以获得帮助来解决您的问题。

安装中

如前所述,我们需要两个库来使用它。为了处理请求,我们将使用 Requests 库。好消息是它是预安装的,因此我们不需要单独安装它。但是,我们确实需要安装 BeautifulSoup 库才能使用它。为此,只需使用以下命令:

pip install beautifulsoup4安装完成后,您可以立即开始使用它。

使用示例

假设我们想要检索<h1>包含标头的标签的内容。为此,我们首先需要导入必要的库并发出请求以获取页面的内容:

import requests

from bs4 import BeautifulSoup

data = requests.get('https://example.com')为了处理页面,我们将使用 BS4 解析器:

soup = BeautifulSoup(data.text, "html.parser")现在,我们所要做的就是指定我们想要从页面中提取的确切数据:

text = soup.find_all('h1')最后,我们将获取到的数据显示在屏幕上:

print(text)正如我们所看到的,使用该库非常简单。然而,它确实有其局限性。例如,它无法抓取动态数据,因为它是一个与基本请求库而不是无头浏览器一起使用的解析库。

LXML

LXML是另一个流行的数据解析库,它不能单独用于抓取。由于它还需要一个库来发出请求,因此我们将使用我们已经知道的熟悉的 Requests 库。

特征

尽管它与以前的库相似,但它确实提供了一些附加功能。例如,它比 BS4 更擅长处理 XML 文档结构。虽然它还支持 HTML 文档,但如果您有更复杂的 XML 结构,该库将是更合适的选择。

安装中

如前所述,尽管需要请求库,但我们只需要安装 LXML 库,因为其他所需的组件已经预先安装。

要安装 LXML,请在命令提示符中输入以下命令:、

pip install lxml现在让我们继续看一下使用该库的示例。

使用示例

首先,就像上次一样,我们需要使用一个库来获取网页的 HTML 代码。这部分代码与前面的示例相同。

使用示例

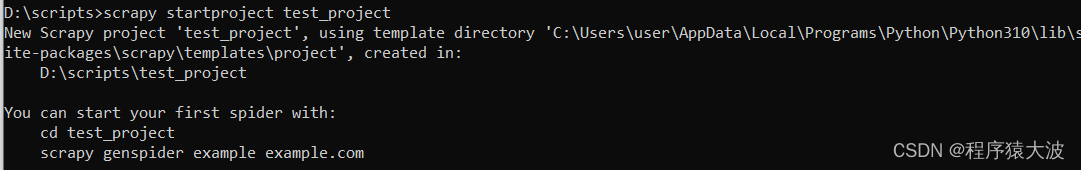

与库示例不同,创建项目就像蜘蛛文件一样,是通过特殊命令完成的。必须在命令行中输入它。

首先,让我们创建一个新项目,在其中构建我们的抓取工具。使用以下命令:

scrapy startproject test_project

在我们继续创建蜘蛛之前,让我们看一下项目树的结构。

这里提到的文件是在创建新项目时自动生成的。这些文件中指定的任何设置都将应用于项目中的所有蜘蛛。您可以在“items.py”文件中定义公共类,在“pipelines.py”文件中指定项目启动时要执行的操作,并在“settings.py”文件中配置常规项目设置。

最佳实践和注意事项

为了使网络抓取更加高效,需要遵循一些规则。遵守这些规则有助于使您的抓取工具更加有效和道德,并减少您从中收集信息的服务的负载。

避免过多的请求

在网络抓取过程中,避免过多的请求对于防止被阻止并减少目标网站的负载非常重要。这就是为什么建议在最不繁忙的时间(例如晚上)从网站收集数据。这有助于降低资源过载并导致其故障的风险。

处理动态内容

在收集动态数据的过程中,有两种方法。您可以使用支持无头浏览器的库自行进行抓取。或者,您可以使用网络抓取 API,该 API 将为您处理收集动态数据的任务。

如果您有良好的编程技能和一个小项目,那么使用库编写自己的抓取工具可能会更好。但是,如果您是初学者或需要从多个页面收集数据,则网络抓取 API 会更好。在这种情况下,除了收集动态数据外,API 还将负责代理和解决验证码。

结论和要点

本文讨论了用于网页抓取的库和以下规则。总而言之,我们创建了一个表格并比较了我们涵盖的所有库。

下面的比较表重点介绍了用于网页抓取的 Python 库的一些关键功能:

| 图书馆 |

解析能力 |

高级功能 |

JS渲染 |

使用方便 |

| Scrape-It.Cloud |

HTML、XML、JavaScript |

自动抓取和分页 |

是的 |

简单的 |

| 请求和 BeautifulSoup 组合 |

HTML、XML |

简单集成 |

不 |

简单的 |

| 请求和 LXML 组合 |

HTML、XML |

XPath 和 CSS 选择器支持 |

不 |

缓和 |

| 刮痧 |

HTML、XML |

多个蜘蛛 |

不 |

缓和 |

| 硒 |

HTML、XML、JavaScript |

动态内容处理 |

是(使用网络驱动程序) |

缓和 |

| 皮皮特师 |

HTML、JavaScript |

使用无头 Chrome 或 Chromium 实现浏览器自动化 |

是的 |

缓和 |

总的来说,Python 是一种非常有用的数据收集编程语言。凭借其广泛的工具和用户友好的性质,它通常用于数据挖掘和分析。Python 可以轻松完成与从网站提取信息和处理数据相关的任务。