文章来源:Xu N, Mao W. Multisentinet: A deep semantic network for multimodal sentiment analysis[C]//Proceedings of the 2017 ACM on Conference on Information and Knowledge Management. 2017: 2399-2402.(CCF B)

一、模型结构

以现在的角度看2017年的这篇文章,可以发现思路非常简单。思路如下所示:

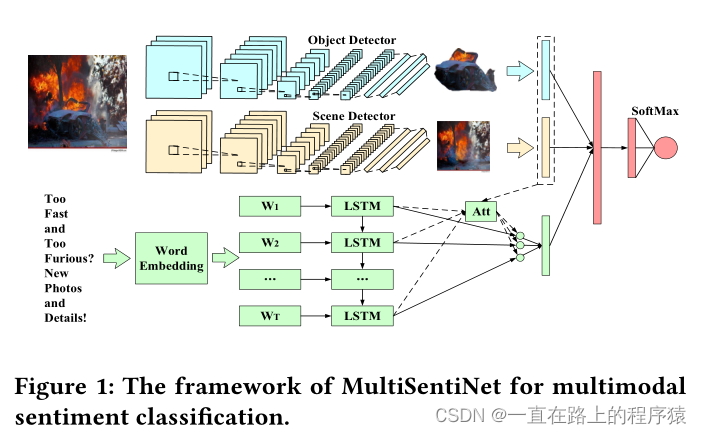

图像数据中,图像的目标和场景信息和最终的情感分类有着密切的联系,分别使用在ImageNet和在Place-365数据集上预训练的VGG提取图像中的目标特征信息和场景特征信息。

文本数据中,在经过Glove词向量表示之后,使用LSTM网络结构将文本的语境信息融入到词向量中,最终将所有词向量的求和平均作为tweet的最终表示。所得到的tweet表示向量意味着所有词向量的贡献是相同的,但这显然是不对的。本文使用目标特征向量和场景特征向量来和词向量进行跨模态的注意力机制,对文本中和情感有关的词向量赋予高的权重,以此方式得到最终tweet的表示向量。

决策阶段:三种特征送入到多层感知机,使用softmax函数进行预测。使用交叉熵函数作为目标损失函数。

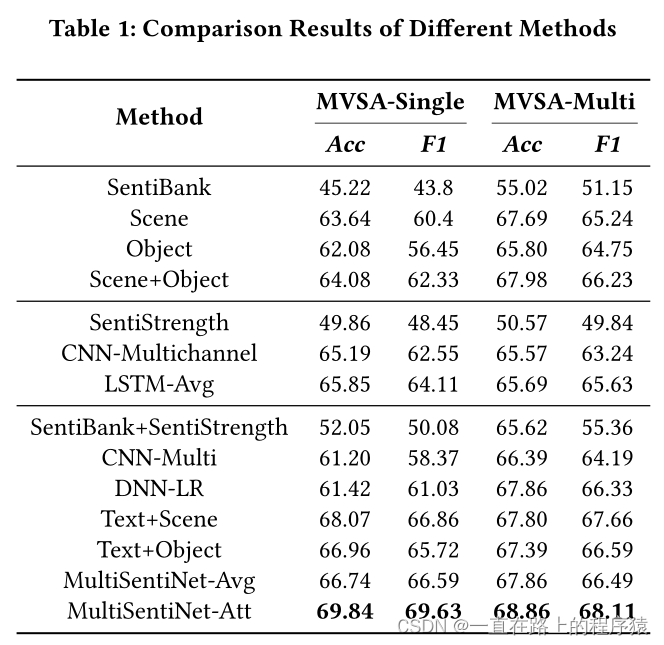

实验结果如下所示:

综上所述,该篇文章的思路有些简单,与之前写的另一篇文章相比,更像是那篇文章的前身。

扫描二维码关注公众号,回复:

16383274 查看本文章