熵

当一件事情(宏观态)有多种可能情况(微观态)时,这件事情(宏观态)对某人(观察者)而言具体是哪种情况(微观态)的不确定性叫做熵(entropy)

信息

能够消除该人对这件事情(宏观态)不确定性的事物叫做信息。

熵和信息数量相等,意义相反,获取信息意味着消除不确定性(熵)

宏观态、微观态

宏观态(macrostate)是不考虑内部细节的状态,而微观态(microstate)是考虑具体细节的状态。

比如,生物是宏观态,动物和植物都是生物这个宏观态的一种微观态

消除不确定性的信息有三种类型

①调整概率

②排除干扰

③确定情况

那些不能够消除某人对某件事情不确定性的事物被称为数据或噪音;

噪音是干扰某人获得信息的事物;

而数据是噪音与信息的混合,需要用知识将其分离。

信息熵的性质

①媒介无光

②相对个体

③客观物理

④相对事件

同一个观察者,对同一件事情接受到的信息与用于传递信息的信号形式无关。

概率和熵的区别:

概率是某件事情(宏观态)某个可能情况(微观态)的确定性;

熵是某人对某件事情(宏观态)到底是哪个情况(微观态)的不确定性。

信息描述的是一个观察者确定一个宏观态是哪个微观态时需要的物理量

所以信息是相对的。

接收到的信息是相对于观察者已经对该件事情的实际了解程度而言的。

小红会这道题,不管告不告诉小红正确答案是C,小红对这道题的熵都为0 bit。

因为观察者已经拥有这件事情的所有信息,不确定性从最初就不存在。

但信息是客观的物理量,不随观察者的主观意识改变。

比如,小虎认为C是错的,熵不会减少。

因为这个“主观认为C是错的”并没有实际帮助小虎消除事情的不确定性。

“明天的太阳东边升起”这句话,对知道的人而言,提供了0 bit 信息;

对知道或东或西升起的从而言,提供了1bit 信息;

对觉得东南西北都有可能的人而言,提供了2 bits信息。

同时信息(熵)还是相对于某件事情而言的

比如,小明对“正确答案是ABCD哪个选项”的熵是2bits;

但小明对“正确答案属于AB,还是属于DC”的熵是1 bit;

又比如,小红告诉小明“正确答案是C”,为小明确定正确答案提供了2bits信息;

而若想告诉别人“小红对小明说了什么”,这件事情的熵不再是2 bits;

观察者也不再是小明,而是除小明和小红之外的观察者。

信息的计量

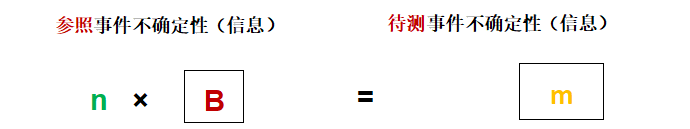

待测事件的不确定性相当于“多少个”参照事件的不确定性。

以抛掷1枚硬币的结果的信息为1bit信息,抛掷3枚硬币的信息却无法用3×1bit计算,因为抛掷3枚硬币有 2 3 2^3 23(8)种可能性。

上述待测事件的所有可能情况必须是等概率才行(因为参照事件本身的两种情况就是等概率)。

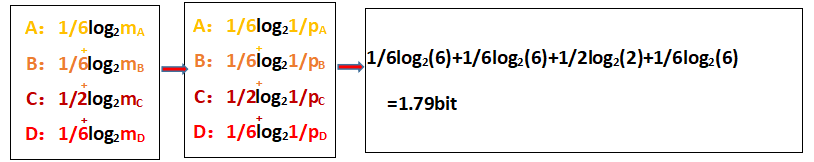

如果待测事件发生的情况不等概率,则分别计算待测事件每种情况的信息后,乘以它们各自发生的概率再相加即可

接下来是确定m的信息量,即m相当于抛掷多少枚硬币产生的不确定性

我们知道,1%会发生的情况,相当于从100个等概率情况中确定实际情况

概率p的倒数等于概率情况的个数,m=1/p

则上面的式子可以改写为:

计算:

均匀分布: l o g 2 m log_2m log2m

一般分布: ∑ P i l o g 2 P i − 1 \sum P_ilog_2P_i^{-1} ∑Pilog2Pi−1

强烈推荐B站的这个UP主点击链接

该笔记根据其视频内容整理