模型

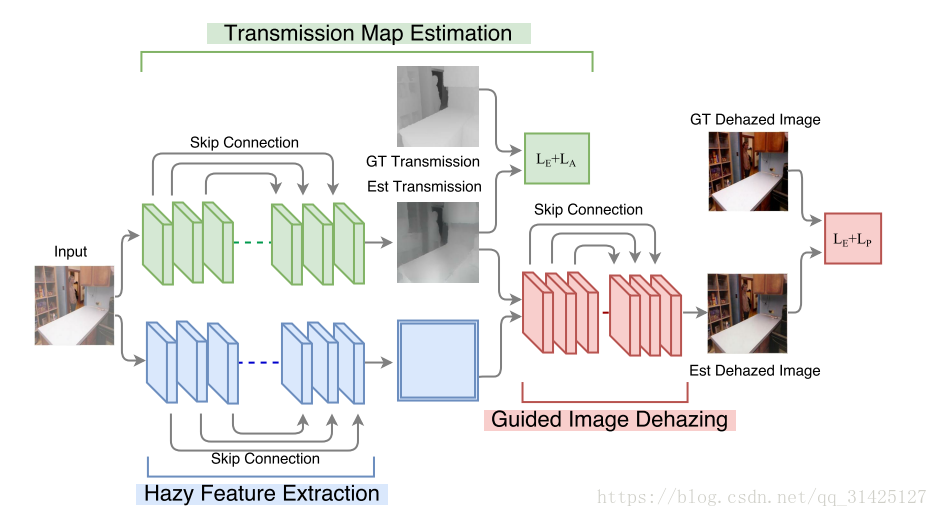

整个网络包括三个子网络,如图。

transmission map estimation

传播图估计网络是一个CGAN网络,包含两个子网络:生成网络G和对抗网络D

生成网络:有类似U-net结构的跳跃级联结构

C(15)-CBP(30)-CBP(60)-CBP(120)-CBP(120)-CBP(120)-CBP(120)-CBP(120)-TCBP(120)-TCBP(120)-TCBP(120)-TCBP(120)-TCBP(60)-TCBP(30)-TCBP(15)-TC(1)-tanh

对抗网络:

CB(48)-CBP(96)-CBP(192)-CBP(384)-CBP(384)-C(1)-sigmoid

损失函数:均方误差损失+对抗损失haze feature extraction

一个可行的方案是:让网络直接学习传播图和去雾图之间的非线性映射关系,但是这里有一个问题,就是在论文Image-to-image with conditional adversarial networks中所说的,当网络在学习类标签图像和RGB彩色图像之间的映射时,很难保留图像原有的彩色信息,因此,即使网络学习到的映射关系能够产生视觉上理想的结果,也不可能精确地预测出去雾后图像。

为了确保去雾后的图像和原图像保持色彩恒常,作者这里借鉴了论文Deep Joint Image Filtering中的做法,用一个guidance image联合估计出的传播图一起作为第三个去雾网络的输入。这里的guidance image就是子网络haze feature extraction提取出的高维特征。

网络结构和guided image dehazing一样。guided image dehazing

类似于一个融合网络,多输入单输出,输入的是高维特征和估计出的传播图的concatenate,输出的是最终的去雾图,网络结构如下:

CP(20)-CBP(40)-CBP(80)-C(1)-Concat(2)-CP(80)-CBP(40)-CBP(20)-C(3)-tanh

损失函数:均方误差损失+感知损失

感知损失能够极大地增强最终结果的视觉效果。

训练

数据集 NYU Depth dataset

基于以下条件:(1)全局大气光服从[0.5,1.2]均匀分布;(2)大气散射系数服从[0.4,1.6]均匀分布;(3)针对每个无雾清晰图像以及对应的深度图,我们随机选择4个全局大气光和大气散射系数,人工合成有雾图像以及传播图

训练集:600张 x 4=2400

patch size:256 x 256模型参数设置

学习率:0.002

损失函数:

优化函数:Adam

batch size:10

框架:Torch对比试验

Transmission map estimation without adversarial loss:

Image dehazing without perceptual loss:

Image dehazing without Euclidean loss:

Image dehazing without transmission map:

测试

合成图像测试

测试集:75张 x 4=300

比较内容:

1、定性比较:从人工合成测试集中选择2幅出来和其他算法对比传播图以及去雾后图像

2、定量比较:SSIM、PSNR真实图像测试

比较内容:

1、之前论文里面出现过的真实有雾图像对比

2、具有挑战性的真实有雾图像对比