1.Schema是什么

DataFrame中提供了详细的数据结构信息,从而使得SparkSQL可以清楚地知道该数据集中包含哪些列,每列的名称和类型各是什么,

DataFrame中的数据结构信息,即为schema。

2.输出schema

还是用官网中的people.json的文件,输出schema,看看schema到底长什么样子。people.json文件的show()在上一篇文章中已经写到,

为了大家方便,我再把people.json长啥样贴出来,如图:

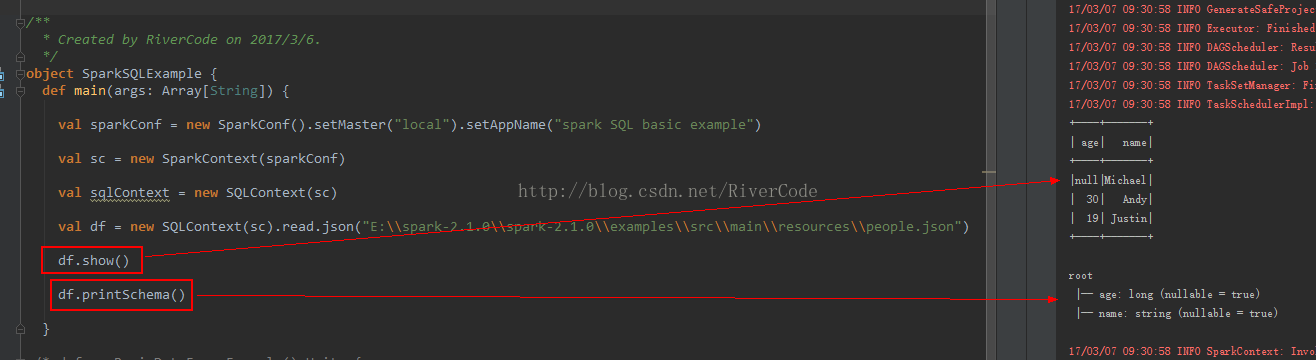

输出schema就一行代码:

df.printSchema()3.完整代码及结果

完整代码如下:

object SparkSQLExample {

def main(args: Array[String]) {

val sparkConf = new SparkConf().setMaster("local").setAppName("spark SQL basic example")

val sc = new SparkContext(sparkConf)

val sqlContext = new SQLContext(sc)

val df = new SQLContext(sc).read.json("E:\\spark-2.1.0\\spark-2.1.0\\examples\\src\\main\\resources\\people.json")

df.show()

df.printSchema()

}

}看截屏不清楚,为了让大家看的清楚,只截结果:

扫描二维码关注公众号,回复:

2732517 查看本文章