版权声明:本博客都是作者10多年工作总结 https://blog.csdn.net/Peter_Changyb/article/details/82052663

环境: Eclipse Mar 3+Hadoop2.7.3

Base line

- Host file modify C:\Windows\System32\drivers\etc hosts,配置环境变量HADOOP_HOME:C:\hadoop

- Linux tar zip解压hadoop2.7.3 到 C:\hadoop

3 copy hadoop_dll_winutil_2.7.1 下的 hadoop.dll 到C:\Windows\System32

copy hadoop_dll_winutil_2.7.1 下的 winutils.exe 到hadoop\bin目录下

copy hadoop-eclipse-plugin-2.7.2.jar D:\ eclipse\plugins

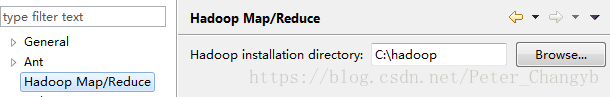

启动eclipse会发现Hadoop Map/Reduce 选择hadoop的解压目录即可

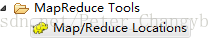

选择window--->show view 选择

进入视图

注意这里host 是自己的伪分布式的主机地址

第二个port9000是hadoop的端口号

第一个port需要修改配置文件,

Mapred-sizte.xml 加入

<property>

<name>mapred.job.tracker</name>

<value>192.168.16.100:9001</value>

</property>

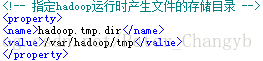

4.4修改

Hadoop.tmsp.dir 为/var/hadoop/temp

修改的目的是为了与Core-sizte.xml的配置文件对应起来