算法介绍

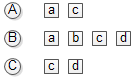

在推荐系统中,用户行为数据可以表示成图的形式,具体来说是二部图。用户的行为数据集由一个个(u,i)二元组组成,表示为用户u对物品i产生过行为。本文中我们认为用户对他产生过行为的物品的兴趣度是一样的,也就是我们只考虑“感兴趣”OR“不感兴趣”。假设有下图所示的行为数据集。

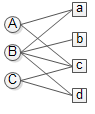

其中users集U={A, B, C},items集I = {a,b,c,d}。则用户物品的二部图如下所示:

我们用G(V, E)来表示这个图,则顶点集V=U∪I,图中的边则是由数据集中的二元组确定。二元组(u, i)表示u对i有过行为,则在图中表现为有边相连,即e(u,i)。【注意】,本文中我们不考虑各边的权重(即u对i的兴趣度),权重都默认为1。感兴趣即有边相连,不感兴趣则没有边相连。

那有了二部图之后我们要对u进行推荐物品,就转化为计算用户顶点u和与所有物品顶点之间的相关性,然后取与用户没有直接边相连的物品,按照相关性的高低生成推荐列表。说白了,这是一个图上的排名问题,我们最容易想到的就是Google的pageRank算法。

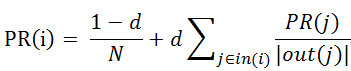

PageRank是Larry Page 和 Sergey Brin设计的用来衡量特定网页相对于搜索引擎中其他网页的重要性的算法,其计算结果作为google搜索结果中网页排名的重要指标。网页之间通过超链接相互连接,互联网上不计其数的网页就构成了一张超大的图。PageRank假设用户从所有网页中随机选择一个网页进行浏览,然后通过超链接在网页直接不断跳转。到达每个网页后,用户有两种选择:到此结束或者继续选择一个链接浏览。算法令用户继续浏览的概率为d,用户以相等的概率在当前页面的所有超链接中随机选择一个继续浏览。这是一个随机游走的过程。当经过很多次这样的游走之后,每个网页被访问用户访问到的概率就会收敛到一个稳定值。这个概率就是网页的重要性指标,被用于网页排名。算法迭代关系式如下所示:

上式中PR(i)是网页i的访问概率(也就是重要度),d是用户继续访问网页的概率,N是网页总数。in(i)表示指向网页i的网页集合,out(j)表示网页j指向的网页集合。

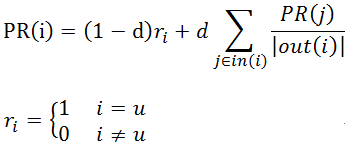

用user节点和item节点替换上面的网页节点就可以计算出每个user,每个item在全局的重要性,给出全局的排名,显然这并不是我们想要的,我们需要计算的是物品节点相对于某一个用户节点u的相关性。怎么做呢?Standford的Haveliwala于2002年在他《Topic-sensitive pagerank》一文中提出了PersonalRank算法,该算法能够为用户个性化的对所有物品进行排序。它的迭代公式如下:

我们发现PersonalRank跟PageRank的区别只是用

与PageRank随机选择一个点开始游走(也就是说从每个点开始的概率都是相同的)不同,如果我们要计算所有节点相对于用户u的相关度,则PersonalRank从用户u对应的节点开始游走,每到一个节点都以1-d的概率停止游走并从u重新开始,或者以d的概率继续游走,从当前节点指向的节点中按照均匀分布随机选择一个节点往下游走。这样经过很多轮游走之后,每个顶点被访问到的概率也会收敛趋于稳定,这个时候我们就可以用概率来进行排名了。

在执行算法之前,我们需要初始化每个节点的初始概率值。如果我们对用户u进行推荐,则令u对应的节点的初始访问概率为1,其他节点的初始访问概率为0,然后再使用迭代公式计算。而对于pageRank来说,由于每个节点的初始访问概率相同,所以所有节点的初始访问概率都是1/N (N是节点总数)。

图中顶点的相关度主要取决与以下因素:

1)两个顶点之间路径数

2)两个顶点之间路径长度

3)两个顶点之间路径经过的顶点

而相关性高的顶点一般有如下特性:

1)两个顶点有很多路径相连

2)连接两个顶点之间的路径长度比较短

3)连接两个顶点之间的路径不会经过出度较大的顶点

代码示例

#coding=utf-8

def PersonalRank(G,alpha,root,max_depth):

rank=dict()

rank={x:0 for x in G.keys()}

rank[root]=1

for k in range(max_depth):

tmp={x:0 for x in G.keys()}

#取出节点i和他的出边尾节点集合ri

for i,ri in G.items():

#取节点i的出边的尾节点j以及边E(i,j)的权重wij,边的权重都为1,归一化后就是1/len(ri)

for j,wij in ri.items():

tmp[j]+=alpha*rank[i]/(1.0*len(ri))

tmp[root]+=(1-alpha)

rank=tmp

lst=sorted(rank.items(),key=lambda x:x[1],reverse=True)

for ele in lst:

print ("%s:%.3f, \t" %(ele[0],ele[1]))

return rank

if __name__=='__main__':

G = {'A': {'a': 1, 'c': 1},

'B': {'a': 1, 'b': 1, 'c': 1, 'd': 1},

'C': {'c': 1, 'd': 1},

'a': {'A': 1, 'B': 1},

'b': {'B': 1},

'c': {'A': 1, 'B': 1, 'C': 1},

'd': {'B': 1, 'C': 1}}

PersonalRank(G,0.85,'A',100)

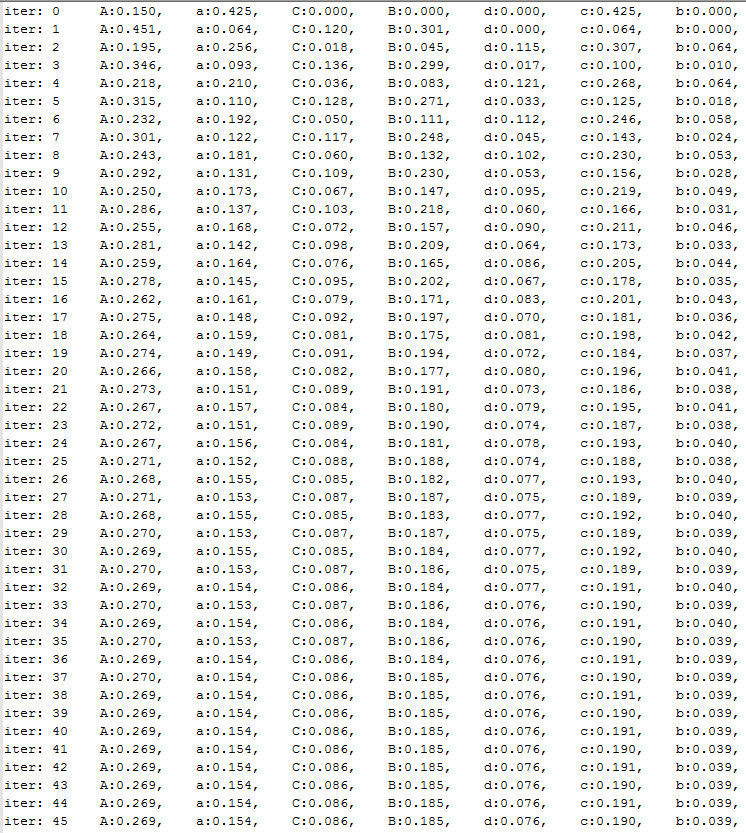

最终各个节点的概率结果如下所示:

上面的代码是对本文一开始描述的数据集中的用户A进行推荐。上图给出了不同迭代次数后各节点的概率值。发现46次迭代之后,所有节点的概率值全都收敛。在这个例子中,A用户没有产生过行为的物品是b和d,相对于A的访问概率分别是0.039,0.076,d的访问概率显然要大于b,所有给A用户的推荐列表为{d,b}