软件准备信息,详见Spark2.2.0集群搭建部署之【软件准备篇】

基础配置信息,详见Spark2.2.0集群搭建部署之【基础配置篇】

SSH无密访问,详见park2.2.0集群搭建部署之【无密访问篇】

HADOOP集群,详见Spark2.2.0集群搭建部署之【HADOOP集群篇】

解压spark-2.2.0-bin-hadoop2.7.7.tar.gz

tar -zxvf spark-2.2.0-bin-hadoop2.7.7.tar.gz

配置环境变量, vi /etc/profile

export SPARK_HOME=/root/xdb/spark-2.2.0-bin-hadoop2.7

export PATH=$PATH:$SPARK_HOME/bin刷新,source /etc/profile。

进入$SPARK_HOME/conf目录,拷贝 cp spark-env.sh.template spark-env.sh ; cp slaves.template slaves

master配置spark-env.sh文件,添加以下内容

export SCALA_HOME=/root/xdb/scala-2.11.11/

export JAVA_HOME=/usr/lib/jvm/java-1.8.0-openjdk

export SPARK_MASTER_IP=192.168.195.129

export SPARK_EXECUTOR_INSTANCES=1

export SPARK_WORKER_INSTANCES=1

export SPARK_WORKER_CORES=1

export SPARK_WORKER_MEMORY=1024M

export HADOOP_CONF_DIR=/root/xdb/hadoop-2.7.7/etc/hadoop

export SPARK_MASTER_WEBUI_PORT=8080

export SPARK_MASTER_PORT=7077

export SPARK_LOCAL_IP=192.168.195.129

export SPARK_MASTER_HOST=192.168.195.129修改$SPARK_HOME/conf/slaves,添加如下内容:

master

slave1同理,slave1中也配置上述信息,不过这条信息对应需要修改下。

export SPARK_LOCAL_IP=192.168.195.128

在Master节点启动集群

$SPARK_HOME/sbin/start-all.sh 可查看jps,会对应新增master以及worker进程。

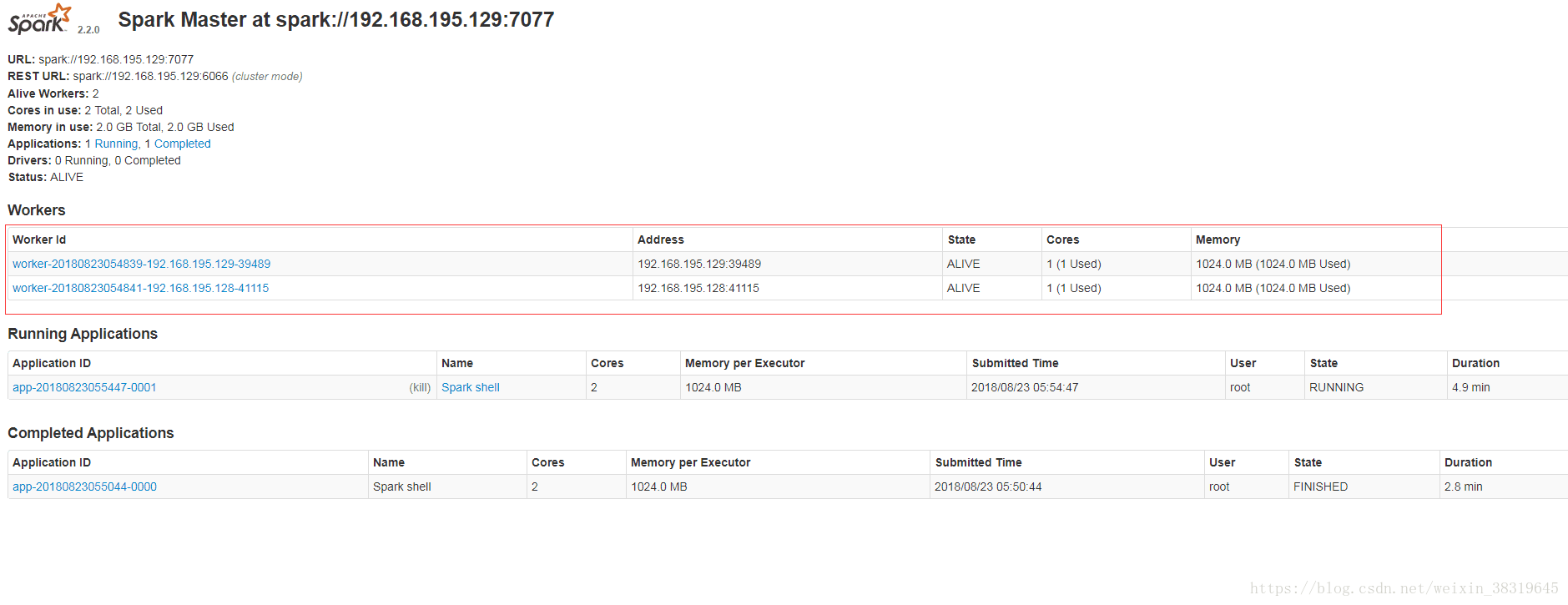

Spark管理界面, http://192.168.195.129:8080即可访问,workers栏目下有对应的master以及slave1。

通过命令,可以在管理页面中添加application

cd /root/xdb/spark-2.2.0-bin-hadoop2.7/bin

spark-shell --master spark://master:7077