版权声明:本文为博主原创文章,未经博主允许不得转载。 https://blog.csdn.net/zhaohaibo_/article/details/84260310

写在开头:为了避免不必要的麻烦,最好使用一个全新的系统按照本文步骤搭建Spark环境。

步骤:

1 下载并解压scala、spark文件。

2 安装java环境

3 安装python(2.7)环境

4 配置环境变量

Step1: 下载并解压scala、spark文件。

均下载最新版本就好

https://www.scala-lang.org/download/

http://spark.apache.org/downloads.html

分别把scala与spark的安装包解压到/usr/local/

sudo tar -zxvf scala-2.12.7.tgz -C /usr/local/

sudo tar -zxvf spark-2.4.0-bin-hadoop2.7.tgz -C /usr/local/

Step2:安装java环境

sudo apt-get update

sudo apt-get install openjdk-8-jdk

Step3:安装python

sudo apt-get install python

Step4: 配置环境变量

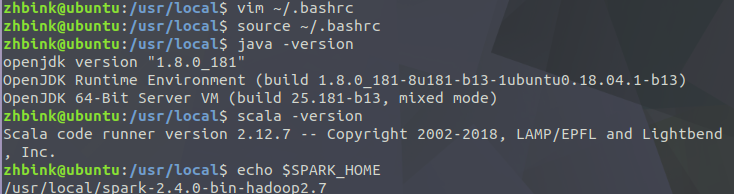

vim ~/.bashrc

(在最底)加入以下命令:

使环境变量生效:

source ~/.bashrc

验证环境变量是否生效:

java -version

scala -version

echo $SPARK_HOME

至此,spark环境即搭建完成。

扫描二维码关注公众号,回复:

4212756 查看本文章

使用spark-shell:

使用pyspark: