前面的博客中对SVM进行了细腻的理论推导。这里,笔者想可以更进一步思考。

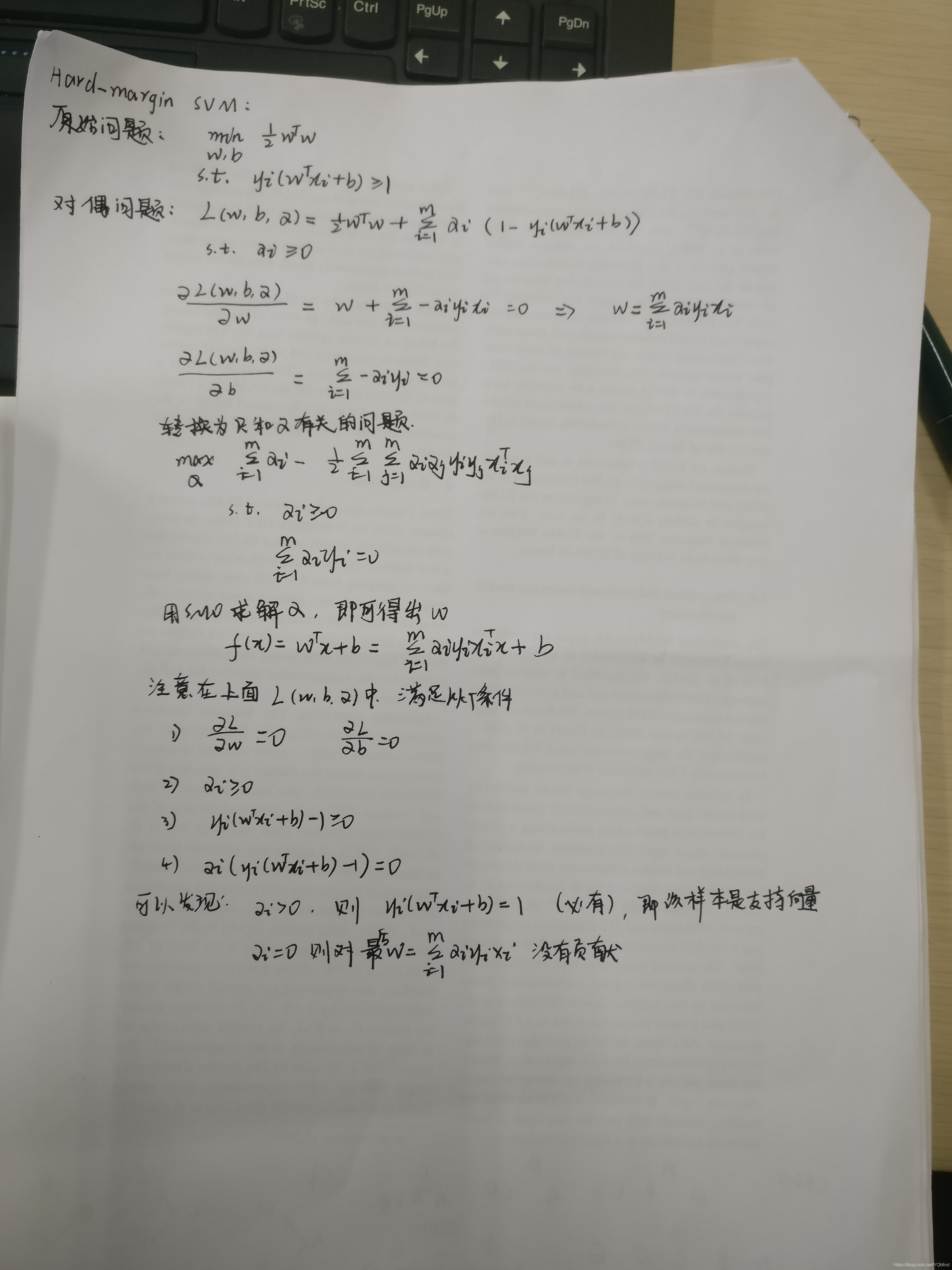

重温hard-margin SVM的推导

在SVM中,样本标签是{1,-1},而不是经常接触的{0,1},这样设计是为了便于公式的推导。

,其中m是样本数。

Kernel Trick

将样本x映射到新的空间

,我们在新的空间里进行hard margin svm。推导过程不变,只需将图片里的x换为

即可。

核函数就是

则

Kernal trick不局限于SVM

any L2-regularized linear model can be kernelized!!!

并且最优

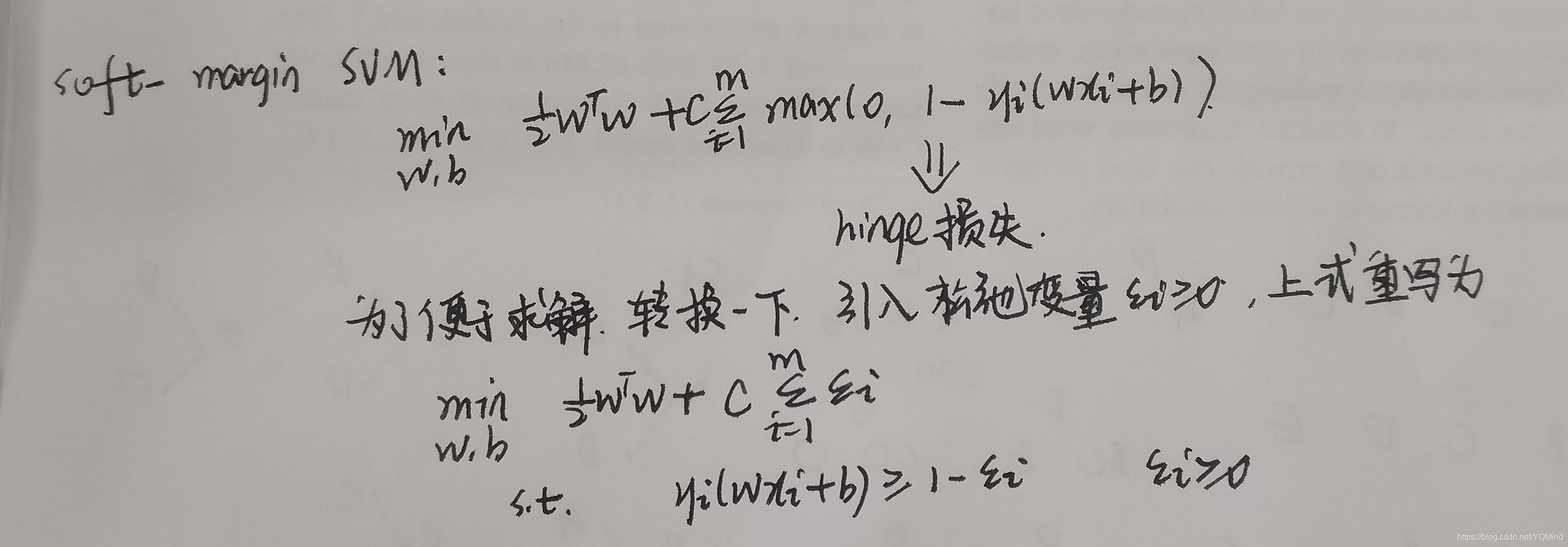

首先,我们需要回忆一下soft margin SVM

本质上,soft-margin SVM是带有L2正则化的hinge loss(合页损失)

通过KKT条件,可知soft-margin svm采用了hinge loss,仍然保持了解的稀疏性

SVR

带有L2正则化的

不敏感损失,同样解具有稀疏性。

在实际使用中,soft-margin SVM相比hard margin SVM使用的更多。

Kernel Logistic Regression

把

带入损失函数中,转为求解

的问题

注意: 不同于SVM, kernel logistic regression的解并不稀疏,因此预测开销很大

Kernel ridge regression:

把

带入损失函数中,转为求解

的问题

同样是解并不稀疏,预测开销很大

Support Vector Regression(SVR):

解稀疏