Slimmable neural networks

ICLR2019

Code and models will be released

可瘦身的神经网络,针对不同硬件和运行环境,可以快速提供与之相适应的CNN模型来完成任务。

硬件配置好的,给一个大模型,硬件配置差的,给一个小点的模型。同一个模型,设置一下参数就可以了

At runtime, the network can adjust its width on the fly according to on-device benchmarks and resource constraints, rather than downloading and offloading different models.

在 runtime 阶段,网络可以根据 on-device benchmarks and resource constraints 快速调整网络的宽度( number of channels in a layer),不用重新下载不同的模型

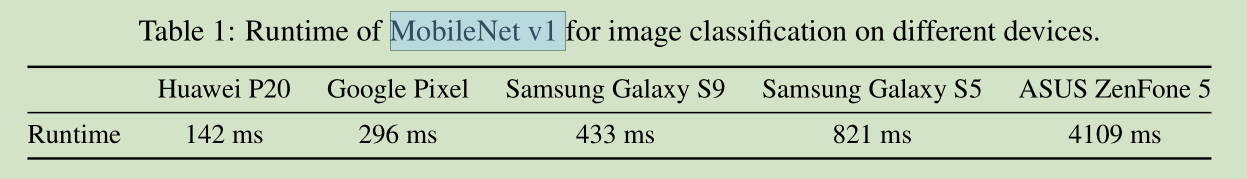

同一个网络模型在不同的设备上运算时间也是不一样的。

反过来,对于不同的硬件设备及运行环境,我们能否快速的提供与之相适应的CNN网络模型来完成相关的任务了?

Given budgets of resources, how to instantly, adaptively and efficiently trade off between accuracy and latency for neural networks at runtime?

如何实现这个目的了? 在训练的过程时,我们对不同的 switches 采用 independent batch normalization

Switchable Batch Normalization (S-BN), that employs independent batch normalization (Ioffe & Szegedy, 2015) for different switches in a slimmable network.

4分支网络和 8 分支网络性能对比

In general, slimmable neural networks perform better than those that are individually trained. The gain of performance is presumably due to implicit model distillation (Hintonet al., 2015; Romero et al., 2014) and richer supervision signals

11