为什么需要激活函数Activation Function?

举个例子,首先我们有这个需求,就是二分类问题,如我要将下面的三角形和圆形点进行正确的分类,如下图:

利用我们单层的感知机, 用它可以划出一条线, 把平面分割开:

很容易能够看出,我给出的样本点根本不是线性可分的,一个感知器无论得到的直线怎么动,都不可能完全正确的将三角形与圆形区分出来,那么我们很容易想到用多个感知器来进行组合,以便获得更大的分类问题,下面我们上图,看是否可行:

我们已经得到了多感知器分类器了,那么它的分类能力是否强大到能将非线性数据点正确分类开呢~我们来分析一下:

我们能够得到

我们来给它变个形.上面公式合并同类项后等价于下面公式:

不管它怎么组合,最多就是线性方程的组合,最后得到的分类器本质还是一个线性方程,该处理不了的非线性问题,它还是处理不了。就好像下图,直线无论在平面上如果旋转,都不可能完全正确的分开三角形和圆形点:

既然是非线性问题,总有线性方程不能正确分类的地方。

激活函数,神经网络中每一层叠加完了之后,我们需要加入一个激活函数(激活函数的种类也很多,如sigmoid等)这里给出sigmoid例子,如下图:

通过这个激活函数映射之后,输出很明显就是一个非线性函数。

同理,扩展到多个神经元组合的情况时候,表达能力就会更强,对应下图:

最后再通过优化损失函数的做法,能够学习到不断靠近正确分类三角形和圆形点的曲线。

具体会学到什么曲线,也许是下面这样:

那么随着不断训练优化,也就能够解决非线性的问题了。

所以到这里为止,我们就解释了这个观点,加入激活函数是用来加入非线性因素的,解决线性模型所不能解决的问题。

有什么激活函数Activation Function?

1. sigmod函数

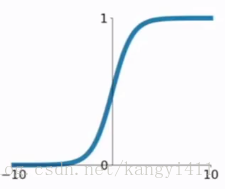

函数公式和图表如下图

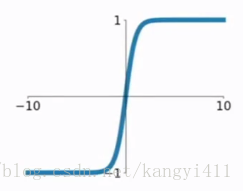

2.tanh函数

tanh函数公式和曲线如下

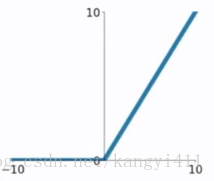

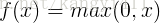

3.ReLU函数

ReLU函数公式和曲线如下

4.ELU函数

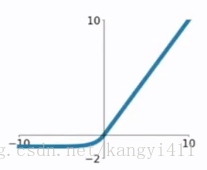

ELU函数公式和曲线如下图

5.PReLU函数

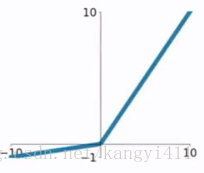

PReLU函数公式和曲线如下图