Logistic Regression也叫Logit Regression,在机器学习中属于参数估计的模型。逻辑回归与普通线性回归(Linear Regression)有很大的关系。在应用上,它们有所区别:

- 普通线性回归主要用于连续变量的预测,即,线性回归的输出

y 的取值范围是整个实数区间(y∈R ) - 逻辑回归用于离散变量的分类,即,它的输出

y 的取值范围是一个离散的集合,主要用于类的判别,而且其输出值y 表示属于某一类的概率

一个单独的逻辑回归函数只能判别两个类,这里用0和1表示. 逻辑回归的结果会给出一个概率

逻辑回归应用广泛,而且因为给出的结果是一个概率,比单纯的“是”或“不是”包含更多的信息,因此大受人们喜爱(误)。我们之前参加Kaggle广告点击率预测竞赛时使用的就是逻辑回归。因为用户要么点了广告,要么没点,我们给出一个概率,就可以判断用户的点击广告的可能性。这个预测看起来很简单,的确是,模型很简单的,难的地方在于features的分析,选取,综合等,也就是常说的pre-processing。

文章内容

很多文章介绍逻辑回归时会直接给出一个叫sigmoid的函数,该函数的值域范围是

Odds与Logit函数

逻辑回归的输入是一个线性组合,与线性回归一样,但输出变成了概率。而且逻辑回归用于预测两类问题,类似一个伯努利试验。假设在一个伯努利试验中,成功的概率是

我们定义:

上式很直观,表示成功的概率是失败概率的多少倍,中文叫做 发生比。

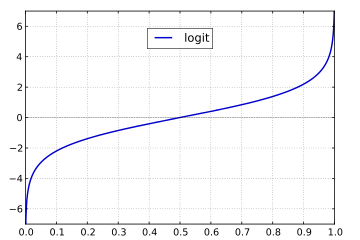

对Odds取自然对数:

上式即为logit函数的定义,参数为

但我们要的是定义域是

上式中

输入与输出

在(4)式中,输入的参数

则(4)式的sigmoid函数可以写成:

上式就是逻辑回归的一般用法。注意到它的输入还是一个线性组合,跟线性回归的输入是一样的,只不过计算的时候比线性回归多了一层函数,因此这就是为什么会有文章说 逻辑回归的本质还是线性回归,也会看到有一些文章说 在特征到结果的映射中多加了一层函数映射,这个函数映射就是sigmoid。

(5)式是计算概率

令

对上式两边取自然底数,有:

通常会将上式写成

上式就是(5)式。这样求概率

虽然逻辑回归通常用于两个类的判别问题,但是将多个逻辑回归函数组合起来就可以解决多类判别的问题。

Refrence

Youtube上有一个关于Logistic Regression的视频的入门级系列介绍,本文就是根据这个系列的介绍写的。想对Logistic Regression有快速的了解可以参考这个系列视频(可惜要翻墙,QQ)

https://www.youtube.com/watch?v=zAULhNrnuL4