好久没有更新SLAM系列的内容了,现在开始继续记录一下关于SLAM建图部分学习中的重要知识。

建图概述

在经典的slam模型中,所谓的地图,即所有路标点的集合。一旦确定了路标点的位置,那就可以说我们完成了建图。所以不管是视觉历程计也好,回环检测也好,事实上都建模啦路标点的位置,并对它们进行优化。从这个角度上说,为什么要单独的来详细的学习建图呢?

这是因为人们对建图的需求不同。SLAM作为一种底层技术,往往是用来为上层应用提供信息的。如果上层是机器人,那么应用层的开发者可能希望使用SLAM来做全局的定位,并且让机器人在地图中导航---例如扫地机需要完成扫地工作,希望计算一条能够覆盖整张地图的路径。或者,如果上层是一个AR设备,那么开发者可能希望将虚拟物体叠加在现实物体上,特别地,还可能需要处理虚拟物体和真实物体的遮挡关系。

应用层面对定位的需求是相似的,都是希望SLAM提供相机或搭载相机的主体空间位姿信息。但对于地图,则存在着许多不同的需求。地图的作用大致归纳如下:

1.定位:定位是地图的一项基本功能。

2.导航:导航是指机器人能够在地图中进行路径规划,在任意两个地图点间寻找路径,然后控制自己运动到目标点的过程。该过程中,我们至少需要知道 地图中哪些地方不可以通过,而哪些地方是可以通过的。这就超出了稀疏特征点地图的能力范围,我们必须有另外的地图形式。(这至少是一种稠密的地图)

3.避障:与导航类似,但更注重局部的、动态的障碍物的处理。同样,仅有特征点,我们无法判断某个特征点是否为障碍物,所以需要稠密地图。

4.重建:利用slam获得周围环境的重建效果,并把它展示给其他人看,这就对它的外观上有一些要求。

5.交互:主要指人与地图之间的交互。例子略,这就需要机器人对地图有更高层的认知----语义地图。

极限搜索与块匹配

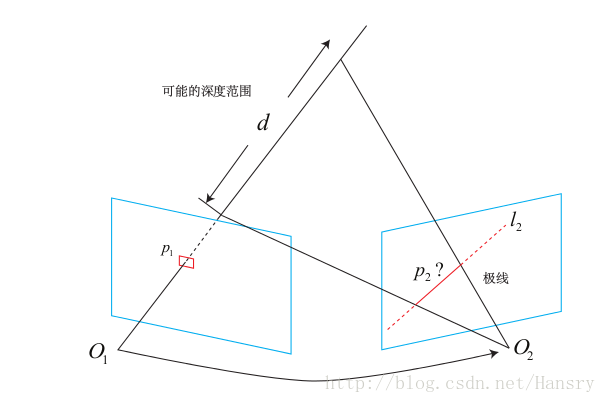

左边的相机观测到了某个像素p1。由于是单目相机,所以我们不知道它的深度,所以假设深度可能在。在另一个视角看来,这条线段的投影也形成图像平面上的一条线,我们知道这是极线。当知道两部相机间的运动时,这条极线也是能够确定的。那么问题就是:极线上的哪个点是我们刚才看到的p1点呢?(在特征点方法中,通过特征匹配找到了p2的位置。然而现在我们没有描述子)只能在极线上搜索和P1长得比较相似的点。具体的说,我们可能沿着第二幅图像中的极线的某一头走到另一头,逐个比较每个像素与p1的相似程度。从直接比较像素的角度来看,这种做法倒是和直接法是异曲同工的。

比较单个像素的亮度值并不一定稳定可靠,一件很明显的事就是:万一极线上有很多和p1相似的点,我们怎么确定哪个是真实的呢?这似乎和回环检测中如何确定两幅图像(点)的相似性一样。回环检测是通过词袋来解决的,但这里由于没有特征,所以只好寻求另外的途径。

一种直观的想法是:在p1周围取一个大小为w*w的小块,然后在极线上也取很多同样大小的小块进行比较,就可以在一定程度上提高区分性。这就是所谓的块匹配。(只有假设在不同图像间整个小块的灰度值不变,这种比较才有意义)。所以算法的假设,从像素的灰度不变性,变成了图像块的灰度不变性-------在一定程度上变得更强了。

好了,现在我们取了p1周围的小块,并且在极线上也取了很多个小块。不妨把p1周围的小块记成,把极线上的n个小块记成Bi,i=1...n。如何计算小块与小块间的差异呢?有以下几种不同的方法:

1.SAD(Sum of Absolute Difference)顾名思义,即取两个小块的差的绝对值之和:

2.SSD(Sum of Squared Distance)

3.NCC(Normalized Cross Correlation,归一化互相关) 这种方式比前两种要复杂一些,他计算的是两个小块的相关性:

这里用的是相关性,所以接近0表示不相似。而前面两种则是接近0表示相似。

这些计算方式往往存在一个精度-效率之间的矛盾。精度好的方法往往需要复杂的计算,而简单的快速算法又往往效果不佳,这需要在实际工程中进行取舍。除了这些简单的版本外,我们可以先把每个小块的均值去掉。去掉均值后,我们准许像“小块B比A整体上亮一些,但仍然很相似”这样的情况。因此比之前的更加可靠一些。

现在,我们假设使用了NCC在极线上计算了A与每一个Bi的相似性度量。那么我们得到一个沿着极线的NCC分布(这个分布的形状严重取决于图像本身的样子)在搜索距离较长的情况下,通常会得到一个非凸函数:这个分布存在着很多峰值,然而真实的对应点只有一个。在这种情况下,我们会倾向于使用概率分布来描述深度值,而非用某个单一的数值来描述深度。于是问题就转到了在不断对不同图像进行极线搜索时,我们估计的深度分布将发生怎么的变化----这就是所谓的深度滤波器。

下一篇将继续记录。。。。。。