版权声明:转载请注明出处 https://blog.csdn.net/qq_42844049/article/details/88405241

Command line tool:

其中全局命令可以不用进入项目使用项目命令必须进入项目使用

Windows 下创建一个scrapy项目:

打开cmd

scrapy createproject 项目名

如果你想在指定目录创建项目后面可以加上项目路径如:

scrapy createproject myproject c:\\scrapycode

或者是直接进入项目路径直接创建:

c:

cd scrapycode

scrapy createproject myproject

创建一个spider

scrapy genspider baidu www.baidu.com

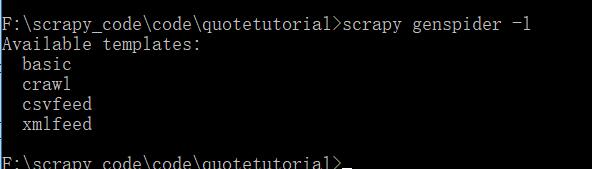

参数 -l查看可使用的模板

scrapy genspider -l

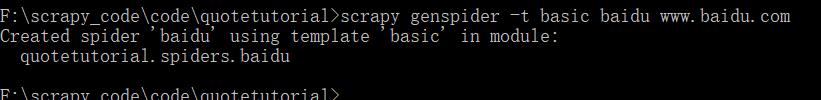

-t指定创建的模板如果对创建的spider有特殊需求的可以使用模板

scrapy genspider -t basic baidu www.baidu.com

运行spider:

scrapy crawl +spider的名字

查错:

scrapy check

可以检查spider中的语法错误是很好的调试工具

查看项目中所有spider的名称

scrapy list

编辑spider

scrapy edit +spider的名字

此命令不常用一般是创建好spider后在编辑器中打开编辑

fetch

和request、urlopen类似请求url并返回源代码

scrapy fetch http://www.baidu.com

参数

#不生成日志

scrapy fetch --nolog http://www.baidu.com

#返回响应头信息

scrapy fetch --headers http://www.baidu.com

#禁止重定向

scrapy fetch --no-redirect http://www.baidu.com

view

请求一个url并下载然后在浏览器中打开是一个很好的调试工具可以看出网页的数据那些是静态的哪些是ajax加载的

scrapy view http://baidu.com

shell

命令行交互模式可以调试程序

scrapy shell http://baidu.com

打开shell后可以输入如request response.text response response.headers 等命令调试程序还可以测试选择器是否能够选中标签如

response.css('.title::text').extract_first()

parse

解析网页需要进入项目目录

#-c 为回调后面加自己在项目中定义的parse

scrapy parse http://www.baidu.com -c parse

settings

配置信息

比如说我在settings中设置了mongodb的url我可以使用–get来获得它

scrapy settings --get MONGO_URI

-h可以打印帮助信息

runspider

#scrapy runspider +spider的文件名

scrapy runspider spider.py

他与crawl的区别是不用进入项目目录但是需要spider的文件名

version

查看scrapy的版本信息

scrapy version

-v

查看所有依赖库的版本

scrapy version -v

bench

测试性能每分钟可以爬取多少页面

scrapy bench