版权声明:博主原创文章属私人所有,未经允许 不可转发和使用 https://blog.csdn.net/a1066196847/article/details/87979398

一:这里有篇博客讲解了2种办法,博主采用了里面的第二种,并做了一点修改

https://blog.csdn.net/a532672728/article/details/79455024

二:

点next

点next

点Finish

点Finish

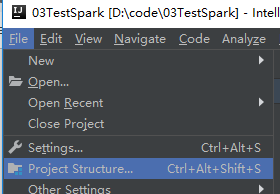

接下来是导入scala环境 + spark jar包

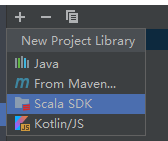

点+号

点+号

选择java选项,定位到你解压的spark那个目录下的jars目录,假如你的spark是在e盘:E:\spark\jars

然后是scala,选scala SDK  , 然后选择你下载的那个版本,选择好后 会提示你 Do you really want to replace old library 'scala-sdk-2.**'? 点No即可

, 然后选择你下载的那个版本,选择好后 会提示你 Do you really want to replace old library 'scala-sdk-2.**'? 点No即可

现在你的那个界面应该长这样: -》 apply -> ok

-》 apply -> ok

上面的环境以及搭建完毕

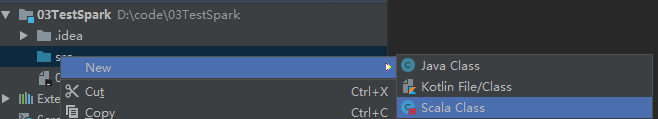

新建个scala class,Test.scala,记得改掉默认的calss为object

run 'Test'  最终出现这种东西就证明成功了

最终出现这种东西就证明成功了