笼统的说,Hive中的Join可分为Common Join(Reduce阶段完成join)和Map Join(Map阶段完成join)

一、Hive Common Join

如果不指定MapJoin或者不符合MapJoin的条件,那么Hive解析器会将Join操作转换成Common Join,即:在Reduce阶段完成join.

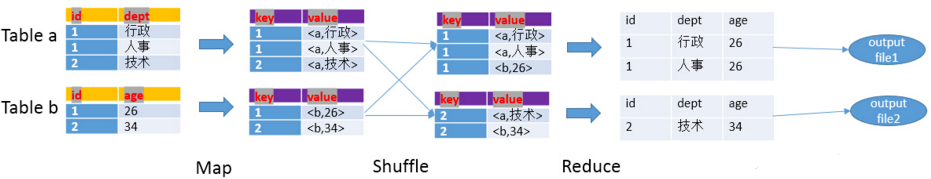

整个过程包含Map、Shuffle、Reduce阶段。

Map阶段

读取源表的数据,Map输出时候以Join on条件中的列为key,如果Join有多个关联键,则以这些关联键的组合作为key;

Map输出的value为join之后所关心的(select或者where中需要用到的)列;同时在value中还会包含表的Tag信息,用于标明此value对应哪个表;

按照key进行排序

Shuffle阶段

根据key的值进行hash,并将key/value按照hash值推送至不同的reduce中,这样确保两个表中相同的key位于同一个reduce中

Reduce阶段

根据key的值完成join操作,期间通过Tag来识别不同表中的数据。

以下面的HQL为例,图解其过程:

SELECT

a.id,a.dept,b.age

FROM a join b

ON (a.id = b.id);

二、Hive Map Join简介

1 什么是MapJoin?

MapJoin顾名思义,就是在Map阶段进行表之间的连接。而不需要进入到Reduce阶段才进行连接。这样就节省了在Shuffle阶段时要进行的大量数据传输。从而起到了优化作业的作用。

2 MapJoin的原理

通常情况下,要连接的各个表里面的数据会分布在不同的Map中进行处理。即同一个Key对应的Value可能存在不同的Map中。这样就必须等到Reduce中去连接。

要使MapJoin能够顺利进行,那就必须满足这样的条件:除了一份表的数据分布在不同的Map中外,其他连接的表的数据必须在每个Map中有完整的拷贝。

3 MapJoin适用的场景

通过上面分析你会发现,并不是所有的场景都适合用MapJoin. 它通常会用在如下的一些情景:在二个要连接的表中,有一个很大,有一个很小,这个小表可以存放在内存中而不影响性能。

这样我们就把小表文件复制到每一个Map任务的本地,再让Map把文件读到内存中待用。

4 Hive内置提供的优化机制之一就包括MapJoin

MapJoin通常用于一个很小的表和一个大表进行join的场景,具体小表有多小,由参数 hive.mapjoin.smalltable.filesize来决定,该参数表示小表的总大小,默认值为25000000字节,即25M.

在Hive 0.7之前,需要使用hint提示 /*+ mapjoin(table) */才会执行MapJoin,table必须是小表,不超过1G或者50万条记录,否则执行Common Join。Hive 0.7之后的版本已经不需要给出MapJoin的指示就进行优化,它是通过如下配置参数来控制的,默认为true:

hive> set hive.auto.convert.join=true;

三、Hive Map Join执行流程

假设a表为一张大表,b为小表,并且hive.auto.convert.join=true,那么Hive在执行时候会自动转化为MapJoin。

如图中的流程,首先是Task A,它是一个Local Task(在客户端本地执行的Task),负责扫描小表b的数据,将其转换成一个HashTable的数据结构,并写入本地的文件中,之后将该文件加载到DistributeCache中,该HashTable的数据结构可以抽象为:

|key| value|

| 1 | 26 |

| 2 | 34 |

local work

- 通过标准表扫描(包括过滤器和投影)从本地计算机上的源读取记录

- 在内存中构建哈希表

- 将哈希表写入本地磁盘

- 将哈希表上传到dfs

- 将哈希表添加到分布式缓存中

接下来是Task B,该任务是一个没有Reduce的MR,启动MapTasks扫描大表a,在Map阶段,根据a的每一条记录去和DistributeCache中b表对应的HashTable关联,并直接输出结果。

map task

- 从本地磁盘(分布式缓存)读取哈希表到内存中

- 匹配记录的key和hash表的key

- 组合匹配并写入输出

由于MapJoin没有Reduce,所以由Map直接输出结果文件,有多少个Map Task,就有多少个结果文件

参考:https://blog.csdn.net/ych0112xzz/article/details/81186204