论文地址: VISUAL SEMANTIC NAVIGATION USING SCENE PRIORS

1. 介绍

论文的目标是使用场景先验知识来改善陌生场景中未知物体的导航效果,具体地,如下图所示,从以往的经验中要在厨房中找一个苹果那么很有可能在冰箱中找到,那么此时要在厨房中找某一样我们从未见过的水果时,它可能也在冰箱里,这就是基于先验知识的视觉语义导航,在该任务中,环境、目标的位置与出现形式,智能体到目标的路线都是未知的。

论文提出使用图卷积神经网络集成先验知识到增强学习框架中的方法,由于图卷积神经网络支持任意结构的图以高效的形式进行编码,该方法提出将智能体(agent)的先验知识编码到图谱中,智能体使用知识图谱中的特征来进行预测的同时更新图谱中的内容以获得当前特定环境的先验知识。该方法使用语义知识显著地提升了视觉语义导航的性能,而且在未知场景和未知物体出现的时候泛化能力十分强大。

论文的主要贡献在于:

- 集成了一个带有图卷积神经网络的深度增强学习框架使得智能体能够编码任何能够被图结构表征的知识;

- 论文的研究表明语义先验知识能够显著提升导航性能

- 通过集合目标的语义和先验信息,论文提出的方法拥有较好的泛化能力(位置场景,位置物体)

2. 相关工作

基于语义和目标导向的导航是智能体日常生活中最重要的活动,视觉导航中有几个难点,一是环境可能对智能体是未知的,这就需要智能体取探索环境已获得对当前环境更好的理解;二是目标物体可能在场景中不可见,因此智能体需要学习一个高效的搜索方式;第三个难点就是路线的计划,目前已经有多项研究致力于解决这三个问题

- 基于几何学的导航:要求当前环境已经是先验知识的一部分。论文提出的方法不依赖这种先验并且使用语义先验知识降低环境探索时间;

- 基于学习的导航 :也就是论文所研究的方向,和以往方法不同的是,该方法继承了语义和功能先验来改善导航性能和对位置场景与物体的泛化能力;

- 语义与场景先验:虽然语义推理已经被广泛研究,但是大多应用在静态图像的处理中。论文中的方法将语义推理应用到交互式的导航任务中,智能体通过当前的观测更新自己的知识;

- 知识图谱:知识图谱在计算机视觉任务中应用广泛(提到了图像分类和零样本),论文用在增强学习中

- 对于未知环境或目标 的推理:零样本推理在语义增强学习中多有应用,但是该论文提到的方法使用场景先验增强对未知物体或在未知场景中的导航,与以往的应用不同。

3. 视觉语义导航

3.1 任务定义

任务是给定一个以智能体视角的RGB场景,智能体从一个随机起始位置导航至特定类目标物体,其中类别是通过语义标签声明的,所以任务称为视觉语义导航。当目标物体类的一个实例在智能体视线范围且小于某个距离的时候,认为该任务成功。

3.2 Baseline模型

通过深度增强学习框架对视觉语义导航任务进行形式化的描述。给定一个语义任务目标

,智能体在时间

处在状态

,并且已经根据策略

从可能的动作集合

中选取了一个动作

,用如下公式逼近

:

其中

都是网络的参数,因为视觉状态和语义目标来自不同的形式,所以论文设计了两个分支即

和

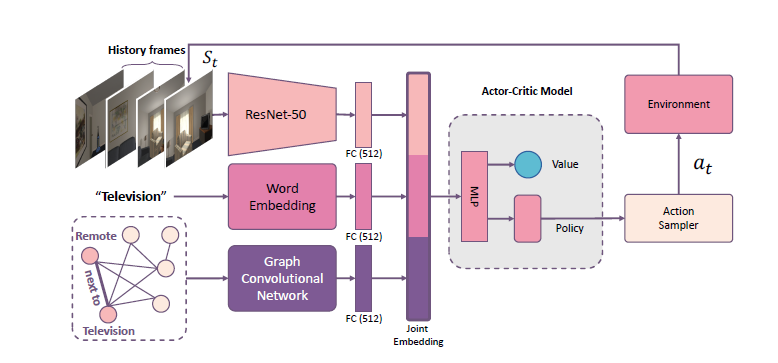

分别映射两个不同的输入到视觉语义特征嵌入模块,方法整体框架如下所示,模型集成语义知识进行语义导航,具体地,首先学习一个policy网络基于当前状态的视觉特征,语义目标类的特征以及从知识图谱中抽取的特征来决定要采取的动作。

视觉网络:如上图顶部所示,视觉网络以 224 x 224的RGB图像作为输入,经过主干网络(ImageNet上预训练的ResNet50)后连接全连接层生成一个512维的视觉语义特征向量

语义网络:语义目标任务通过目标的类别来描述,使用fastText为每一个类别单词计算一个100维的向量然后通过全连接层和ReLU层映射为一个512维的向量(上图中间)

Actor-Critic policy network:应用A3C算法预测每一步的动作。A3C模型的输入是当前视觉状态和语义目标任务的联合表示(1024维向量),有两个输出,policy和值,要采取的动作根据policy获得。A3C模型是一个多层感知机,由输入层,隐藏层和输出层组成。隐藏层是一个带有ReLU激活层的全连接层映射输入到一个512维向量,然后

维policy和值通过网络的这两个分支生成。不同于之前的工作,该论文使用同一个policy网络应对不同的场景,这使得模型泛化能力更强。

奖惩机制:使用奖惩机制最小化到目标物体路线的长度。当智能体走一步的时候目标物体类的一个实例距智能体距离在某个阈值之内,给这一步设置一个较大的奖励比如10,否则设置一个惩罚-0.01。奖励函数的设计与动作集合

有关,论文的实验中设置了两个动作集合,一个包含停止动作一个没有。没有停止动作的动作集合中,智能体在环境识别到其接近目标是会得到奖励从而结束这一段的训练。在有停止动作的集合中,训练只有在采取停止动作时才会停止,并且智能体面向目标物体且距离在某一阈值时,才会得到奖励。这使得任务更加具有挑战性。

4. 使用图卷积神经网络进行推广泛化

论文目标是将语义知识集成到增强学习框架中,为此,论文将语义知识表示为图的形式然后使用图卷积神经网络计算途中的相关特征。图卷积网络可以集成先验知识并且动态更新。

论文这一节显示简单介绍怎样构建语义知识图谱来表示先验知识,然后介绍图卷积神经网络的北京,最后是应用图卷积神经网络到视觉语义导航任务中的细节并且展示图卷积神经网络在面对未知的场景和陌生的物体时进行泛化。

4.1 知识图谱的构建

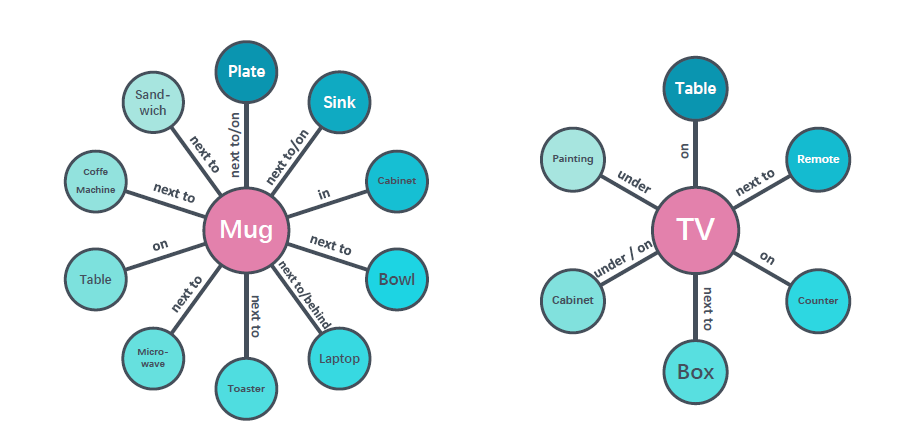

如下图所示

4.2 集成语义知识到Actor-Critic模型中

用图结构表示信息在不同节点之间的传播,首先基于当前状态初始化每个节点然后进行信息传递来计算一个语义知识向量作为policy函数的另一个输入特征,信息传递就是用了图卷积神经网络。

4.2.1 图卷积神经网络GCN

输入每个图节点

的向量为

,将所有节点的输入表示为一个矩阵

,其中

表示输入特征的维度。图结构被标识为一个二维邻近矩阵

,对

进行规则化处理得到

。GCN输出一个节点层次的表示

,令

表示ReLU激活函数,有如下公式:

且 ,其中 是第 层的参数L是GCN的层数。

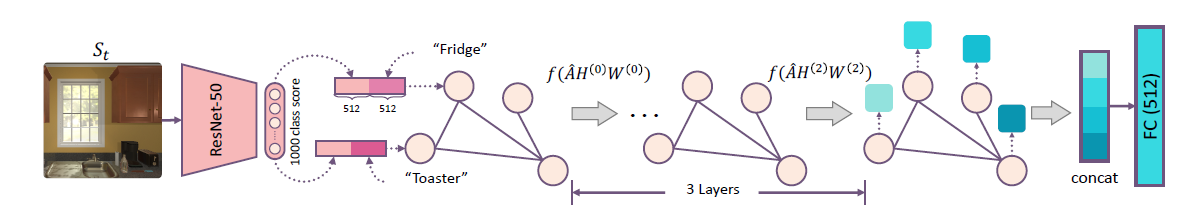

4.2.2 GCN 用于导航

在视觉语义导航任务中,每个节点都被设计为一个所有语义和视觉线索的联合表示。(语义线索即词向量,视觉线索即集合当前状态

的分类的分数),通过之前提到的算法生成一个1024维的向量用于来表征图中的每个节点。

如上图所示,使用一个三层图卷积神经网络,前两层输出1024维特征,最后一层为每个节点输出单个值也就是一个

维的向量,该特征向量是当前场景的语义先验。

最后,将特征向量映射为512维然后和之前视觉、语义分支的特征concat获得一个1536维的向量,然后特征输入policynetwork用于预测。

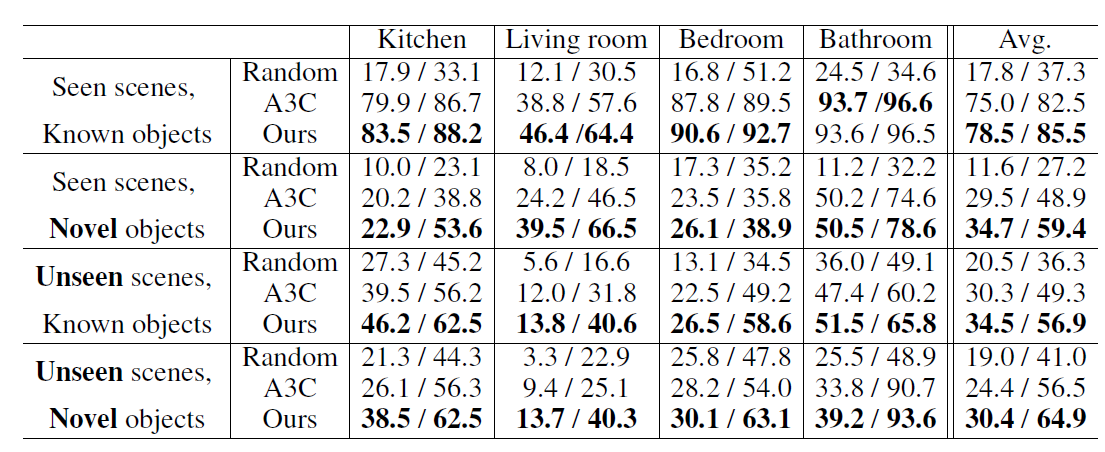

5. 实验

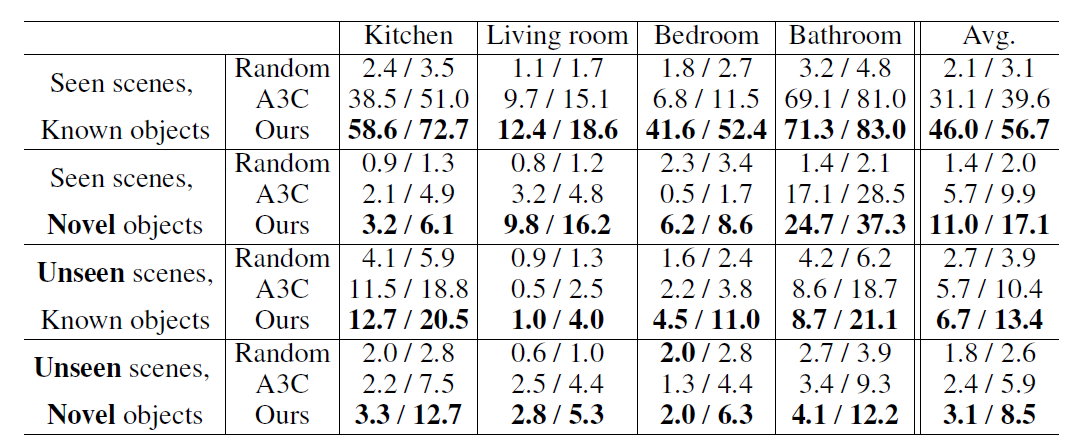

使用高仿真框架AI2-THOR进行方法的测试,用两个指标来评价,一个是成功率,智能体成功导向目标的次数比上所有尝试的次数;另一个是Success weighted by Path Length(SPL),这个指标同时考虑了步数和距离,

,其中N是该阶段尝试的次数,

表示阶段是否成功的二值标志,

表示路径长度,

表示阶段i的最短路径。

实验结果如下:

a. with stop acction

欢迎扫描二维码关注微信公众号 深度学习与数学 [每天获取免费的大数据、AI等相关的学习资源、经典和最新的深度学习相关的论文研读,算法和其他互联网技能的学习,概率论、线性代数等高等数学知识的回顾]