这个问题困扰了很久,首先今天细细看了一下操作细节:Hadoop + Hive + Spark 完整安装攻略

但是一直卡在这里:

#启动 Hdfs

$HADOOP_PREFIX/sbin/start-dfs.sh

如上图:会在

node2: starting datanode, logging to /usr/local/hadoop/logs/hadoop-root-datanode-10.211.55.102.out

那一行卡住不动,敲回车之后就是

Permission denied (publickey,gssapi-keyex,gssapi-with-mic)

中间按照这个页面Linux系统下的ssh使用 (依据个人经验总结)的以下内容作了修改:

(5)ssh登录出现:permission denied(publickey.gssapi-with-mic)

解决方法:

修改/etc/ssh/sshd-config文件,将其中的:

PermitRootLogin no修改为yes

PubkeyAuthentication yes

AuthorizedKeysFile .ssh/authorized_keys前面加上#屏蔽掉

PasswordAuthentication no修改为yes

最后重启sshd服务即可!(service sshd restart)

依然没有效果,最后在这里找到了答案:求救!hdfs无法正常启动!

发现确实,自己在这一步设置了密码:

所以才一直启动失败!重新操作以后终于可以了!

把Hadoop + Hive + Spark 完整安装攻略的内容抄过来担心以后页面会删掉,侵删:

- Prerequisites

桌面环境: Mac OSX

虚拟机管理软体: Vagrant

虚拟机: Virtual Box- Clone repo

git clone https://github.com/bryanyang0528/hellobi

cd hellobi/pyspark/env

- download files

mkdir files

sh download_file.sh

- vagrant up

这边会 up 很久

- 一切正常运行,有红字跳出来也不用怕

- copy ssh key

进入 master 的 root 帐号,把 id_rsa.pub 复制到 authorized_keys 里

接着把 public key 丢给 node

回到 master 后确认连线状况

HADOOP

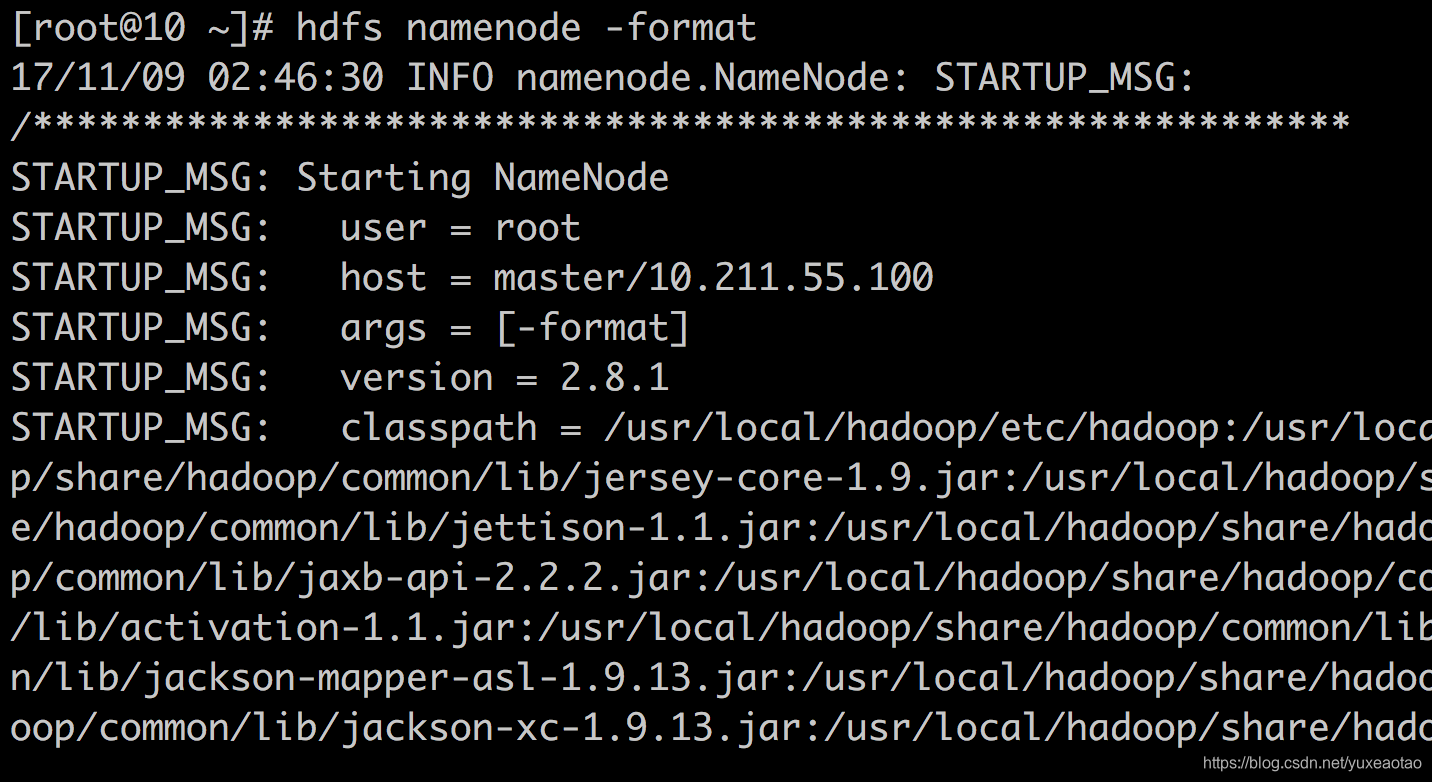

- Format namenode

hdfs namenode -format

- 启动 Hdfs

$HADOOP_PREFIX/sbin/start-dfs.sh

- 确认

hdfs dfsadmin -report- 启动 Hdfs

$HADOOP_PREFIX/sbin/start-yarn.sh- netstat -nlopt

- 启动集群

/usr/local/spark/sbin/start-all.sh- netstat -nlopt

当出现的结果显示出7077(spark master)和8080(spark UI)两个port被占用的时候,就表示spark成功执行了

/usr/local/spark/sbin/start-all.sh- netstat -nlopt

- pyspark --master spark://10.211.55.100:7077

- 直接敲pyspark启动默认是用本机来执行的,以上是让master来执行