参考文献:

https://www.cnblogs.com/pinard/p/9385570.html

之前有一个项目在算法设计阶段用到了强化学习方案,突击了两周学习了一些基础知识,虽然后来由于项目方向变更方案没有实施,但由此对强化学习产生了兴趣,也断断续续的看一些相关的材料。最近在看刘建平的强化学习笔记,觉得写的思路清晰易懂,遂参照其思路也记录一下自己对强化学习的理解。

一、什么是强化学习?

强化学习和人类学习的方式比较像,都是从实践中获得经验,不断的进化。举个例子:

看电视和写作业。小明的爸妈不在家,小明一开始出于让自己爽而看电视,爸妈回来后发现就批评小明,罚一天的零花钱。小明从这个行为反馈的经验中得到了负反馈,第二天小明出于长远利益的考虑就会先把作业写完了再去看电视。当然,这个例子貌似也不是很百分百,因为总有些熊孩子可以每天都看电视。

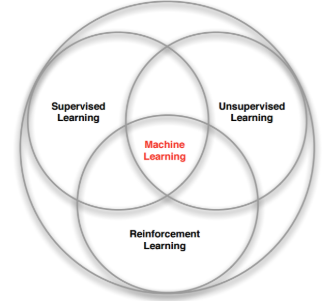

那么强化学习和我们通常所说的机器学习有什么关系呢?看下图:

强化学习是和监督学习、无监督学习并列的一种学习方式。

强化学习和监督学习比较,强化学习是没有标签的,而监督学习是基于一堆有便签样本训练,而强化学习中的奖励也是在动作发生后给出,而不是在事先给出的。

强化学习个无监督学习比较,他们的区别还是在奖励这个地方,无监督学习是纯基于元数据,没有标签也没有奖励。同时,无监督学习的样本和监督学习一样样本之间是独立的,而强化学习处理的样本往往是一个有前后依赖关系的序列。

二、强化学习的建模