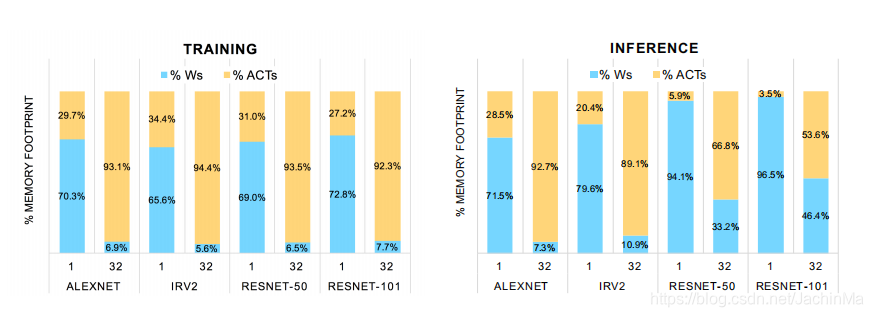

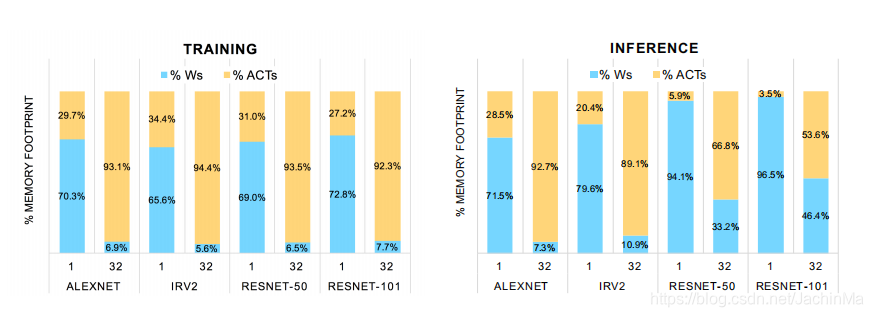

这篇文章的主要提升点在激活层的量化。从上图可以看出,当使用mini-batch时,随着batch数的提升,激活层所占据的内存也显著提升。

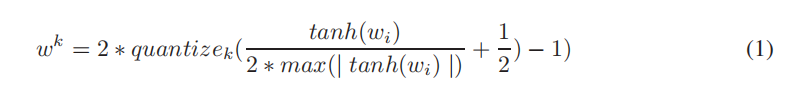

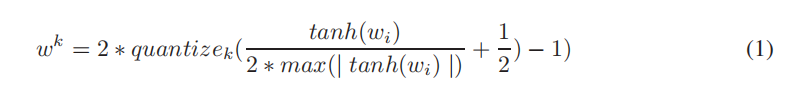

不同于drrefa-net的量化方式:

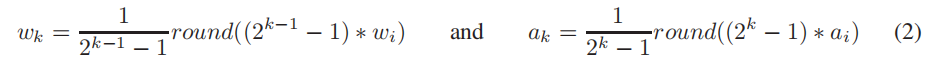

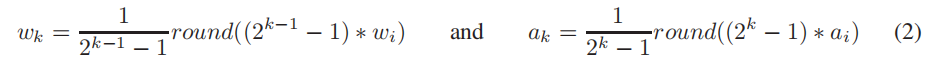

wrpn采取了更简单的量化方式:

wrpn采取了更简单的量化方式:

文章用大量篇幅描述了作者所做的实验,但是对于wrpn的原理只是寥寥几句。所以我并不确定我的理解是否正确,它的意思大概是:将特征图拓宽,分为几个,然后再进行量化。虽然前一个操作会增加消耗,但后一个会弥补这个消耗;同时拓宽的操作还会增加精度,使模型最终表现良好。

这篇文章的主要提升点在激活层的量化。从上图可以看出,当使用mini-batch时,随着batch数的提升,激活层所占据的内存也显著提升。

不同于drrefa-net的量化方式:

wrpn采取了更简单的量化方式:

wrpn采取了更简单的量化方式:

文章用大量篇幅描述了作者所做的实验,但是对于wrpn的原理只是寥寥几句。所以我并不确定我的理解是否正确,它的意思大概是:将特征图拓宽,分为几个,然后再进行量化。虽然前一个操作会增加消耗,但后一个会弥补这个消耗;同时拓宽的操作还会增加精度,使模型最终表现良好。