softmax用于多分类过程中,它将多个神经元的输出,映射到(0,1)区间内,可以看成概率来理解。

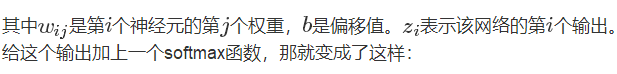

假设我们有一个数组,V,Vi表示V中的第i个元素,那么这个元素的softmax值就是:

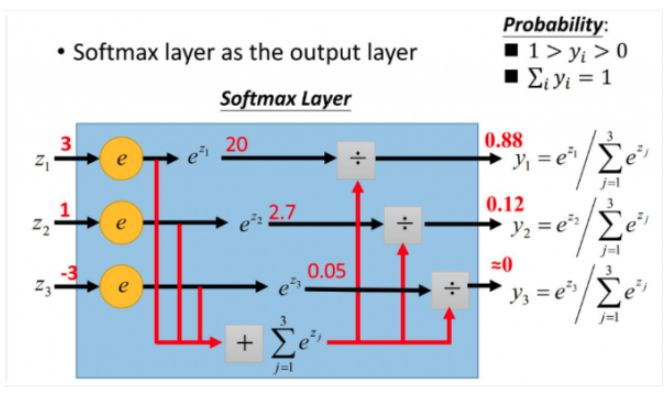

具体示例如下图:

softmax直白来说就是将原来输出是3,1,-3通过softmax函数一作用,就映射成为(0,1)的值,而这些值的累和为1(满足概率的性质),那么我们就可以将它理解成概率,在最后选取输出结点的时候,我们就可以选取概率最大(也就是值对应最大的)结点,作为我们的预测目标。

softmax相关求导

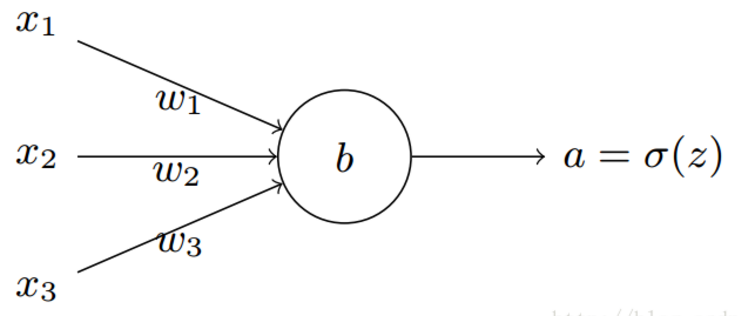

神经元结构如下图:

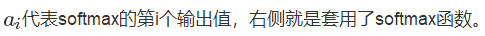

神经元的输出:

损失函数 Loss function

损失函数可以有很多形式,这里用的是交叉熵函数,主要是由于这个求导结果比较简单,易于计算,并且交叉熵解决某些损失函数学习缓慢的问题。交叉熵的函数是这样的:

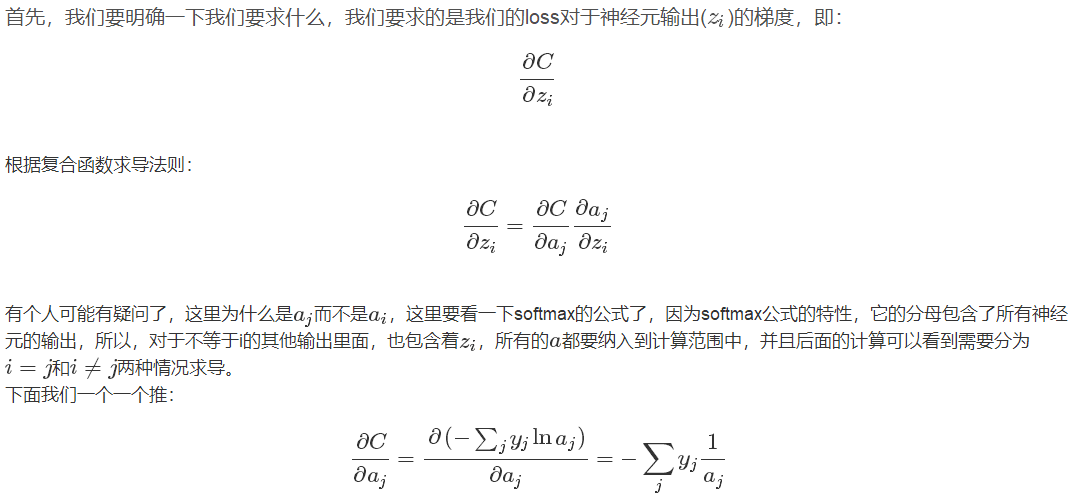

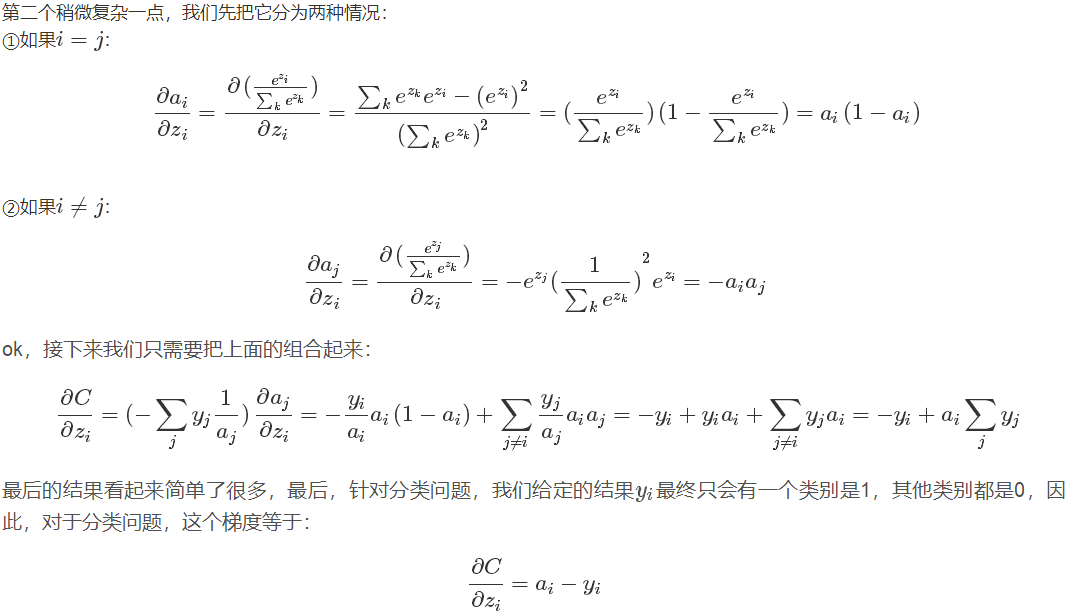

推导过程

链接:https://www.zhihu.com/question/23765351

https://blog.csdn.net/qian99/article/details/78046329