1 背景:

我有一套ELK在做日志收集,但是经常莫名其妙的出现kafka自己shutdown的问题,没有周期性,有时候几周一次,有时候几个月一次。

报错日志如下:

[2019-05-17 15:17:16,047] ERROR Failed to clean up log for __consumer_offsets-45 in dir /tmp/kafka-logs due to IOException (kafka.server.LogDirFailureChannel)

java.nio.file.NoSuchFileException: /tmp/kafka-logs/__consumer_offsets-45/00000000000000000000.log

at sun.nio.fs.UnixException.translateToIOException(UnixException.java:86)

at sun.nio.fs.UnixException.rethrowAsIOException(UnixException.java:102)

at sun.nio.fs.UnixException.rethrowAsIOException(UnixException.java:107)

at sun.nio.fs.UnixCopyFile.move(UnixCopyFile.java:409)

at sun.nio.fs.UnixFileSystemProvider.move(UnixFileSystemProvider.java:262)

at java.nio.file.Files.move(Files.java:1395)

at org.apache.kafka.common.utils.Utils.atomicMoveWithFallback(Utils.java:805)

at org.apache.kafka.common.record.FileRecords.renameTo(FileRecords.java:224)

at kafka.log.LogSegment.changeFileSuffixes(LogSegment.scala:488)

at kafka.log.Log.asyncDeleteSegment(Log.scala:1924)

at kafka.log.Log.$anonfun$replaceSegments$6(Log.scala:1987)

at kafka.log.Log.$anonfun$replaceSegments$6$adapted(Log.scala:1982)

at scala.collection.immutable.List.foreach(List.scala:392)

at kafka.log.Log.replaceSegments(Log.scala:1982)

at kafka.log.Cleaner.cleanSegments(LogCleaner.scala:580)

at kafka.log.Cleaner.$anonfun$doClean$6(LogCleaner.scala:512)

at kafka.log.Cleaner.$anonfun$doClean$6$adapted(LogCleaner.scala:511)

at scala.collection.immutable.List.foreach(List.scala:392)

at kafka.log.Cleaner.doClean(LogCleaner.scala:511)

at kafka.log.Cleaner.clean(LogCleaner.scala:489)

at kafka.log.LogCleaner$CleanerThread.cleanLog(LogCleaner.scala:350)

at kafka.log.LogCleaner$CleanerThread.cleanFilthiestLog(LogCleaner.scala:319)

at kafka.log.LogCleaner$CleanerThread.doWork(LogCleaner.scala:300)

at kafka.utils.ShutdownableThread.run(ShutdownableThread.scala:82)

Suppressed: java.nio.file.NoSuchFileException: /tmp/kafka-logs/__consumer_offsets-45/00000000000000000000.log -> /tmp/kafka-logs/__consumer_offsets-45/00000000000000000000.log.deleted

at sun.nio.fs.UnixException.translateToIOException(UnixException.java:86)

at sun.nio.fs.UnixException.rethrowAsIOException(UnixException.java:102)

at sun.nio.fs.UnixCopyFile.move(UnixCopyFile.java:396)

at sun.nio.fs.UnixFileSystemProvider.move(UnixFileSystemProvider.java:262)

at java.nio.file.Files.move(Files.java:1395)

at org.apache.kafka.common.utils.Utils.atomicMoveWithFallback(Utils.java:802)

... 17 more

[2019-05-17 15:17:16,135] INFO Stopping serving logs in dir /tmp/kafka-logs (kafka.log.LogManager)

[2019-05-17 15:17:16,139] ERROR Shutdown broker because all log dirs in /tmp/kafka-logs have failed (kafka.log.LogManager)

2 问题分析

Kafka自杀的问题我搜集了很多资料,大致上在3种情况下kafka会自己shutdown

第一种:windows操作系统兼容性不好,kafka运行在windows上不是很稳定。但是我是运行在centos上的,所以这种场景Pass。

第二种:磁盘有坏道,KAFKA_HOME/config/server.properties中log.dirs=/tmp/kafka-logs这个配置项是配置kafka日志和数据写入文件的,如果磁盘有坏道当写入有坏道的磁盘是就会挂掉,建议这种情况换一个磁盘目录。但是我是运行在AWS云平台上的,排除坏道的可能,所以该场景Pass。

第三种:高版本的kafka当并发达到一定阈值(好像是4000)或者内存资源不足时也会自己把自己shutdown。这个有可能,因为我云实例配置只有4G,闲时内存就已经所剩无几了。

解决思路:将kafka托管给supervisor,由supervisor负责监控kafka的进程,发现kafka挂掉后自动将它拉起。

3 Supervisor安装和配置

网上有成熟的攻略,按照攻略安装,装好后只需要添加一个kafka的配置。

supervisor安装:

easy_install supervisor生成基础配置:

echo_supervisord_conf > /etc/supervisord.conf修改基础配置:

vi /etc/supervisord.conf

最后添加两行

[include]

files = /etc/supervisor/*.conf

添加kafka的配置

vi /etc/supervisor/kafka..conf

[program:kafka]

command=/usr/local/kafka/bin/kafka-server-start.sh /usr/local/kafka/config/server.properties

user=root

autostart=true

autorestart=true

startsecs=10

stdout_logfile=/tmp/supervisor_kafka.log

redirect_stderr=true

4 supervisor执行报错,找原因

软件行业分析问题只能靠两种方式:经验和日志。我是supervisor的新手,没有任何经验可谈,所以只能依靠supervisor的日志系统。

supervisor的日志分为两部分:基础日志和每个服务的服务日志。

supervisor的基础日志,默认在/tmp/supervisord.log中,/etc/supervisord.conf修改位置。

每个服务自己的日志,对应到这里就是kafka的日志,默认是不打印的,需要自己配置:

vi /etc/supervisor/kafka.conf

stdout_logfile=/tmp/supervisor_kafka.log

redirect_stderr=true

从kafka报错的日志中发现是没有配置java环境!这里很奇怪我在/etc/profile和~.bashrc里都配置了java环境,而且command命令单独执行也是成功的。

原因:我的jdk是wget自己安装的,并不是操作系统自带的,上面的配置是账号登陆后bash加载的配置,但是supervisor是直接在内核中执行,所以java的环境变量配置没有生效。

解决思路很清楚了,让java环境生效

5 解决Java环境的问题

5.1 在command增加个source让java环境配置生效:

source /etc/profile ; /usr/local/kafka/bin/kafka-server-start.sh失败了,source命令找不到

5.2 直接在kafka的启动脚本中配置java环境

找到kafka的启动脚本kafka-server-start.sh

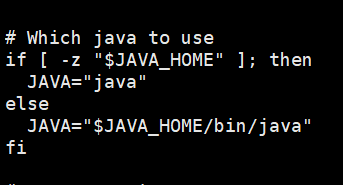

看到这里面并没有用到java命令,应该在shell脚本最后一行

exec $base_dir/kafka-run-class.sh $EXTRA_ARGS kafka.Kafka "$@"在kafka-run-class.sh中找到了Java相关的命令,确定我们找到位置了。

在kafka-run-class.sh开头添加如下几行:

export JAVA_HOME=/opt/jdk/jdk1.8.0_171

export CLASSPATH=.:$JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib/tools.jar

export PATH=$PATH:$JAVA_HOME/bin

6 验证是否生效

supervisorctl update

supervisorctl reload

supervisorctl restart kafka

问题解决,kafka成功启动

验证下supervisor是否生效

ps -ef | grep kafka找到进程 kill -9 杀掉进程

ps -ef | grep kafka看到又新生成一个进程,问题完美解决。