Learning and Transferring IDs Representation in E-commerce

Introduction

传统的编码不能很好的反应IDs之间的关系以及是高维稀疏的,因此作者提出一个基于embedding的框架来学习以及迁移IDs的表示。

最近word embedding技术深入人心,通过捕捉单词语法及语义之间的关系从而将单词映射到低维表示向量中。借鉴于word2vec,item2vec通过建模item id的交互序列中的同时出现来将id映射到低维向量上。

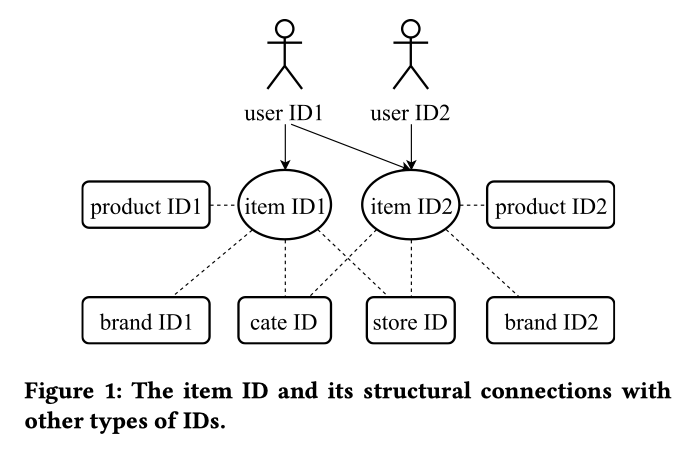

论文基于item2vec提出了一种基于embedding的框架。除了使用用户隐式反馈,也考虑了item id与其他类型的id的结构化链接,通过这些连接,在ItemID序列中的信息可以传播到其它类型的ID特征,并且可以同时学习这些ID特征的表示,框架如下图所示:

Learning IDs Representation

Skip-gram on User’s Interactive Sequences

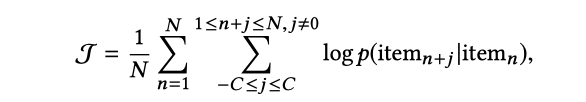

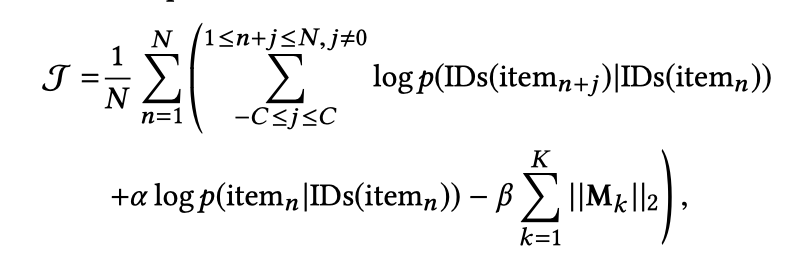

如果把每一个交互序列认为是一篇文档,那么我们可以通过Skip-Gram的方法来学习每一个item的向量。Skip-Gram的方法是最大化下面的对数概率:

在基本的Skip-Gram模型中,概率计算方式定义为如下的softmax方程:

Log-uniform Negative-sampling

当item的总数量十分巨大时,求解Skip-Gram的方法通常是负采样的方式,此时概率计算如下:

!

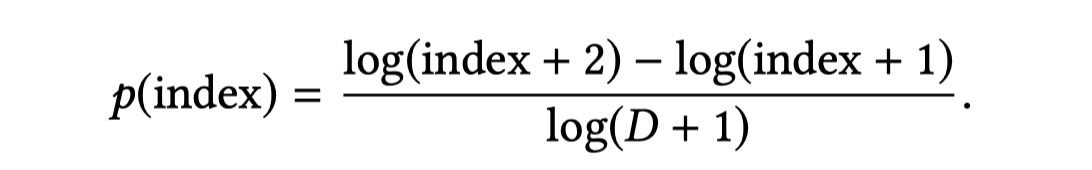

此处,负采样分布采用zipfian分布,首先将D个物品按照其出现的频率进行降序排序,那么排名越靠前的物品,其出现的频率越高。采样基于Zipfian分布,每个物品采样到的概率如下:

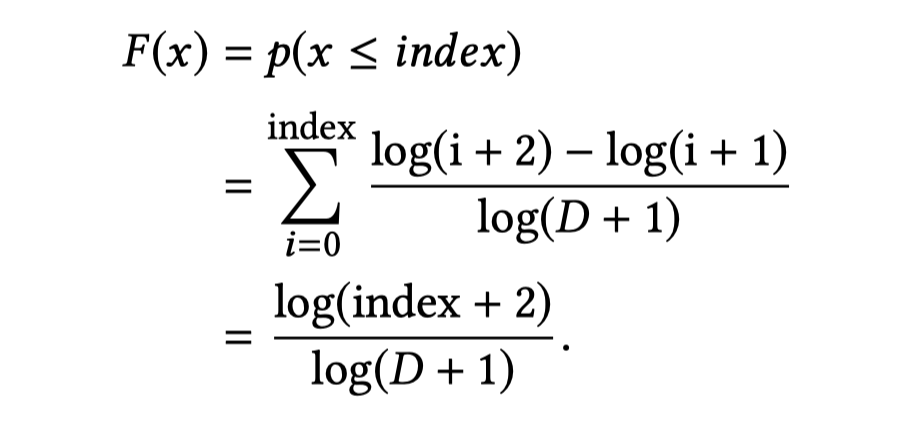

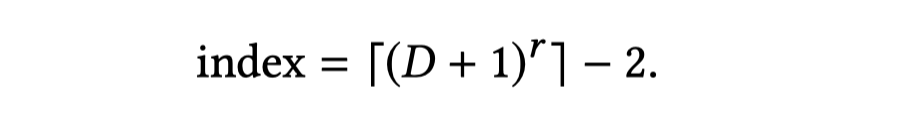

那么,该分布的累积分布函数为:

这样,当随机产生一个(0,1]之间的随机数r时,可以通过下面的转换快速得到对应的index:

IDs and Their Structural Connections

- 物品ID及其属性ID:物品item ID是电商领域的核心,每一个物品有对应的属性ID,比如产品product ID,店铺store ID,品牌brand ID,品类category ID等。

- 用户ID:用户身份可以通过ID进行识别,这里的ID可以有多种形式,如cookie、设备IMEI、用户昵称等等。

Jointly Embedding Attribute IDs

概率计算公式变为:

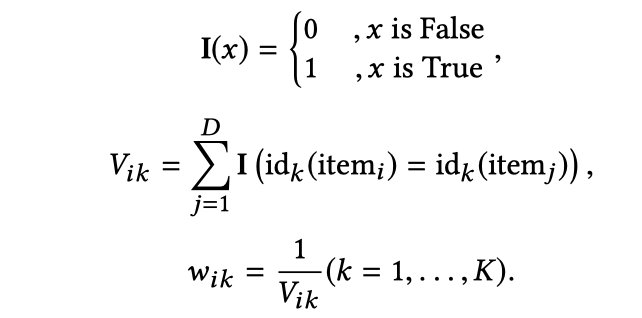

而权重的定义方式如下:

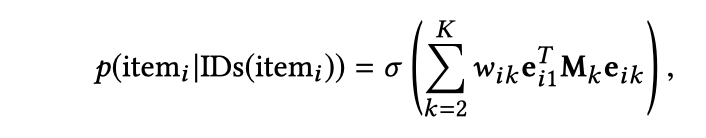

除了上面计算的item之间的共现概率外,我们还希望,属性ID和itemID之间也要满足一定的关系,简单理解就是希望itemID和其对应的属性ID关系越近越好,于是定义:

是使 转换成与 一样的维度。

损失函数如下:

Embedding User IDs

这里我们将用户交互过的item的embedding直接做平均作为用户的embedding。

DEPLOYING IDS REPRESENTATION

####Measuring Items Similarity

Transferring from Seen Items to Unseen Items

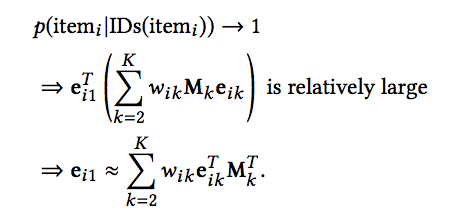

对于新的物品,无法得到其向量表示,这导致了许多推荐系统无法对新物品进行处理。但本文提出的方法可以在一定程度上解决冷启动问题。在模型训练时,我们添加了约束,即希望itemID和其对应的属性ID关系越近越好,如下式:

我们期望上面的式子越接近于1越好,因此:

那么对于新的物品,其对应的属性ID我们往往是知道的,基于其属性ID对应的向量,我们便可以近似计算新物品的向量。

实验结果也表明,这种代替方式是十分有效的。下面的表格展示了实验结果:

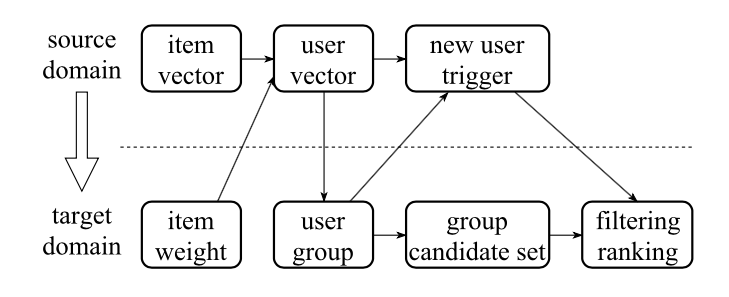

Transferring across Different Domains

第三个应用主要是针对用户冷启动,在盒马平台上,相对于淘宝平台用户数量还是少很多的。那么对于盒马平台上的新用户,我们如何进行推荐呢?过程如下:

这里,用Us表示淘宝的用户,Ut表示盒马的用户,Ui表示既是淘宝又是盒马的用户,那么进行推荐的过程如下:

1)计算淘宝用户Us之间的相似度,相似度的计算基于用户最近在淘宝交互过的T个商品的向量。可以是简单的平均,可以是加权平均。权重取决于人工的设定,比如购买是5,点击是1;

2)基于计算的用户相似度,对Ui中的用户进行k-均值聚类,这里聚成1000个类别;

3)对于每个类别,选择N个最受欢迎的盒马上的物品,作为候选集;

4)对于盒马上的一个新用户,如果它在淘宝上有交互记录,那么就取得他在淘宝上对应的用户向量,并计算该向量所属的类别;

5)基于得到的类别,将经过筛选和排序后的该类别的候选集中物品中推荐给用户。

我们对比了三种不同策略的PPM(Pay-Per-Impression)值,三种策略为:

1)推荐给新用户最热门的物品,该组为Base

2)基于简单平均的方式计算用户向量

3)基于加权平均的方式计算用户向量

实验结果表明,采用简单平均的方式,PPM提升71.4%,采用加权平均的方式,PPM提升141.8%。

Transferring across Different Tasks

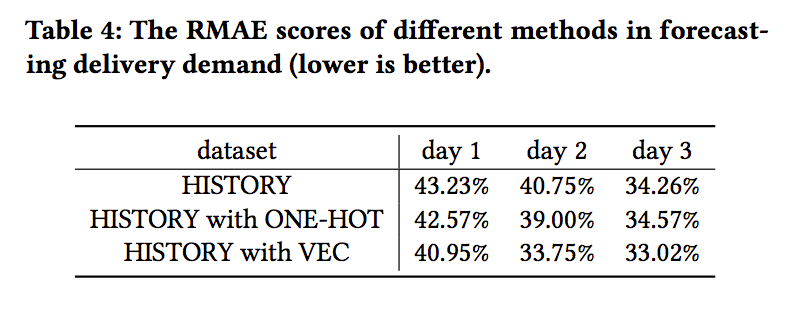

这里,我们主要对每个店铺第二天每个30分钟的配送需求进行预测,这里有三种不同的输入:

1)仅使用过去7天每三十分钟的店铺配送量作为输入

2)使用使用过去7天每三十分钟的店铺配送量作为输入 + 店铺ID的one-hot encoding

3)使用使用过去7天每三十分钟的店铺配送量作为输入 + 店铺ID对应的向量。

输入经过全联接神经网络得到配送需求的预测值,并通过RMAE指标来计算误差,结果如下: