首先论文中说到因为没有用到RNN也没有用到CNN提取特征,所以句子中没有很好的应用位置信息。所以需要在input embedding后加上Positional Encoding 。所以论文中提出了一种Positional Encoding的实现方式,下面贴出代码的实现以及讲解。

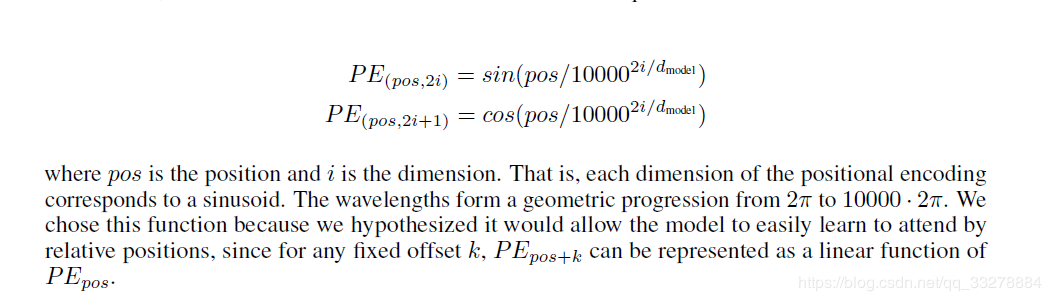

首先看下论文中提出的方式,pos为词的位置信息,dmodel为词向量embedding的维度。

最后得到的向量大小取值范围也在-1到1之间。

代码如下。

# n_position 为句子划分成字符或者词的长度,d_hid为词向量的维度。

def get_sinusoid_encoding_table(n_position, d_hid, padding_idx=None):

''' Sinusoid position encoding table '''

def cal_angle(position, hid_idx):

return position / np.power(10000, 2 * (hid_idx // 2) / d_hid)

def get_posi_angle_vec(position):

return [cal_angle(position, hid_j) for hid_j in range(d_hid)]

sinusoid_table = np.array([get_posi_angle_vec(pos_i) for pos_i in range(n_position)])

sinusoid_table[:, 0::2] = np.sin(sinusoid_table[:, 0::2]) # dim 2i 偶数正弦

sinusoid_table[:, 1::2] = np.cos(sinusoid_table[:, 1::2]) # dim 2i+1 奇数余弦

if padding_idx is not None:

# zero vector for padding dimension

sinusoid_table[padding_idx] = 0.

return torch.FloatTensor(sinusoid_table) # n_position × d_hid 得到每一个词的位置向量

原文链接:https://blog.csdn.net/qq_33278884/article/details/88868808